ChatGPT ist ein abgestimmter, geschlossener Dienst, der auf dem GPT-Modell basiert. Er hat einen großen Hype ausgelöst und verspricht, innovative und nützliche Funktionen zu ermöglichen. Er wird von MicrosoftAzure OpenAI Service genutzt.

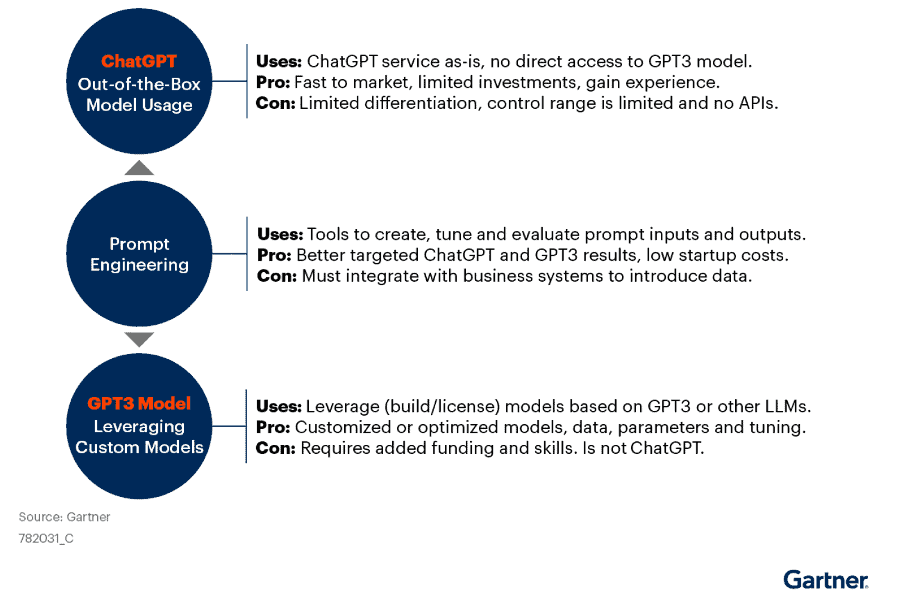

Nachfolgend beantwortet Gartner die Frage: Wie können Unternehmen ChatGPT nutzen? Es gibt drei allgemeine Ansätze zur Nutzung des OpenAI ChatGPT-Dienstes und der damit verbundenen OpenAI GPT-Modelle, mit zunehmendem Komplexitätsgrad:

- Die einfachste ist die Verwendung von Out-of-the-Box, indem man direkt Fragen stellt.

- Die Verwendung von Tools zum Erstellen, Abstimmen und Auswerten von Prompt-Inputs und Chat-Outputs.

- Den Bau von benutzerdefinierten GPT- oder anderen großen Sprachmodellen (LLM), die auf benutzerdefinierten Daten basieren, und die Manipulation der Modellparameter und Gewichte.

Außerdem sollten Planer den Unterschied zwischen OpenAI ChatGPT und Azure OpenAI ChatGPT kennen.

Details

Der OpenAI ChatGPT-Dienst bietet Nutzern verschiedene Möglichkeiten, sowohl direkt mit dem GPT-3.5-Modell als auch mit ChatGPT zu interagieren. Jede Option hat Vor- und Nachteile und kann genutzt werden, um unterschiedliche Ergebnisse zu erzielen. Abbildung 1 gibt einen Überblick über die Optionen.

Out-of-the-Box Model Usage

Diese Form der Nutzung ist die heute am häufigsten verwendete. Benutzer können die textbasierte Web-Chat-Schnittstelle (chat.openai.com) erstellen und nutzen. Derzeit gibt es keinen API-Zugang, sondern nur Zugang über Texteingabe/-ausgabe. Microsoft plant, in der Azure OpenAI-Version entsprechende APIs anzubieten. Unternehmen und Einzelpersonen können diesen Ansatz nutzen, um Inhalte zu ergänzen oder zu erstellen, Text zu manipulieren (etwa die Sprache abzuschwächen oder einen bestimmten Ton anzuschlagen) und Inhalte zusammenzufassen oder zu vereinfachen. Dies kann mit begrenzten Investitionen geschehen. Die Verwendung von ChatGPT birgt jedoch Risiken, und da viele der Nutzer keine Erfahrung haben, besteht die Gefahr, dass sie die Einschränkungen in Bezug auf Daten, Sicherheit und Analyse übersehen.

Das größte Risiko für geschäftliche Anwendungsfälle, bei denen es um die Erstellung neuer Inhalte geht, besteht darin, dass ChatGPT wortgewandte Prosa mit Antworten in natürlicher Sprache erstellt, die möglicherweise wenig wertvollen Inhalt oder sogar unwahre Aussagen enthalten. Es muß daher obligatorisch sein, dass die Benutzer die Ergebnisse auf Genauigkeit, Angemessenheit und tatsächliche Nützlichkeit überprüfen, bevor sie ein Ergebnis akzeptieren. Eine wesentliche Einschränkung besteht darin, dass das Modell weder Echtzeitdaten noch aktuelle historische Ereignisse berücksichtigt.

Das aktuelle ChatGPT-Modell wurde im Dezember 2021 trainiert und enthält keine neueren Informationen! Große Veränderungen stehen mit V4 an. Dann werden sowohl Informationen neueren Datums zur Verfügung stehen als auch die Zahl der Anzahl der Unterstützen Parameter für dramatische Veränderungen sorgen GPT-3 wurde anhand von 175 Milliarden Datenpunkten trainiert. Bei V4 gehen die Spekulationen von bis zu Angeblich soll GPT-4 mit 100 Billionen trainierten Parametern aus, was Sam Altman, Mitbegründer und CEO von OpenAI ins Reich der Fabel verweist. Klar sind jedoch signifikante Verbesserungen. Und: in mehr oder weniger Zukunft werden wir von OpenAI auch KI-Modelle sehen, die auch Video-Inhalte erstellen können.

Prompt-Engineering

Das Prompt-Engineering umfasst die Entwicklung eines systematischen Ansatzes zur Erstellung, Abstimmung und Bewertung der Ergebnisse in Bezug auf die Eingaben und Ausgaben von ChatGPT. In ChatGPT ist der Prompt das entscheidende Element, um Ergebnisse zu erzielen. Kleine Änderungen in der Wortwahl des Prompts und der Wortreihenfolge können zu erheblichen Änderungen in der Ausgabe führen. Die Eingabeaufforderung kann auch Daten enthalten, die bei der Erstellung der Antwort berücksichtigt werden sollten. Während die Erstellung von Eingabeaufforderungen eine manuelle Aufgabe sein kann, sollten Unternehmen die Automatisierung von Elementen mit hohem Nutzen/geringer Auswirkung auf das Geschäft in Betracht ziehen, etwa innerhalb von Suchleisten, Insight-Engines und anderen konversationellen Anwendungen der künstlichen Intelligenz (KI). Das Ergebnis ist, dass eine breitere Palette von Eingabeaufforderungen ausgewertet werden kann. In einigen Fällen geht dies sogar so weit, dass ein separates Lernmodell zur Optimierung der Prompts erstellt wird.

Nutzung benutzerdefinierter Modelle

Es ist nicht möglich, das GPT-Modell in ChatGPT anzupassen, da auf das GPT-Modell nicht zugegriffen werden kann. OpenAI hat jedoch das GPT3-Modell sowie andere große Sprachmodelle verfügbar gemacht. Auch Drittanbieter stellen spezielle LLMs zur Verfügung. Da die zugrundeliegenden Daten spezifisch für die Ziele sind, gibt es wesentlich mehr Kontrolle über den Prozess, was möglicherweise zu besseren Ergebnissen führt. Obwohl dieser Ansatz beträchtliche Fähigkeiten, Datenpflege und Finanzierung erfordert, könnte das Entstehen eines Marktes für spezialisierte Modelle von Drittanbietern, die für den jeweiligen Zweck geeignet sind, diese Option zunehmend attraktiver machen.

Anwendungsfälle

Grundlegend konzentrieren sich die Anwendungsfälle von ChatGPT auf die Verbesserung der Automatisierung der Inhaltserstellung und -umwandlung bei gleichzeitiger Bereitstellung einer schnellen und ansprechenden Benutzererfahrung.

Die drei in Abbildung 1 skizzierten Ansätze können die folgenden Anwendungsfälle ermöglichen: Die folgende Liste enthält einige branchenspezifische Beispiele, die die oben beschriebenen Anwendungsfälle nutzen:

- Erweiterung und Erstellung schriftlicher Inhalte – Es gibt viele Möglichkeiten, wie ChatGPT einen Textentwurf in der gewünschten Länge und im gewünschten Stil erstellen kann, der dann vom Benutzer überprüft werden kann. Zu den spezifischen Anwendungen gehören Entwürfe von Marketingbeschreibungen, Empfehlungsschreiben, Aufsätzen, Handbüchern oder Anleitungen, Schulungsleitfäden, Beiträgen in sozialen Medien oder Nachrichten.

- Beantwortung von Fragen und Auffinden von Informationen – Das Format ermöglicht es Benutzern, Antworten auf der Grundlage von Daten und Aufforderungsinformationen zu finden. Zum Beispiel: „Wie viele Meilen braucht man mit dem Auto von San Diego nach San Francisco?

- Tonfall – Sprache abmildern oder professionalisieren.

- Zusammenfassung – Ermöglicht verkürzte Zusammenfassungen von Gesprächen, Artikeln, E-Mails und Webseiten. Umwandlung in/aus Aufzählungszeichen. Die Länge der Zusammenfassung kann festgelegt werden.

- Klassifizierung und Kategorisierung von Inhalten – für Stimmungen oder Themen.

- Vereinfachung – Überschriften, Gliederungen, Extraktion von Schlüsselinhalten.

- Chatbot-Leistungsverbesserung – Mehrere Methoden können verbessert werden, einschließlich der Extraktion von Personen, der Klassifizierung der gesamten Konversation, eingebetteter Fragen und anderer. Beachten Sie, dass diese Methoden auch zur Verbesserung der Leistung anderer Anwendungen mit Benutzerinteraktion eingesetzt werden können.

- Codegenerierung, -übersetzung, -erläuterung und -verifizierung. Diese Ansätze sind zwar erst im Entstehen begriffen, aber sie sind vielversprechend, um den Entwicklungsprozess zu verbessern. Sie sind häufig in eine integrierte Entwicklungsumgebung (IDE) integriert.