Trotz der erstaunlichen Fortschritte bei der Leistung der künstlichen Intelligenz in den letzten Jahren ist keine KI perfekt. Tatsächlich wird die Unvollkommenheit einer KI in der Regel durch die Messung der Genauigkeit des Modells an einem Testdatensatz deutlich gemacht. Perfekte Ergebnisse werden weder erwartet noch sind sie üblich.

Christopher Thissen, Data Scientist bei Vectra AI, erläutert wie KI-Teams und Experten für Data Science zur Cybersicherheit beitragen können:

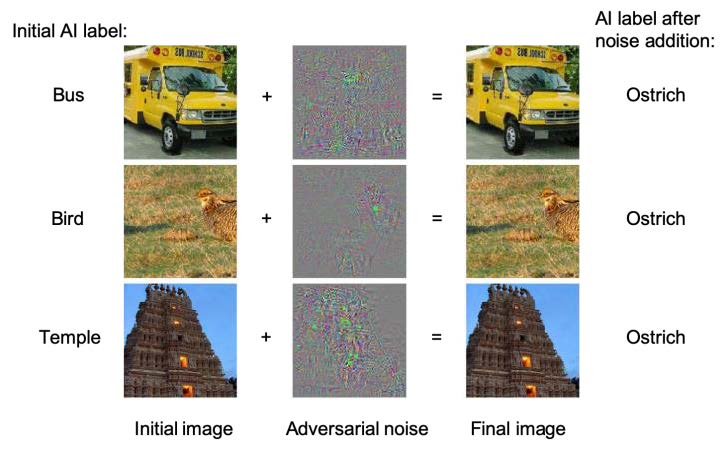

Problematisch ist, dass KI auch Fehler auf eine Weise macht, die von Tests nicht erfasst wird. Die bekanntesten Beispiele verwenden nicht wahrnehmbare Änderungen, um überraschende Bildbeschriftungsfehler zu erzeugen (Bild 1). Es gibt hoch entwickelte KI, die in der Lage ist, professionelle menschliche Spieler in komplexen Spielen wie DoTA II und StarCraft II zu besiegen. Es hat sich jedoch gezeigt, dass auch weniger erfahrene menschliche Spieler Schwachstellen ausnutzen können. Im Cyberbereich hat Skylight Cyber kürzlich einen KI-Malware-Detektor umgangen, indem es Strings an bekannte bösartige Binärdateien angehängt hat. Beunruhigend ist, dass diese Methode bei allen getesteten bösartigen Binärdateien funktionierte.

Diese Beispiele fallen unter ein im Entstehen begriffenes Gebiet des maschinellen Lernens, das als „Adverserial Attacks“ bezeichnet wird, definiert als „Eingaben in Modelle des maschinellen Lernens, die ein Angreifer absichtlich so gestaltet hat, dass das Modell einen Fehler macht“. Es gibt zwei allgemeine Antworten auf derartige Angriffe: Erstens die Erhöhung der Robustheit einer KI gegenüber gegnerischen Samples und zweitens die Ergänzung der KI durch „Defense in Depth“. Eine faszinierende Idee ist, dass einige menschliche Fähigkeiten die Fähigkeiten der KI ergänzen und dass menschliche KI-Teams Vorteile gegenüber einer der beiden Entitäten allein bieten.

Bild 1: AI labels before and after adversarial noise is added to the image .

In seinem Buch „Average is Over“ dokumentiert Tyler Cowan den frühen Erfolg menschlicher KI-Teams im Freistil-Schach. In dieser zeitbegrenzten Version des Spiels dominierten die Teams mit menschlicher KI anfänglich Teams, die nur aus KI oder nur aus Menschen bestanden (sogar gegen Gegner, die individuell viel bessere Spieler waren). In den erfolgreichsten Teams nutzten die menschlichen Spieler die intime Kenntnis ihrer KI-Teamkollegen, um Schwächen auszunutzen. Die menschlichen Großmeister hingegen verließen sich mehr auf ihr eigenes Wissen und verloren, weil sie ihre KI nicht effektiv ausnutzten. Der siegreiche Vorteil bei diesen Turnieren war die intuitive und schnelle Fähigkeit, KI-Teamkollegen zu trainieren und einzuengen.

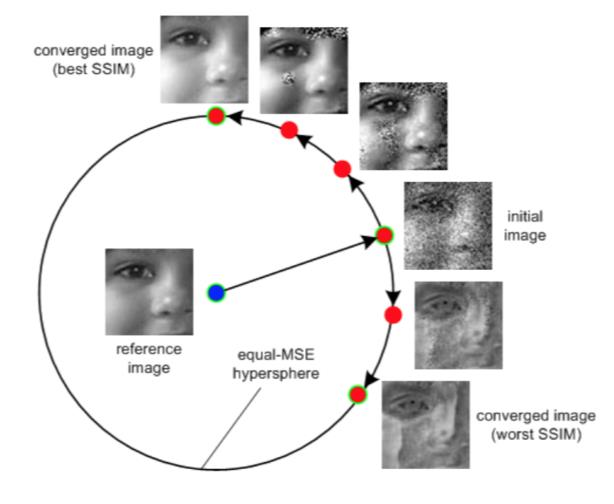

Obwohl das Interesse am Freistil-Schach mit zunehmender Stärke der KI nachgelassen hat, wächst das Interesse an der Entwicklung menschlicher KI-Teams in komplexeren Bereichen weiter. Als einfaches Beispiel würde ein Mensch die Unterschiede zwischen den gegnerischen Beispielen in Bild 2 deutlich erkennen, aber für eine KI können alle Bilder gleich verschieden vom Original erscheinen (für die gegebene Entfernungsmetrik). Ein Mensch wäre in der Lage, die Kennzeichnungsfehler in Bild 1 zu korrigieren (obwohl der Trick dann darin besteht, zu erkennen, welche Beispiele korrigiert werden müssen). In diesen Beispielen stellt ein Mensch ergänzende Fähigkeiten zur Verfügung (mit dem Vorbehalt, dass es möglich ist, kontradiktorische Bilder zu konstruieren, die sowohl Menschen als auch KI täuschen).

Bild 2: Images that appear substantially different to humans can be the same MSE distance from the original.

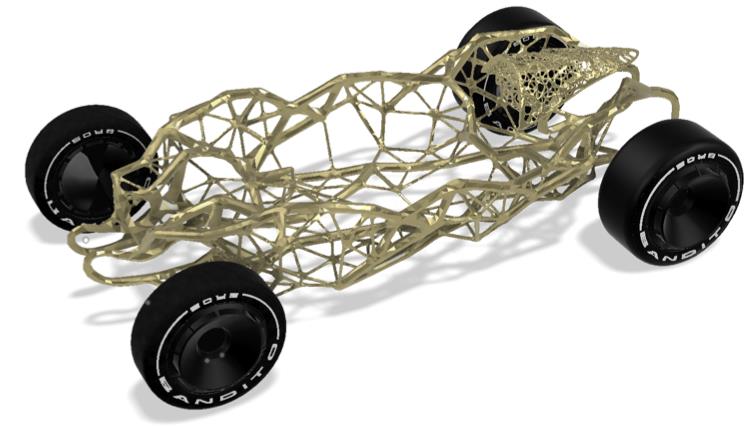

Interessanter sind vielleicht die Fortschritte, die nur möglich sind, wenn Menschen und KI auf neue Art und Weise zusammenarbeiten. Es ist immer noch unklar, wie genau sich eine solche Zusammenarbeit manifestieren würde oder welche Fähigkeiten sie freisetzen könnte, aber in anderen Bereichen entstehen provokative Beispiele. Autodesk hat zum Beispiel kürzlich ein neues Rennwagen-Chassis mit Hilfe eines menschlichen KI-Design-Teams entwickelt. Das als Hack Rod bezeichnete Team verwendete Daten, die von einem Experten-Rennteam in der kalifornischen Mojave-Wüste gesammelt wurden, darunter detaillierte Belastungen des Autos, die von über 200 Sensoren erfasst wurden, sowie ein 3D-Modell des Terrains. Ein Team aus menschlichen Konstrukteuren und generativen KIs nutzte die Daten, um ein neues, optimiertes Fahrgestell zu entwerfen, das sich dramatisch von herkömmlichen Konstruktionen unterscheidet (Bild 3).

Bild 3: Human-AI designed race car chassis. What new capabilities might creative human-AI teaming provide in the cyber domain?

Im Cyberbereich liefern das Beispiel Skylight Cyber (und die Übungen des Red Teams im Allgemeinen) entscheidendes Feedback zu Schwachstellen und Lücken in den KI-Fähigkeiten. Bei Vectra schulen Teams aus Datenwissenschaftlern und Sicherheitsforschern die KI, und SOC-Teams setzen diese KI ein, um die enormen Datenmengen zu analysieren, die für Unternehmensnetzwerke und Cloud-Umgebungen typisch sind. Gemeinsam sorgen diese Analysten-KI-Teams für eine schnellere und gründlichere Cyberverteidigung, als dies entweder der Analytiker oder die KI allein leisten könnte. Dieser Ansatz hat sich für viele Unternehmen als wertvoll erwiesen, und das Data-Science-Team bleibt weiterhin wachsam bei der Identifizierung neuer, effektiver Wege zur Nutzung der KI.