Generative KI weckt zu Recht große Erwartungen, doch ihr Einsatz ist zugleich mit erheblichen Risiken verbunden. Wie können Unternehmen verhindern, dass ihre GenAI-Anwendungen den Datenschutz verletzen, ethisch fragwürdig entscheiden oder Falschaussagen treffen?

Kaum einer Technologie wohnt eine so große disruptive Kraft inne wie generativer KI. Deren Fähigkeit, etwa Texte, Bilder und Code zu erzeugen oder bestimmte Informationen aus einer Vielzahl von Datenquellen herauszudestillieren, kann komplexe, zeitraubende Prozesse quer durch alle Branchen und Unternehmensbereiche erheblich vereinfachen und beschleunigen. Allerdings dürfen Mitarbeiter den Ergebnissen von GenAI-Anwendungen nicht blind vertrauen, denn diese können durchaus falsch liegen, ungenaue Informationen liefern oder unfaire, vorurteilsbehaftete Entscheidungen fällen. Doch was genau sind die Ursachen dafür und wie lässt sich das Risiko minimieren?

Halluzinationen und Falschaussagen verhindern

Selbst die großen Sprachmodelle, die hinter vielen GenAI-Anwendungen stecken, besitzen kein vollständiges Wissen der Welt und neigen dazu, plausibel klingende Antworten zu halluzinieren, wenn ihre Trainingsdaten in einem Bereich unzureichend waren. Da diese Modelle als Black Box agieren, ist nur schwer nachzuvollziehen, wie sie zu ihren Aussagen kommen und wann falsche Informationen ausgegeben werden. Geringer ist das Risiko bei kleineren, domänenspezifischen Modellen, die sich zwar nicht für ein breites Einsatzspektrum eignen, dafür aber über detailliertes Spezialwissen in dem Bereich verfügen, für den sie trainiert wurden. Sie benötigen zudem weitaus weniger Rechenressourcen und sind daher deutlich nachhaltiger zu implementieren als große Sprachmodelle.

Unabhängig davon, ob domänenspezifisches oder großes Sprachmodell: Ein Fine-Tuning mit eigenen Daten kann die Genauigkeit der Ausgaben verbessern und die Gefahr von Halluzinationen reduzieren. Mechanismen für die Erkennung von Inputdaten, die deutlich vom Trainingsmaterial abweichen, helfen darüber hinaus, unvorhersehbares Verhalten des Modells zu verhindern. Alternativ dazu können Unternehmen aber eigene Wissensquellen via Retrieval-Augmented Generation (RAG) in das Modell einbinden. Das Wissen zur Beantwortung von Anfragen muss dann nicht mehr aus dem Modell selbst kommen, sondern wird aus den internen Datenbanken oder Fileshares mit Dokumenten bezogen. Ein aufwendiges Re-Training oder Fine-Tuning ist nicht notwendig, und die GenAI-Anwendungen lassen sich so gestalten, dass sie ihre Ausgaben mit Quellenangaben versehen. Auf diese Weise können Mitarbeiter die KI-Aussagen bei Bedarf überprüfen.

Gerade für europäische Unternehmen kann es überdies sinnvoll sein, auf europäische KI-Modelle oder auf Open-Source-Modelle zu setzen. Diese bieten üblicherweise mehr Transparenz als amerikanische Modelle hinsichtlich der Daten und Regeln, mit denen sie trainiert wurden, und machen es zugleich einfacher, europäische Datenschutzgesetze und andere Compliance-Regelungen einzuhalten. Zudem lassen sie sich lokal auf eigenen Servern betreiben, was insbesondere für sicherheitskritische Anwendungsfälle wichtig ist, die nicht von externen Diensten abhängig sein sollen und bei denen Unternehmensdaten nicht außer Haus gelangen dürfen. Ein solches Betriebsmodell hat aber auch noch andere Vorteile: Es bringt die KI zu den Daten und nicht umgekehrt, was aufwendige und kostenintensive Datenübertragungen in die Cloud vermeidet.

Ordnung ins Datenchaos bringen

Werden KI-Modelle mit eigenen Daten trainiert beziehungsweise verfeinert, kommt es auf eine ausgewogene und hochwertige Datenbasis an. Ohne diese kann das Modell keine korrekten Ausgaben generieren und es besteht das Risiko, dass Entscheidungen unfair oder diskriminierend sind und Inhalte existierende Stereotype enthalten. Für solche verzerrten Informationen reicht es unter Umständen schon, dass das Trainingsmaterial veraltet ist und nicht mehr aktuellen kulturellen und gesellschaftlichen Standards entspricht oder dass redundante Daten für eine zu starke Gewichtung in die eine oder andere Richtung sorgen.

Bei der Auswahl und Bereitstellung geeigneter Trainingsdaten stehen Unternehmen allerdings oft vor der Herausforderung, dass sich ihre Datenbestände über unterschiedliche Datenbanken, Anwendungen und Fileshares auf verschiedenen Speichersystemen oder in der Cloud verteilen. Dadurch fehlt ihnen der Überblick, sodass viel Zeit mit der Suche nach Daten verschwendet wird. Teilweise verhindern eingeschränkte Zugriffsmöglichkeiten deren Nutzung gleich ganz. Letztlich benötigen Unternehmen einen neuen Ansatz beim Datenmanagement, um strukturierte und unstrukturierte Daten über alle Systeme und Speicherorte hinweg einheitlich ansprechen zu können.

Gelingt ihnen das, werden komplexe Daten-Pipelines überflüssig, und auch die Etablierung einer modernen Data Governance fällt leichter. Diese regelt, wer die Verantwortung für Datenbestände trägt, wer auf sie zugreifen darf und wie sie verwendet werden dürfen. Auch Datenschutzfragen fallen in den Bereich der Data Governance. Hier geht es nicht nur darum, eine datenschutzkonforme Verarbeitung personenbezogener Daten sicherzustellen, sondern ebenso eine eventuelle Anonymisierung oder Pseudonymisierung, um falsche Korrelationen oder personenbezogene Informationen in den Ausgaben der KI zu verhindern.

Fehlt es an geeignetem Trainingsmaterial, lassen sich KI-Modelle mit synthetischen Daten trainieren – das sind in Simulationen oder durch andere KI-Modelle erstellte Informationen, die reale Daten nachahmen. Diese müssen allerdings gründlich verifiziert werden, um zu vermeiden, dass die Datenvielfalt leidet, die Daten zu allgemein oder verzerrt sind. Das Ergebnis wären sonst weniger genaue, zuverlässige und nützliche Ausgaben bis hin zum sogenannten Modellkollaps, bei dem das Modell kaum noch brauchbare Inhalte liefert. Zwar können auch mit echten Daten trainierte Modelle allmählich degenerieren, etwa wenn Datenquellen wegfallen oder sich verändern. Mit synthetischen Daten trainierte Modelle sind jedoch deutlich anfälliger für diese Phänomen.

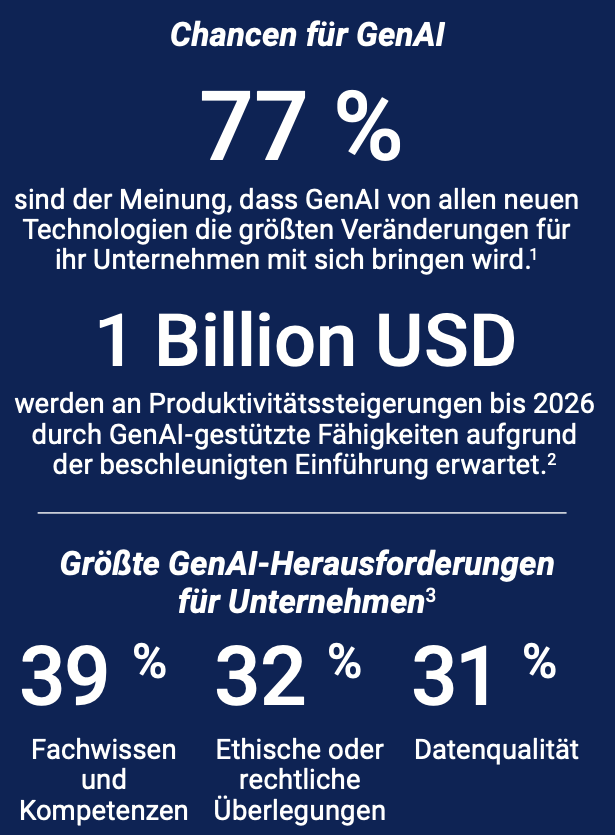

Generative KI bietet Unternehmen große Chancen, hält aber auch einige Herausforderungen bereit, darunter die Qualität der verwendeten Daten (Quelle Grafik: Dell Technologies, Quelle Zahlen: KPMG, IDC, ESG)

Leitplanken setzen

Fehlerhafte Ausgaben drohen allerdings nicht nur aufgrund unzureichender oder schlecht ausgewählter Trainingsdaten. Auch absichtliche Manipulationen der Trainingsdaten, Data Poisoning genannt, können die Ausgaben verfälschen, und das auf ganz unterschiedliche Art und Weise. So kann das Modell ganz allgemein oder nur in einem einzelnen Bereich geschwächt werden und ungenauere Antworten liefern oder aber bei bestimmten Eingaben einen vom Angreifer gewünschten Output generieren.

Verhindern lässt sich das durch ganzheitliche Sicherheitskonzepte, die jedoch nicht spezifisch für GenAI, sondern grundsätzlich für IT-Umgebungen notwendig sind. Diese umfassen den physikalischen Schutz der Systeme und Security-Basics wie sichere Passwörter und Multifaktor-Authentifizierung. Hinzu kommen moderne Zero-Trust-Konzepte mit Mikrosegmentierungen im Netzwerk, einer Rechtevergabe nach dem Least-Privilege-Prinzip und einer konsequenten Verifizierung aller Zugriffe. Ergänzend dazu zeigen Verhaltensanalysen ungewöhnliche Datenaktivitäten auf und helfen, unerwünschte Veränderungen des Trainingsmaterials zu erkennen.

Neben den Trainingsdaten kann auch das KI-Modell selbst angegriffen werden, etwa durch Jailbreaking und Prompt Injections. Dabei handelt es sich um geschickt formulierte Anfragen, die das Modell dazu bringen sollen, unangemessene, vertrauliche oder gefährliche Inhalte auszugeben, beispielsweise diskriminierende Aussagen, interne Daten oder schädlichen Code. Unternehmen sollten daher als Guardrails bezeichnete Schutzmechanismen implementieren, die sowohl die Eingaben als auch die Ausgaben überprüfen. Sie verhindern unter anderem, dass die KI gezwungen wird, themenfremde Anfragen oder bekannte Jailbreaking-Prompts zu bearbeiten, oder zum Gebrauch von Schimpfworten verleitet wird.

Der KI nicht blind vertrauen

Sorgfältig umgesetzt, liefert generative KI sehr gute Ergebnisse und kann viele Aufgaben automatisiert bearbeiten. In einigen, unkritischen Bereichen lassen sich die Ausgaben und Entscheidungen daher ohne weitere Kontrollen verwenden. Allerdings sollten Unternehmen vorab eine Risikobewertung vornehmen und mögliche juristische Folgen abklären. Das gilt ganz besonders für Bereiche, in denen eine vorherige Kontrolle der konkreten Ausgaben gar nicht möglich ist, etwa bei einem Chatbot auf der Website oder einem Sprachbot in der Telefonhotline. Sie sollten im Zweifelsfall lieber einen menschlichen Mitarbeiter hinzuziehen, wenn sie nicht weiter wissen oder keine eindeutige Antwort liefern können.

Überall dort, wo Entscheidungen in sicherheitskritischen Bereichen gefällt werden müssen, sensible Lebensbereiche von Menschen betroffen sind oder es Ermessensspielräume gibt, sind Mitarbeiter ohnehin unerlässlich. Da fehlerhafte Entscheidungen oder Texte mit Falschinformationen ein Sicherheits- und Geschäftsrisiko darstellen, ist es ihre Aufgabe, die von der KI gelieferten Informationen zu überprüfen, zu bewerten und gegebenenfalls anzupassen. Generative KI dient lediglich als Werkzeug, das Mitarbeiter unterstützt, ihnen Arbeit abnimmt und sie zu schnelleren und besseren Entscheidungen befähigt. Diese müssen sie aber weiterhin selbst treffen und auch die Verantwortung dafür tragen – ein KI-Modell kann das nicht.