In einer kürzlich durchgeführten Reihe von Tests mit verschiedenen Disziplinen hat Googles neueste KI-Sprachmodell Gemini OpenAIs ChatGPT-4 um drei Prozent übertroffen.

Die Tests wurden durchgeführt, um die Leistungsfähigkeit der KI-Modelle in einem breiten Spektrum von Aufgaben zu bewerten, darunter Textverständnis, Generierung von menschenähnlichem Text, Fähigkeit zur Beantwortung von Fragen und Kontextverständnis. Gemini und ChatGPT-4 wurden dabei einer Vielzahl von Szenarien ausgesetzt, um ihre Fähigkeiten in verschiedenen Kontexten zu bewerten. Stocklytics hatte darüber zuerst berichtet.

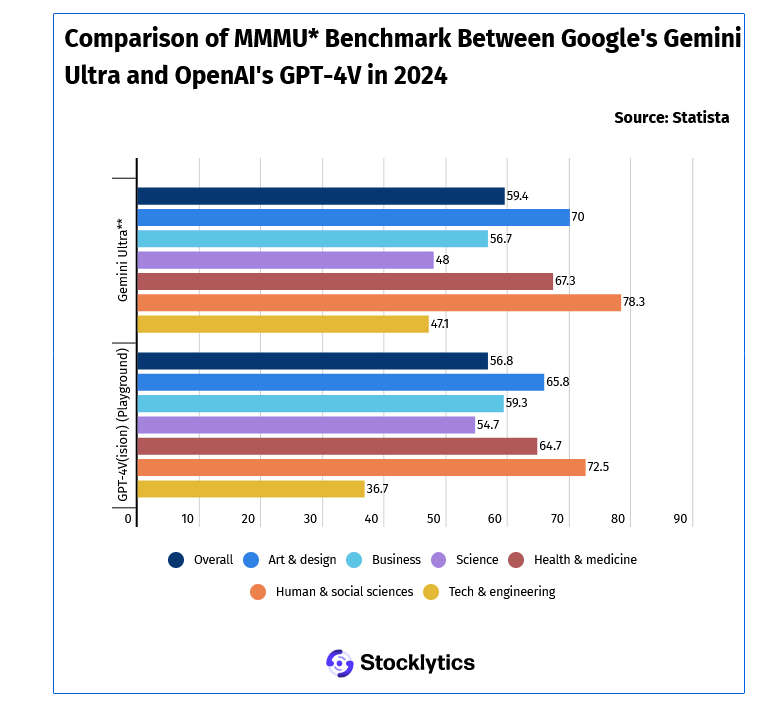

Gemini Ultra übertraf GPT-4 im MMMU-Benchmark-Test in den folgenden Fächern: Kunst und Design (47,1), Gesundheit und Medizin (67,3), Human- und Sozialwissenschaften (78,3) sowie Technik und Ingenieurwesen (47,1). Nur in Wirtschaft und Naturwissenschaften schnitt der GPT-4 besser ab. Der sogenannte Massive Multi-disciplin Multimodal Understanding and Reasoning Benchmark (MMMU) wurde konzipiert, um multimodale Modelle in umfangreichen multidisziplinären Aufgaben zu bewerten, die Fachwissen auf Hochschulniveau und kritisches Denken aus den Bereichen Kunst und Design, Wirtschaft, Wissenschaft, Gesundheit und Medizin, Geistes- und Sozialwissenschaften sowie Technik und Ingenieurwesen erfordern.

Die Stocklytics-Finanzanalystin Edith Reads kommentierte die Ergebnisse: „Gemini hat seit seiner Vorstellung in der KI-Gemeinschaft für viel Aufsehen gesorgt. Die robuste Infrastruktur, die von Googles speziell entwickelten Tensor Processing Units angetrieben wird, ermöglicht effizientes Training und Einsatz und treibt den Fortschritt bei Echtzeitanwendungen voran. Die technischen Innovationen, die Gemini antreiben, gehen über die Sprachverarbeitung hinaus und bieten eine bemerkenswerte Leistung bei der Verarbeitung von Bildern, Videos und Audio.“

Gemini hat in diesen Tests beeindruckende Leistungen gezeigt. Mit einer verbesserten Fähigkeit, Kontext zu verstehen und natürliche Sprache zu generieren, hat es sich als vielseitig und leistungsstark erwiesen. Im Zuge eines anderen Tests, dem MMLU-Tests (Massive Multitask Language Understanding), hat es Experten in Bereichen wie Mathematik, Physik, Geschichte, Recht, Medizin und Ethik übertroffen. Dieser Test ist ein Benchmark, mit dem sich das Allgemeinwissen und die Problemlösungs-Skills von Sprachmodellen beurteilen lassen. Hier erreichte Gemini ein Scoring von 90 Prozent.

ChatGPT4: OpenAI unter Druck?

OpenAI’s ChatGPT4, das Schwergewicht in der KI-Sprachmodellierung, wurde ebenfalls in diesen Tests getestet. Während es auch weiterhin beeindruckende Leistungen zeigte, konnte es dennoch nicht mit dem Tempo von Gemini mithalten. Die Ergebnisse zeigen, dass der Wettbewerb in der KI-Entwicklung immer intensiver wird und dass auch etablierte Modelle sich weiterhin verbessern müssen, um mit neuen Entwicklungen Schritt zu halten.

Diese dokumentierte Überlegenheit von Gemini gegenüber ChatGPT-4 könnte weitreichende Implikationen für verschiedene Anwendungsgebiete. Von der Kundeninteraktion bis hin zur automatisierten Content-Erstellung könnte Gemini neue Möglichkeiten für die Integration von KI in verschiedene Branchen eröffnen. Fraglich ist aber, ob Gemini an die Strahlkraft von OpenAI herankommt. Zumal ChatGPT für viele Verbraucher und Unternehmen den Goldstandard schlechthin in der generativen KI darstellt.

Benchmarks sind keine Garantie

Diese Ergebnisse sind ohnehin mit Vorsicht zu genießen. Benchmarks werden nicht ohne Grund in der Forschung immer wieder diskutiert. Es wird argumentiert, dass die Tests oft nicht die tatsächlichen Fähigkeiten und Grenzen von KI-Systemen erfassen und zu irreführenden Schlussfolgerungen über ihre Sicherheit und Zuverlässigkeit führen können. Sie spiegeln möglicherweise nicht wider, wie KI-Systeme mit Menschen oder anderen Systemen in komplexen und dynamischen Umgebungen interagieren.