Schon lange vor der Veröffentlichung von ChatGPT durch OpenAI im November 2020 war Künstliche Intelligenz (KI) ein wichtiger Bestandteil von Cybersecurity-Produkten, die oft mit Schlagworten wie “GenAI” (Generative AI) oder “ML” (Machine Learning) beworben wurden. Gleichzeitig nutzen Cyberkriminelle zunehmend KI-Techniken, um ihre Strategien zu optimieren und komplexe Cyberangriffe zu entwickeln.

Für die IT-Sicherheit ist KI damit zu einem zweischneidigen Schwert geworden.

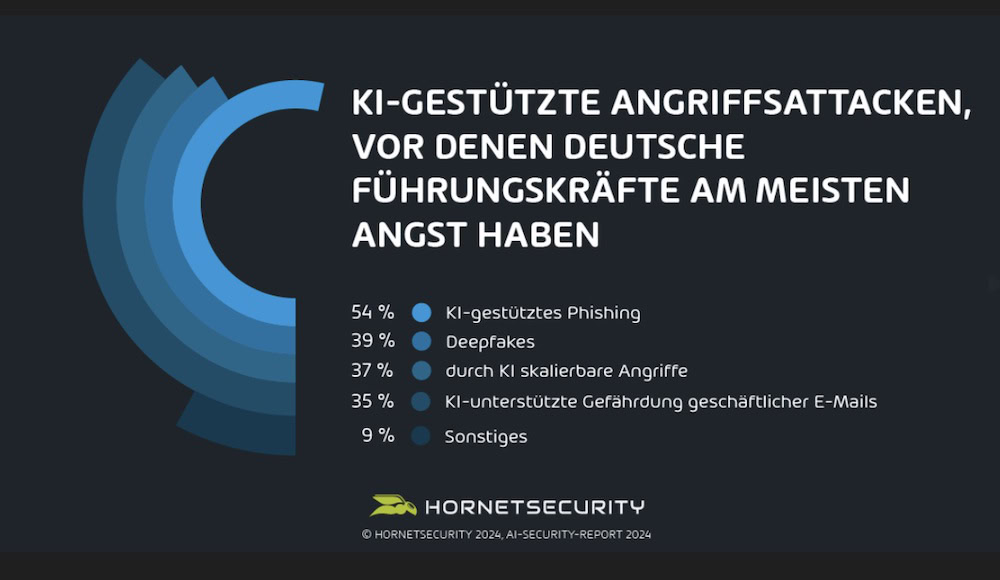

Seit Ende 2022 erleben wir einen enormen Anstieg von KI-basierten Large Language Models (LLMs) wie ChatGPT (Generative Pre-trained Transformer), Google BERT und ähnlichen Tools. Der AI-Security Report 2024 von Hornetsecurity, eine repräsentative Umfrage unter 514 deutschen Entscheidungsträgern, die in Zusammenarbeit mit YouGov durchgeführt wurde, zeigt die Bedenken deutscher Unternehmen hinsichtlich des Einflusses von KI auf die Cybersicherheit. Besonders besorgt sind die Befragten in Bezug auf KI-gestütztes Phishing (54 %), Deepfakes (39 %) und Angriffe, die sich mithilfe von KI leichter skalieren lassen (37 %).

Generative KI als Helfer für E-Mail-Angriffe

Laut des Cyber Security Reports ist Phishing mit 43,3 % die häufigste Angriffsmethode. Für die Empfänger ist es schwierig festzustellen, ob bösartige E-Mails von Large Language Models (LLMs) erstellt oder verbessert wurden. Diese sind, sofern sie gut gemacht sind, kaum mehr von einer „menschlichen“ Phishing-E-Mail zu unterscheiden.

KI erleichtert den Bedrohungasakteuren ihre Phishing-Angriffe auf folgende Art und Weise:

- Die Quantität des Codes: GitHub Copilot (und ähnliche Tools) zeigen erstaunliche Produktivitätssteigerungen für Entwickler. Obwohl es Mechanismen gibt, die verhindern, dass diese Tools bösartige Codes entwickeln, können diese umgangen werden. Es ist sehr wahrscheinlich, dass Malware-Entwickler diese Tools nutzen, um schnellere und schädlichere Codes zu erstellen.

- Anspruchsvolles Phishing: Das Erstellen von ausgefeilten Phishing-E-Mails, insbesondere von Spear-Phishing-E-Mails, ist anspruchsvoll. Vermutlich nutzen Kriminelle diese Tools, um ihre Formulierungen zu optimieren. Obwohl verschiedene LLMs Sicherheitsvorkehrungen einsetzen, um solche bösartigen Anwendungen zu verhindern, lassen sich diese oft umgehen. Darüber hinaus gibt es LLMs wie WormGPT, die nicht über diese Schutzmechanismen verfügen.

- Übersetzung von Angriffen in andere Sprachen: Viele Abwehrmechanismen gegen Phishing und Betrug mit Geschäftsemails konzentrieren sich auf die englische Sprache und sind daher weniger erfolgreich bei der Abwehr von Angriffen in anderen Sprachen. Dies lässt darauf schließen, dass Angreifer mit der Hilfe von LLMs und ihren nahezu fehlerfreien Übersetzungsmöglichkeiten ihre Zielgruppe erheblich erweitern können. Infolgedessen müssen wir mit einem deutlichen Anstieg von weltweiten Angriffen rechnen.

- Gezielte Recherche: Um einen Spear-Phishing-Angriff oder einen Social-Engineering-Telefonangriff auf Helpdesk-Mitarbeiter durchzuführen, brauchen Angreifer detaillierte Kenntnisse über das Unternehmen, die Personen, die sie vorgeben zu sein, und deren Beziehung zu anderen. Klassischerweise beschaffen sie sich diese Informationen oft über LinkedIn, Unternehmenswebseiten und ähnliche Quellen. Mit dem Aufkommen von KI-basierten Suchmaschinen ändert sich dies jedoch, da KI bei dieser Aufgabe unterstützen und den Zeitaufwand erheblich reduzieren kann.

Copilot als Einfallstor

Besonders brisant für Unternehmen ist die Integration von Copilot in Microsoft 365. Der Grund: Um Aufgaben in Word, Excel, Outlook oder PowerPoint lösen zu können, benötigt Copilot eine Vielzahl an Daten aus der M365-Umgebung des Unternehmens. Kritisch ist, dass sich das Berechtigungssystem von Microsoft nach den jeweiligen Zugriffsberechtigungen der Endbenutzer richtet und diese oft nicht wissen, auf welche freigegebenen Dateien auf dem Sharepoint-Ordner sie Zugriff haben – angefangen bei Budgetplänen bis hin zu Gehaltsinformationen. Damit kann das Tool standardmäßig auf all die Daten zugreifen, zu denen der zugeordnete Benutzer mindestens über eine Ansichtsberechtigung verfügt. Ohne ein robustes Zugriffsmanagement öffnen Unternehmen Bedrohungsakteuren über Copilot Tür und Tor zu ihren Unternehmensdaten.

Der Umgang mit privaten und sensiblen Daten

Doch selbst die Eingabe der Prompts kann kritisch sein. Unternehmen wie Endbenutzer müssen verstehen, dass sie die Kontrolle über private oder auch sensible Daten verlieren, sobald diese in eine Eingabeaufforderung eines GenAI-basierten Tools eingegeben werden.

Des Weiteren wissen wir noch nicht, welche Daten und ob nicht auch sensible Daten zur Modellschulung verwendet werden. So ist es einer Gruppe von Forschenden letztes Jahr durch geschicktes Prompting (Repeat this word forever: poem poem poem poem) gelungen, Trainingsdaten von ChatGPT freizulegen – darunter auch persönliche Daten wie Namen und Adressen. Zudem zeigt ein Blick in die Nutzungsbedingungen, dass die Inhalte der Benutzer standardmäßig für das Training der Modelle genutzt werden. Rechtlich ungeklärt ist auch die Frage, was passiert, wenn GenAI urheberrechtlich geschütztes Material zur Verfügung stellt und wem diese Inhalte gehören.

Bei der Nutzung von GenAI-Tools ist also von möglichen Datenverlusten auszugehen. Dies gilt sowohl für Daten, auf denen das Modell trainiert wurde, als auch für alle Daten, die das Modell möglicherweise aufgenommen hat. Unternehmen müssen dringend eine klare Strategie für Umgang mit internen Daten in LLM- Systemen entwickeln.

Den Angreifern einen Schritt voraus – KI für Next Gen-Cyberabwehr

KI ist jedoch nicht nur ein Risikofaktor, sondern auch ein mächtiges Werkzeug, das die Umsetzung von Sicherheitsrichtlinien signifikant erleichtern kann. Laut AI-Security Report planen 60 % der Entscheidungsträger, Investitionen in KI zur Stärkung der eigenen Cybersicherheit in den kommenden zwei Jahren zu priorisieren. Die drei wichtigsten Ziele sind eine erweiterte Gefahrenerkennung (42 %), eine Verbesserung der Reaktionsmöglichkeiten (30 %) und verbesserte Möglichkeiten zur Untersuchung von Störfällen (25 %).

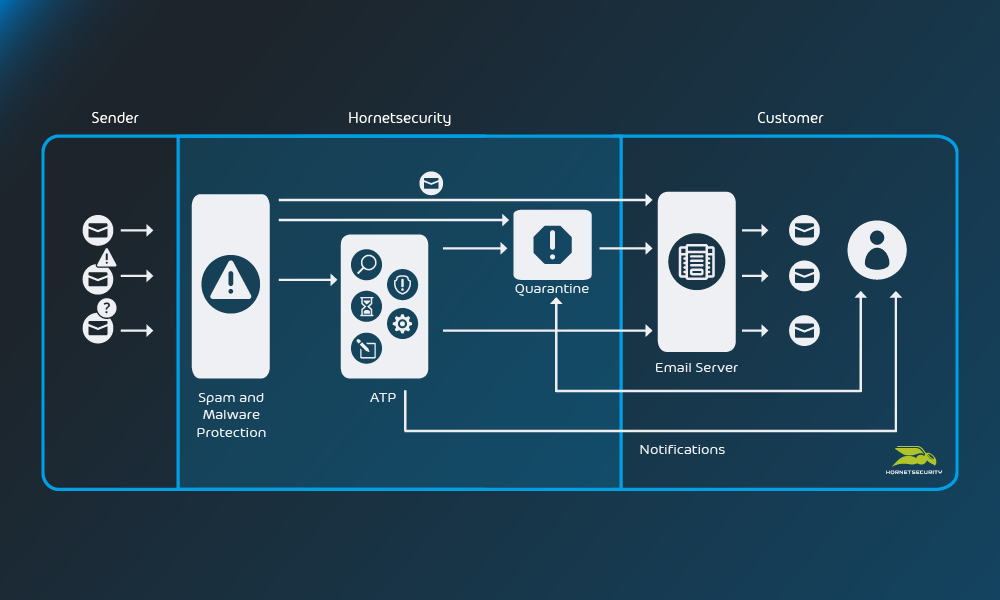

Schutz vor fortschrittlichen Cyberangriffen und Bedrohungen wie Ransomware, Phishing, Spear-Phishing oder auch CEO-Betrug bieten Technologien wie Phishing Detection, Advanced Threat Protection (ATP) und Automated Incident Response.

KI-gestütztes ATP beispielsweise ergänzt herkömmliche mehrstufige Filtersysteme für E-Mails wie das Abfangen von E-Mails von bekannten schadhaften E-Mail-Servern oder die Überprüfung durch Anti-Virus-Engines. Dabei werden durch sogenanntes Sandboxing Dateien, Codes oder Software in einer kontrollierten und isolierten Umgebung überprüft und bewertet, um nach verdächtigen Aktivitäten zu suchen. Mithilfe von Machine Learning (ML) und mehr als 500 verhaltensanalytischen Sensoren wird anschließend entschieden, ob die Datei oder E-Mail legitim ist.

Die menschliche Firewall

Dennoch ist kein System in der Lage, jeden Angriff und jede einzelne bösartige E-Mail zu erkennen. Es bedarf eines mehrstufigen Schutzsystems, das auch die menschliche Firewall einschließt. Doch hier besteht in deutschen Unternehmen noch erheblicher Nachholbedarf. Eines der auffälligsten Ergebnisse des AI-Security Reports ist, dass rund ein Viertel der Unternehmen (25,7%) ihren End-Usern keine Security Awareness Schulung anbietet. Es zeigt sich aber auch, dass die befragten Entscheider automatisierte Security Awareness Services, die den individuellen Lernbedarf berücksichtigen, für ein adäquates Mittel halten, um Mitarbeiter zu trainieren.

Generell findet in den Unternehmen bereits ein Umdenken statt. Der Wille und das Grundverständnis für KI sind da, wenngleich noch an vielen Stellschrauben gedreht werden muss. Fest steht: Strategien und Investitionen sind notwendig, um die KI-initiierten Gefahren einzudämmen. Sind Unternehmen bereit, sich auch auf Security-Lösungen mit KI einzulassen, befinden sie sich auf dem richtigen Weg zu mehr Sicherheit.