Welche Entwicklung nimmt die Mensch-Maschine-Kommunikation in den nächsten Jahren? Welche Potentiale werden sich noch ergeben? Welche Rolle spielen Conversational User Interfaces. Welche Einsatz-Szenarien lassen sich sinnvoll unterstützen? Was ist mit KI möglich, und wo liegen die Grenzen?

Im Folgenden werden zentrale Aspekte beschrieben, die aufzeigen, dass Chatbots künftig nicht nur reaktiv antworten, sondern auch proaktiv handeln können.

Conversational User Interface wird zum Standard

In 3-5 Jahren ist es soweit: überall werden wir Chatbots nutzen, weil die Grundlage – das Conversational User Interface (CUI) – zum Standard in der Kommunikation mit dem Computer geworden ist. Bereits heute gibt es eine Reihe von Szenarien, die deutlich machen, wie rasch die Entwicklung voranschreitet: Die Konversation in Textform hat viele Gesichter – von der Eingabe bei MS Office auf die Frage „Was möchten Sie tun?“ über die Anzeige von Synonymen im Textverarbeitungsprogramm bis hin zu den vielfältigen Frage-Antwort-Ketten, die klassische Chatbots heute bieten. Aber auch Voice Bots oder virtuelle Sprachassistenten gewinnen durch moderne CUIs an Qualität und lassen sich so immer nutzbringender einsetzen. So lassen sich Reservierungen tätigen, einfache Versicherungen abschließen oder man erhält bedarfsgerechten Support.

Heute leuchtet das Display der Spülmaschine und weist auf den Fehler E407 hin. Heute schauen Endkunden in der Gebrauchsanweisung nach, was hier zu tun ist oder googlen die Fehlermeldung und -behebung. Morgen zeigt das Gerät selbst die Schritte an, um den Fehler zu diagnostizieren und zu beseitigen. Übermorgen steuern wir diese Schritte per Sprachbefehl bzw. auf Knopfdruck und die Maschine führt sie selbstständig aus. Der nutzbringende Einsatz von Chat- bzw. Voicebots bis hin zum aktiven Tun der Maschine ist keine Zukunftsmusik mehr.

Der Zwischenschritt (das Anzeigen von Handlungsanweisungen) ist bei einigen Szenarien längst Realität: So lösen Autofahrer im Falle eines Unfalles oder einer Panne durch Betätigen des Breakdown-Alarms automatisch eine Reihe von Services aus: Diese laufen im Hintergrund, zum Beispiel die Ortung des Fahrzeugs, die interaktive Tele-Diagnose und Fehlerbeseitigung, der Einsatz von mobilen Servicetechnikern, Abschleppservices oder die Reparatur in zertifizierten Werkstätten. Die Kommunikation erfolgt dabei situationsgerecht „intelligent“.

Dabei handelt es sich hier nicht einfach um „KI“. Vielmehr ist es hinterlegtes Expertenwissen zu den jeweils bekannten Fehlersituationen. KI im Sinne von Machine Learning kann nicht einfach Lösungen kreieren, zumal diese sich ja auch an den rechtlichen Bedingungen des jeweiligen Landes orientieren müssen. Und zudem kann die heute für das „Verstehen von Sprache“ eingesetzte KI auch noch keine sinnvollen mehrstufigen Dialoge führen.

KI entwickelt sich evolutionär

Betrachtet man die Nutzung von KI im Bereich Chatbots, dann geht es nicht nur um die Umwandlung von Sprache in Text, sondern in erster Linie um das Sprachverständnis. Bis vor etwa 2 Jahren gab es stetig größere Fortschritte, aber aktuell ist ein Plateau erreicht – und die nächste Stufe ist noch nicht absehbar.

Beispielsweise gibt es den SQuAD-Test (Stanford Question Answering Dataset), der insgesamt 150.000 Fragen umfasst, die man alle aus Wikipedia heraus beantworten kann. Bei der Frage „Wodurch kommt es zustande, dass der Regen fällt“ – verweist die Maschine auf geeignete Wikipedia-Artikel und hebt zentrale Begriffe wie „Gravitation“ besonders hervor. Im Rahmen umfangreicher Tests gehoben konnten Systeme dabei in 51 % der Fälle korrekt Auskunft geben, Menschen erreichten knapp 90 % richtige Antworten. Bereits 3 Jahre später, 2019, erreichten die Maschinen das menschliche Niveau, stagnieren jedoch seitdem bei etwa 93%. Daraus lässt sich ableiten, dass Maschinen bei speziell trainierten Aufgaben inzwischen gleich gut oder etwas besser als der Mensch sind.

Aber je allgemeiner die Aufgabe, desto mehr Schwächen weist KI noch auf. Zum Beispiel enthält das Sprachverarbeitungsmodell GPT-3 ca. 175 Milliarden Parameter und wurde mit Texten aus dem gesamten Internet gefüttert. Die Wissensbasis ist sehr breit gefächert, und das System liefert in vielen Fällen eine hochwertige Klassifikation das im Kontext Erwartbare. Aber ein bestimmtes Ziel vorzugeben und dies Schritt für Schritt zu erreichen, gestaltet sich bei GPT-3 schwieriger als bei einem speziell trainierten Chatbot.

Die Erfahrung der letzten Jahre hat gezeigt, dass man zudem das Datenvolumen und den Rechenaufwand exponentiell erhöhen muss, um leichte graduelle Fortschritte zu erzielen. Das wird auf Dauer – auch aufgrund der Klimaauswirkungen – nicht funktionieren. Hier benötigen wir eine neue Technik, um entscheidend weiter voranzukommen.

Im Oktober 2021 stellte Google mit Pathways eine neue multimodale KI-Architektur vor. Dieses Modell ermöglicht es, auf mehrere Sinne wie Text, Bild und Sprache zu reagieren.

Laut Google soll das Modell nicht nur eine Einzelaufgabe erledigen können, sondern über verschiedene Fähigkeiten verfügen, die je nach Bedarf abgerufen und zusammengefügt werden können, um neue, komplexere Aufgaben zu erfüllen. Als Beispiel nennt Google hier eine Höhenabschätzung der Landschaft auf Grundlage von Luftbildern. Diese könnte dann auch dazu genutzt werden, um Flutrisiken besser einschätzen zu können.

An einem ähnlichen multimodalen KI-Modell arbeitet derzeit das Heidelberger Start Up Aleph Alpha.

Es ist daher heute nicht absehbar, dass es in den nächsten Jahren eine „KI“ gibt, die verlässlich und mit ausreichend niedrigem Aufwand einen umfangreichen, leistungsfähigen Chatbot zu bauen erlaubt.

Vernetzte Bot-Teams: Alleine stark. Zusammen unschlagbar

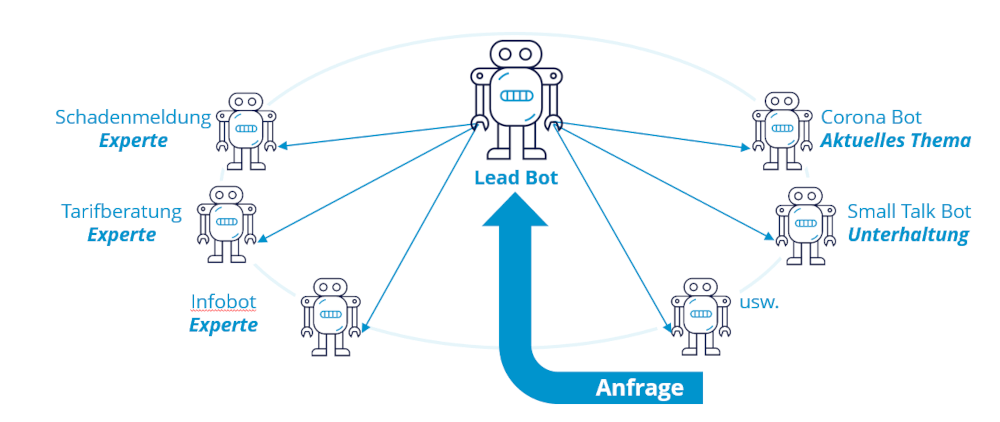

Daher sind Bots heute Spezialisten für kleine, abgegrenzte und einfache Aufgaben. Einen Universal-Bot, der vieles kann, wird es auf absehbare Zeit nicht geben. Daher entwickelte der Lösungsanbieter USU im Rahmen eines Forschungsprojektes ein Chatbot-Eco-System, das für Bots neue Einsatzmöglichkeiten schafft. Da ein einzelner Chatbot nur begrenzte Funktionen abdecken kann, soll die intelligente und flexible Kombination der Dialogsysteme als Chatbot-Netzwerk auch umfangreiche Aufgaben meistern.

Abb.: Vernetztes Bot-Team (Bildquelle: USU)

Das Konzept unterteilt Chatbots in zwei Rollen, Experten- und Lead-Bots. Die Expertenbots sind im Netzwerk registriert und können Informationen zu bestimmten Themen liefern. Die andere Rolle, der Lead-Bot, ist der Einstiegs-Chatbot, der zunächst mit dem Nutzer kommuniziert und ihm einen passenden Experten-Bot zuweist. Der Lead-Bot fungiert als eine Art Moderator, während der Experten-Bot für die eigentliche Beantwortung der spezifischen Frage zuständig ist. Diese modularen Bots erlauben eine einfache Pflege und Wartung durch die Redakteure. Kommt ein neuer Themenkomplex hinzu, wird ein weiterer Bot erstellt und im Netzwerk integriert.

Die Einsatz-Szenarien sind vielfältig: So kann die Lösung für Einrichtungskonzerne wie z.B. IKEA über das Bot-Konsortium entweder Fragen zu spezifischen Produkten klären oder allgemeine Themen abdecken, z.B. Prozesse für den Ersatzteil-Service, Retouren & Beschädigungen, Abhol- & Mietwagenservices oder Bezahlmodalitäten. Der Service-Provider für die Energiewirtschaft, GISA, nutzt dieses Modell beispielsweise für seinen internen IT-Service: Jeder Bot übernimmt ein Thema, z.B. Netzwerk, Microsoft Teams, Windows, Excel etc., und beantwortet User-Fragen zu seinem Spezialgebiet. Über Reporting und Feedbacks lassen sich einfach und übersichtlich für jeden Expert einerseits die Qualität messen, andererseits z.B. Inhaltslücken auf der Content-Seite rasch schließen. Gerade in diesem eher standardisierten Themenbereich können Bots durch eine „Self-Healing-Komponente“ sogar selbst aktiv werden, um IT-Probleme zu beheben, beispielsweise das Löschen des Browser Caches oder das Wiederherstellen der Netzwerklaufwerke.

An der Weiterentwicklung dieses „Bot Universe“ kann sich jeder beteiligen: Es ist ein freies und quelloffenes Bot-Kommunikationsprotokoll, das auf Basis von JSON für jede Art von Chatbot bereitgestellt wird. Im Rahmen des Open-Source-Projekts übernimmt USU eine administrative Rolle. Die Entwicklung weiterer Schnittstellen soll in der Folge den Einsatz vieler verschiedener Chatbots ermöglichen, die auf unterschiedlichen Technologien basieren.

Fazit

Chatbots sind inzwischen allgegenwärtig. Aktuell sind diese kleinen Helfer vielerorts als Monolithen im Einsatz. Auch wenn es im praktischen Einsatz häufiger Enttäuschungen gibt, die meist aus einer falschen Erwartungshaltung und einem nicht geeigneten Use Case herrühren, sind die maschinellen Service-Agenten für den individuellen und wirtschaftlichen Service der Zukunft nicht mehr wegzudenken. Treiber auf diesem Weg ist der Trend weg von Architektur-Silos hin zu offenen Architekturen sowie die weitere Verbreitung von intelligenten Conversational User Interfaces. KI-basierte Verfahren bieten auch auf absehbare Zeit nur ein begrenztes, auf den Einzelfall bezogenes Textverständnis. Eine pragmatische, in der Praxis bereits erfolgreich erprobte Lösung ist das „Zusammenschalten“ mehrerer Chatbots zu einem Bot-Netzwerk, mit dem sich flexibel auch komplexere Aufgaben lösen lassen.