Im atemberaubenden Tempo setzen sich ChatGPT und andere KI-Tools auch in den deutschen Unternehmen durch. Doch allzu selten kümmern sich die anwendenden Firmen dabei um die Sicherheit. Wer die KI mit firmeneigenen Daten füttert, geht ein immenses Risiko ein. Dank einer neuen Plattform lässt sich das nun ausschalten.

Die ganze Welt schwärmte Anfang 2023 von den bis dato ungeahnten neuen Möglichkeiten der Künstlichen Intelligenz. Die ganze Welt? Nun, in Italien folgte auf die erste Euphorie Ende März große Ernüchterung – und ein hartes Eingreifen der Behörden. Die Behörden in Italien hatten den Chatbot ChatGPT vorerst gesperrt. Auch wenn die Sperre inzwischen wieder aufgehoben ist, bleibt ein Flurschaden für die KI: Die Datenschutzbehörde im südlichen EU-Land warf dem Entwickler der Software, dem US-Unternehmen OpenAI, Verstöße gegen den Jugend- und Datenschutz vor. OpenAI durfte in der Folge die Daten italienischer Internetnutzer nur noch eingeschränkt verarbeiten. Böses erkannten die italienischen Datenschützer vor allem im angeblichen Fehlen einer Rechtsgrundlage für das Sammeln und Speichern personenbezogener Daten.

Das Einspeisen von Daten hat seine Tücken

Ein Einzelfall mit übertrieben sensiblen Datenschützern, die nicht verstanden haben, woher der neue Wind weht, und dem Fortschritt mal wieder im Weg standen? So einfach ist es nicht. Ein anderes Beispiel zeigt, dass KI zwar ein unglaublicher Innovationsmotor ist, aber auch Risiken birgt, die gemanagt und kontrolliert werden müssen. So gestattete Samsung Semiconductor seinen Beschäftigten die Assistenz durch den Chatbot, um ihren etwa zeitraubende Programmierarbeiten zu erleichtern. Die Ingenieure von Samsung nutzten dafür den Chatbot rund einen Monat lang und übermittelten ihm dabei dummerweise auch firmeninterne, streng vertrauliche Daten wie Sitzungsnotizen über Hardware, Samsungs Halbleiter-Business sowie Code, ohne sich des Sicherheitsrisikos bewusst zu sein. In der Folge kam es laut Medienberichten zu insgesamt drei kritischen Sicherheitsvorfällen.

Der Fall zeigt: ChatGPT kann viel, hilft viel, darf aber ob seiner Offenheit gerade nicht mit sensiblen Daten gespeist werden. Doch wie könnte eine Lösung aussehen? Wie lassen sich die Effizienzvorteile von ChatGPT und anderen Anwendungen nutzen, ohne gerade aus Sicht mittelständischer Unternehmen Abstriche beim Datenschutz machen zu müssen?

Smarter Schutzfilter für 100 Prozent Sicherheit

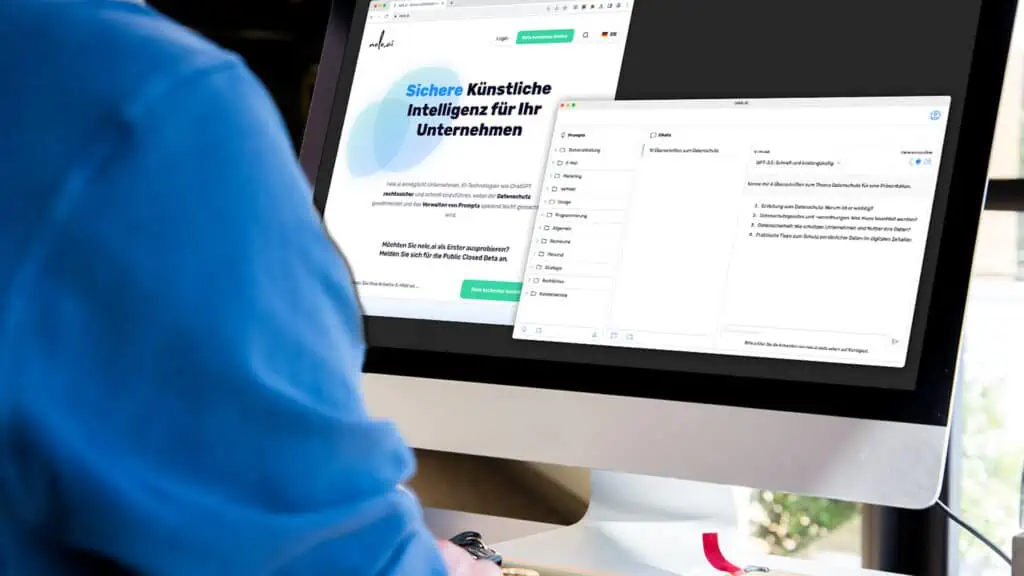

Möglich wird der datenschutzrechtlich unbedenkliche Einsatz von KI beispielsweise durch die neue Plattform nele.ai. Marktstart: August 2023. Vereinfacht gesagt, steckt dahinter die Idee, ChatGPT und Co. durch eine Sperrfunktion unmöglich zu machen, personenbezogene oder unternehmensbezogene Daten abzuspeichern. Sicherheit und Datenschutz nach EU-Standard sollten garantiert sein. Bei Bedarf kann dieser Datenschutzfilter aber auch jederzeit deaktiviert werden.

Gerade für mittelständische Unternehmen bietet KI die Chance, digital aufzuholen und vor allem zeitraubende Prozesse zu automatisieren. Im Zeitalter des Fachkräftemangels wird dieser Effizienzaspekt immer wichtiger. Die (weniger werdenden) Fachkräfte sollten da eingesetzt werden, wo sie den größten Mehrwert erzeugen, Kollege KI übernimmt dann bei wiederkehrenden, automatisierten Arbeitsschritten.

„Unsere Vision hinter nele.Ai ist es, KI schnellstmöglich in der Arbeitswelt und hier vor allen im Mittelstand zu etablieren. Ein Mitarbeiter kann bis zu 25 Prozent effektiver und schneller arbeiten, wenn er KI nutzt“, sagt Geschäftsführer Daniel Gal. Die Plattform für sichere KI-Anwendungen lässt sich bequem in die Unternehmen integrieren. Möglich macht das ein sogenanntes Credit-System: Unter einer Domain können dabei beliebig viele Nutzerinnen und Nutzer auf die Software-Lösung zugreifen. Gal: „Unser Anliegen ist es, den Einstieg in die Nutzung von generativen KI-Lösungen sicher und so einfach wie möglich zu gestalten. Daher haben wir ein einfaches und transparentes Preismodell entwickelt, um nele.ai flächendeckend in Unternehmen auszurollen.“

Professionelle Verwaltung von Prompts und Chats inklusive

Neben der Option, einen vollumfänglichen Datenschutzfilter einzustellen, können die User auch professionelle Prompts- und Chatverwaltungen nutzen. Mit jeder Anwendung der KI wird das Tool damit immer schlauer, weil es auf den bereits eingespeisten und damit gelernten Informationen aufsetzt.

Und was bei Samsung Semiconductor laut Presseberichten offenbar durch das unvorsichtige Vorgehen der Mitarbeitenden noch zum Daten-GAU führte, wird mit dieser Lösung nun möglich: die sichere Eingabe von firmeneigenen Daten in die KI-Tools. „Um aussagekräftige Ergebnisse aus generativen KI-Tools zu erhalten, ist es wesentlich, firmeneigene Daten einzugeben. So bleiben die Ergebnisse nicht generisch, sondern passen individuell zur jeweiligen Firma“, sagt Daniel Gal. Wichtig aber: Diese Daten dürfen nicht wie im Fall von Samsung Semiconductor und manch anderem Unternehmen in den Trainingsdaten des jeweiligen KI-Modells gespeichert werden. Denn sonst stehen sie jedem und damit auch jedem Wettbewerber offen zur Verfügung.