Forscher der University at Buffalo nutzen ChatGPT und Co zur Entlarvung von Bildern, die mithilfe Künstlicher Intelligenz (KI) erstellt wurden. Das Team hat große Sprachmodelle (LLMs) zur Erkennung von Fälschungen menschlicher Gesichter eingesetzt, darunter ChatGPT von OpenAI und Gemini von Google.

Ergebnis: Die Leistung von LLMs bleibt hinter jenen von spezialisierten Deepfake-Erkennungsalgorithmen zurück. Da LLMs aber in natürlicher Sprache aufgefordert werden können, ein Bild auf seine Echtheit zu untersuchen, könnten sie zum praktischeren Erkennungs-Tool werden, heißt es.

Spezielles Training entfällt

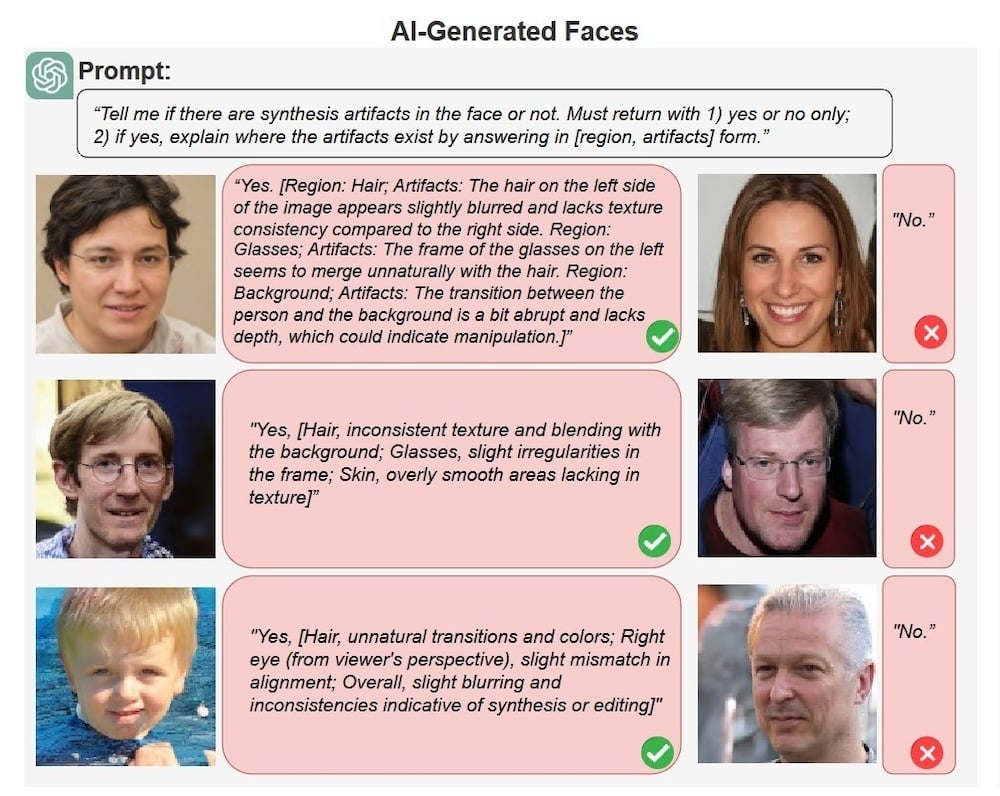

“Was LLMs von bestehenden Erkennungsmethoden abhebt, ist auch deren Fähigkeit, ihre Ergebnisse auf eine für Menschen verständliche Art und Weise zu erklären, wie die Identifizierung eines falschen Schattens oder eines unpassenden Paares von Ohrringen. LLMs wurden nicht für die Deepfake-Erkennung entwickelt oder trainiert, aber ihr semantisches Wissen hilft ihnen dabei”, sagt Forscher Siwei Lyu.

ChatGPT und andere LLMs wurden mit einem Großteil der im Internet verfügbaren Texte – insgesamt etwa 300 Mrd. Wörtern – trainiert und darauf gedrillt, statistische Muster und Beziehungen zwischen Wörtern zu erkennen, um Antworten zu generieren. Die neuesten Versionen können auch Bilder analysieren. Diese multimodalen LLMs sind mithilfe von große Bilddatenbanken mit Beschreibungen trainiert, um Beziehungen zwischen Wörtern und Bildern herzustellen.

Menschen sind das Vorbild

“Der Mensch tut das auch. Wir ordnen Bildern ständig eine semantische Beschreibung zu. Auf diese Weise bekommen Bilder eine eigene Sprache”, so Lyus Kollege Shan Jai. Die beiden ließen die LLMs tausende echte und gefälschte Bilder überprüfen. ChatGPT lag in 79,5 Prozent der Fälle richtig. Die Software erläuterte in normaler Sprache, woran sie Fälschungen erkannte. Bei einem KI-generierten Foto eines Mannes mit Brille wies das Modell korrekt darauf hin, dass “die Haare auf der linken Seite des Bildes leicht verschwimmen” und “der Übergang zwischen der Person und dem Hintergrund etwas abrupt ist und es an Tiefe fehlt”.

(vp/pressetext.redaktion)