Psychologische Erkenntnisse aus den Kognitionswissenschaften lassen sich auf den IT-Bereich übertragen – und helfen dabei, die Cyber-Sicherheit zu verbessern.

Jeder Mensch trifft im Schnitt rund 20.000 Entscheidungen pro Tag, bewusst oder nicht. Dabei prägen kognitive Verzerrungen wie Voreingenommenheit und Vorurteile die menschliche Entscheidungsfindung enorm. Daraus resultierende Denkfehler lassen sich auch auf die IT-Sicherheit übertragen. Werden Erkenntnisse aus den Kognitionswissenschaften und der modernen Analytik richtig interpretiert, kann sich dies positiv auf die Cyber-Sicherheit auswirken – wovon Anwender wie Entwickler gleichermaßen profitieren.

Bei der Bewertung von Risiken für die IT-Security ist es von entscheidender Bedeutung, sicherheitsrelevante, kognitive Verzerrungen zu erkennen, zu verstehen und richtig einzuschätzen. Auf diese Weise lassen sich die Risiken besser beherrschen und eindämmen. Um effektive Strategien für die Cyber-Sicherheit zu implementieren, sollten sich IT-Verantwortliche die Auswirkungen der Denkfehler bewusst machen. Im Wesentlichen sind es sechs verschiedene kognitive Verzerrungen, die die IT-Sicherheit in Unternehmen negativ beeinflussen können:

1. Ökologischer Fehlschuss

Beim so genannten ökologischen Fehlschuss gehen Menschen davon aus, dass Erkenntnisse über eine bestimmte Gruppe auch für jeden Einzelnen in dieser Gruppe gelten müssen. Dies führt regelmäßig zu Irrtümern, da Informationen, die aus einer gruppenspezifischen Dynamik resultieren, in der Regel nicht auf eine individuelle Ebene übertragen werden können. Denn Einzelpersonen lassen sich meist von vielen verschiedenen Einflussfaktoren leiten, die sich auf ihr Verhalten auswirken.

So gelten beispielsweise ältere Menschen aufgrund ihrer vermeintlich geringeren Kenntnis neuer Technologien häufig als risikobehaftete Nutzer. Diese Einordnung trifft jedoch nicht unbedingt auf individueller Ebene zu. Neuere Studien zeigen etwa, dass ältere Erwachsene weniger oft Passwörter teilen als jüngere Menschen. Demnach teilen 35 Prozent der Millennials Passwörter für Streaming-Dienste – verglichen mit 19 Prozent der Generation-X-User und nur 13 Prozent der Baby-Boomer-Generation. Die Bereitschaft jüngerer Menschen zum Austausch von sensiblen Informationen verursacht also weitaus höhere Risiken, als die Gewohnheiten der älteren Nutzer.

Diese kognitive Verzerrung kann dazu führen, dass sich IT-Sicherheitsverantwortliche fälschlicherweise auf die bloße Gruppenzugehörigkeit konzentrieren, anstatt auf Fakten oder gesicherte Informationen, welche die individuelle Person und ihr Verhalten genau beschreiben. Die Risikobewertung basiert also auf reinen Annahmen, was die Identifizierung der tatsächlichen Quelle von Sicherheitsproblemen verzögern kann. Um menschliche Einfluss- und Risikofaktoren hinreichend zu berücksichtigen, müssen Sicherheitslösungen individuelle menschliche Verhaltensweisen verstehen und damit aggregierte Verzerrungen überwinden. Dieses Ziel lässt sich am ehesten durch erweiterte Verhaltensanalysen wie Self-to-Self-, Self-to-Peer- und Self-to-Global-Vergleiche erreichen.

2. Ankereffekt

Der Ankereffekt tritt ein, wenn eine Person sich auf ein spezifisches Merkmal oder eine Reihe von Informationen in einem frühen Stadium des Entscheidungsprozesses festlegt. Ausschlaggebend für den Entschluss ist meistens die erste Information, die ein Mensch erhält, der so genannte Anker. Dies kommt häufig bei Preisverhandlungen zum Tragen. Schlägt dabei eine Partei einen bestimmten Anfangspreis vor, dient dieser als Anker für weitere Verhandlungen. Objektiv gesehen kann dieser jedoch zu hoch, zu niedrig, aber auch angemessen sein.

Die Herausforderung dabei für die IT-Sicherheit: Wird die ganze Aufmerksamkeit zu früh auf einen bestimmten Punkt gelenkt, können andere wichtige Informationen im Zusammenhang mit der Bedrohung in den Hintergrund treten und vernachlässigt werden. Stellt beispielsweise eine Führungskraft im Unternehmen Informationen über potenzielle IT-Bedrohungen bereit, konzentrieren sich untergebene Mitarbeiter fälschlicherweise oft ausschließlich auf diese Gefahren.

Die bloße Kenntnis des Ankereffekts reicht meist nicht aus, um dessen Auswirkungen wirksam zu verhindern. Menschen sind in der Regel schwach darin, Entscheidungen zu verändern, sobald neue Informationen oder Parameter hinzutreten. Wichtig ist hier vielmehr der Einsatz statistischer Analyseinstrumente. Damit lassen sich Entschlüsse auf Basis früher Informationen kritisch hinterfragen und neue Fakten und Erkenntnisse in den Entscheidungsprozess einbeziehen.

3. Verfügbarkeitsheuristik

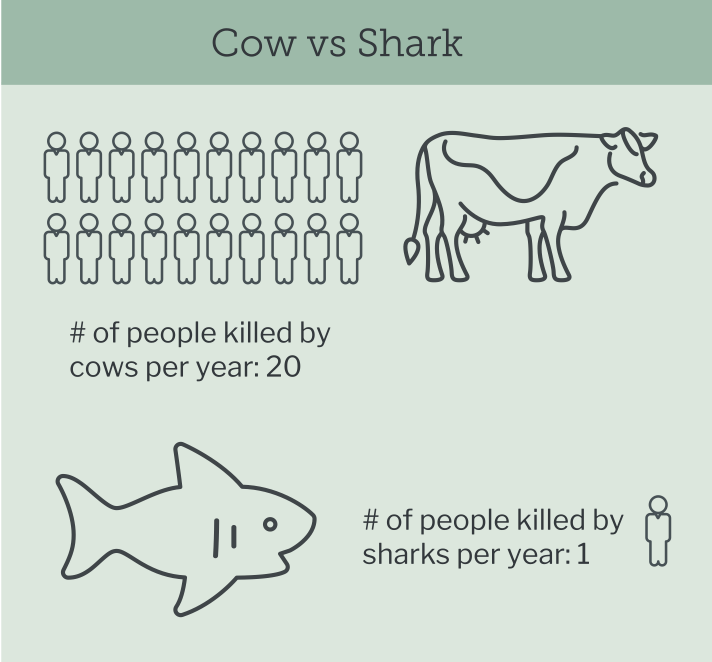

Nach der Verfügbarkeitsheuristik bemessen Menschen die Wahrscheinlichkeit für den Eintritt eines Ereignisses danach, wie oft sie in jüngerer Vergangenheit von ähnlichen Umständen gehört haben. Denn je häufiger eine Person auf bestimmte Informationen trifft, desto leichter sind diese im Gedächtnis zugänglich. So kann sich also die bloße Verfügbarkeit von Informationen auf die individuelle Wahrnehmung hinsichtlich des Eintritts eines Ereignisses auswirken.

Für die IT-Sicherheit bedeutet dies: Zwar analysieren IT-Experten die Unternehmensdaten gründlich und regelmäßig. Dennoch überschätzen sie manchmal die Wahrscheinlichkeit für den Eintritt eines Ereignisses. Sie müssen lernen, ihre Argumentationsstrategien konsequent in Frage zu stellen und nach dem Unerwarteten zu suchen. Gerade Führungskräfte, die weniger technisch versiert und von tagesaktuellen Informationen abhängig sind, werden meist häufiger von Verfügbarkeitsverzerrungen beeinflusst. Unternehmen, welche die Wahrscheinlichkeit bestimmter Bedrohungsszenarien realistisch einschätzen, unterbewerten oder ignorieren, investieren eher in den Schutz vor Problemen, deren Eintritt sehr unwahrscheinlich ist.

Um die Wahrscheinlichkeit einer Bedrohung richtig einzuschätzen, muss eine fortschrittliche Technologie für eine realistische Risikoerkennung eingesetzt werden. Auf dieser Basis kann die tatsächliche Bedrohungslage präzise analysiert und dargestellt werden. So müssen Entscheidungen nicht auf der Grundlage von aktuellen, verfügbaren Nachrichten getroffen werden, welche die Wirklichkeit verzerren. Für die Überwindung der Verfügbarkeitsheuristik bedarf es also sowohl des Menschen als auch der Technik. Der Mensch sollte eine Unternehmenskultur und Kommunikationsstrategie schaffen, die das Fachwissen der Sicherheitsexperten schätzt. Und die Technologie sollte dazu beitragen, genauere Wahrscheinlichkeiten für verschiedene Arten von Bedrohungen zu ermitteln.

Bild 1: Auch wenn Angriffe von Haien mehr mediale Aufmerksamkeit erregen, verursachen Kühe tatsächlich mehr Todesfälle pro Jahr.

4. Bestätigungsfehler

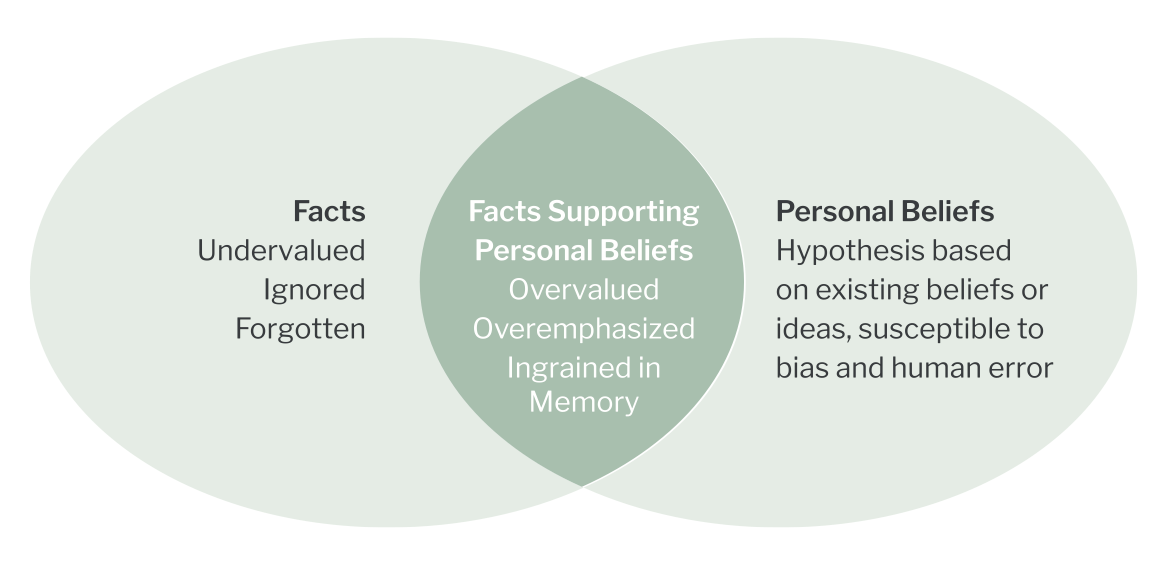

Diese kognitive Verzerrung beschreibt die menschliche Neigung, Informationen so auszuwählen und zu interpretieren, dass sie die eigenen Erwartungen, Meinungen und Überzeugungen bestätigen. Informationen hingegen, die diesem Standpunkt widersprechen, werden völlig ausgeblendet. Das bedeutet, dieser Denkmechanismus filtert Informationen nach subjektiven Maßstäben. So forschen auch IT-Sicherheitsverantwortliche häufig nur nach Ursachen oder Problemen, die mit ihren persönlichen Theorien oder Erkenntnissen übereinstimmen. Diese selektive Wahrnehmung kann oft von den tatsächlichen Bedrohungen und Gefahren ablenken.

Die Überwindung von Bestätigungsverzerrungen erfordert kreatives und flexibles Denken – und insbesondere die Fähigkeit und Bereitschaft, eine Situation aus unterschiedlichen Blickwinkeln zu betrachten. Es sollte eine Unternehmenskultur gefördert werden, in der abweichende Überzeugungen team-übergreifend wertgeschätzt werden. Dabei unterstützen mentale Übungen wie Rückwärtsdenken, Rollenspiele und das Lernen aus überraschenden Ereignissen.

Bild 2: Menschen neigen dazu, Informationen eher wahrzunehmen, die ihre Überzeugungen bestätigen. Botschaften hingegen, die ihrem Standpunkt entgegenstehen, werden ausgeblendet.

5. Framing-Effekt

Der Framing-Effekt bedeutet, dass unterschiedliche Formulierungen einer Botschaft – bei gleichem Inhalt – das Verhalten des Empfängers auf verschiedene Art beeinflussen. Als Framing wird dabei der sprachliche Rahmen bezeichnet, in den eine sachliche Information eingebettet wird. Dieser kann die Wirkung der Inhalte beim Rezipienten entscheidend mitbestimmen. Je nach Formulierung der Information werden ganz verschiedene Reaktionen hervorgerufen. Maßgeblich ist also der positive oder negative Wortlaut der Botschaft.

Was bedeutet dies für die IT-Security? Probleme in diesem Umfeld werden oft aggressiv formuliert und nutzen negative Framing-Strategien, um das Verlustpotenzial zu betonen. Aufgrund dieses Wordings investieren IT-Verantwortliche häufig in die falschen Sicherheitslösungen. Diese sind meist teuer und nicht geeignet, um spezifische und wenig wahrscheinliche Risiken zu berücksichtigen. Unternehmen sollten bei der Auswahl einer entsprechenden Lösung analytisch vorgehen, die angebotenen Funktionen genau prüfen und die tatsächliche Wirksamkeit des Systems hinreichend berücksichtigen.

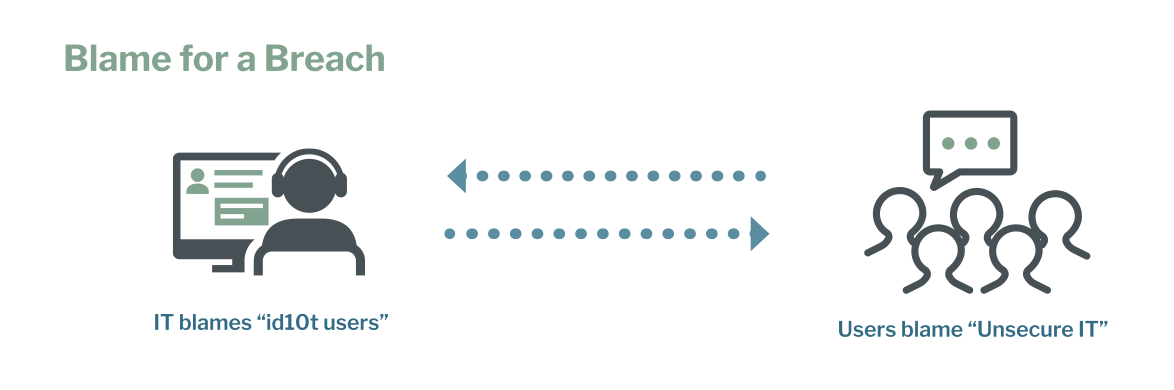

6. Attributionsfehler

Ein Attributionsfehler liegt vor, wenn die Ursache für ein beobachtetes Verhalten in feststehenden Eigenschaften der handelnden Person, anstatt in den variablen Merkmalen der jeweiligen Situation gesucht wird. Diese kognitive Verzerrung betrifft mehrere Bereiche der Cyber-Sicherheit. Oft werden unerfahrene Nutzer diskriminiert und als wenig intelligent angesehen. Dabei wird die Schuld meist in beide Richtungen verlagert – von der IT-Entwicklung auf die Anwender und von diesen auf die IT und das Engineering. Diese Attitüde verkörpert die Auswirkungen einer bidirektionalen sozialen Verzerrung. Dabei erkennen Menschen mit hohem technischem Fachwissen oft ihr eigenes, risikoreiches Verhalten nicht.

Ein Attributionsfehler kann häufig nur überwunden werden, wenn alle Beteiligten ihre eigene Unvollkommenheit eingestehen und anerkennen. Anwender sollten bedenken, dass Entwickler von komplexer Software immer aus einer hochgradig sicherheitsorientierten Perspektive agieren. Das Verhalten der Nutzer hingegen kann diesen Anforderungen meist nicht genügen. Deren Fehler sind nicht das Resultat mangelnder Intelligenz, sondern entstehen aus menschlichen Schwächen heraus. Dies sollten Entwickler berücksichtigen.

Bild 3: IT-Experten und Anwender beschuldigen sich häufig gegenseitig.

Fazit

Kognitive Verzerrungen spielen nicht nur im Alltagsleben von Menschen, sondern auch in der IT-Sicherheit eine wichtige Rolle. Werden die Denkfehler richtig erkannt und bewusst wahrgenommen, lassen sich deren Auswirkungen wirksam eindämmen. So können sich IT-Security-Strategien in Unternehmen entscheidend verbessern, was den Schutz vor Cyber-Bedrohungen und Angriffen deutlich erhöht.