Spätestens seit ChatGPT ist Künstliche Intelligenz in der Wahrnehmung unseres Alltags angekommen. Neben viel diskutierten Aspekten wie der Arbeitsplatzgefährdung, Desinformation oder Entwicklung ethisch vertretbarer KI, bieten selbstlernende Algorithmen zahlreiche Chancen. So leistet KI etwa bei der Bewältigung des Klimawandels oder von Gesundheitskrisen wertvolle Dienste. Auch in der IT-Sicherheit ist KI hochinteressant – für Hacker allerdings ebenso wie für Security-Experten.

Vereinfacht gesagt geht es bei Künstlicher Intelligenz darum, Computern das Lernen und Denken nach menschlichem Vorbild beizubringen. Von den verschiedenen Teildisziplinen eignet sich für die Unternehmenssicherheit vor allem das maschinelle Lernen. Sind Systeme in der Lage, mit Hilfe von Algorithmen Muster, Gesetzmäßigkeiten und Korrelationen zu erkennen, können sie aus den beobachteten Daten ein generalisiertes „Weltbild“ erzeugen und daraus Entscheidungen ableiten oder Vorhersagen treffen. Security-Experten erhalten dadurch in dynamischen und zunehmend komplexen Bedrohungslagen einen zusätzlichen, verhaltensbasierten Blick auf ihre Umgebung. Das ist wichtig, da auch die „Gegenseite“ KI-Methoden anwendet.

Cyberkriminelle KI-Methoden

Hacker können KI-Methoden für eine Vielzahl von Angriffsszenarien nutzen. Beispiele wären Phishing, Malware oder Brute-Force. So können Phishing-E-Mails wesentlich professioneller und personalisierter auf eine Zielperson zugeschnitten werden, indem KI-Methoden öffentlich zugängliche Informationen über diese Person verwenden. Im Grunde lernt die KI durch gezieltes Social-Engineering, einen bestimmten User dazu zu bringen, einen bösartigen Link zu öffnen. Als dafür geeignet nennt die Literatur unter anderem Long-Short-Term Memory Networks (LSTM) und Generative Adversarial Networks (GANs), die jeweils zu den künstlichen neuronalen Netzen zählen. Neue Maßstäbe in Sachen Angriffsqualität werden auch so genannte Transformer setzen, eine weitere Art künstlicher neuronaler Netze, auf der auch ChatGPT basiert.

Mit Brute-Force-Angriffen versuchen Hacker, Passwörter zu erraten, indem sie eine Liste vordefinierter Zeichenketten nach bestimmten Mustern so lange durchprobieren, bis der Algorithmus einen Treffer landet. Selbstlernende Algorithmen verhelfen dem naiven Probier-Verfahren durch eine intelligente Auswahl der zu testendenden Kombinationen zu wesentlich mehr Erfolg. Als Grundlage hierfür dienen etwa Datenbanken mit Kennwörtern aus früheren Angriffen.

Als ein drittes Beispiel für offensive Anwendungen, das bereits in verschiedenen Arbeiten erprobt wurde, nennt die Literatur mit KI-Unterstützung generierte Malware. So machte vor einigen Monaten auch ChatGPT Schlagzeilen, nachdem aufgezeigt wurde, wie integrierte Sicherheitsmechanismen umgangen werden konnten, um das KI-Tool dazu zu bringen, lauffähigen Schadcode zu erzeugen. Zwar hält sich die Komplexität solcher Malware in Grenzen, ein Ausblick auf das zukünftige Gefahrenpotential ist jedoch nicht von der Hand zu weisen. Das gilt umso mehr als bereits polymorphe Malware KI-basiert generiert wurde. Diese ist für Schutzmechanismen schwerer zu erkennen, da sie bei jedem Angriff eine neue, gleich schädliche Variante von sich erstellt.

Der offensive Einsatz von KI-Methoden verleiht Cyber-Angriffen ein grundlegend neues Maß an Autonomie, Professionalität und Effizienz. Dass der Begriff Autonomie Assoziationen zum Thema autonomes Fahren weckt, ist kein Zufall: So wie ein Fahrzeug ohne menschliches Zutun selbständig von A nach B findet, so wird auch die Suche nach Kompromittierungswegen zunehmend autonomer erfolgen. Stark vereinfacht ausgedrückt verändern wir lediglich die Umwelt beziehungsweise Datengrundlage, mit welcher die KI-Methode arbeitet. Der Weg von A nach B entspricht dem Pfad vom Startpunkt zur Schwachstelle. Auf diese Weise könnten Hacker auch potenziell unbekannte Kompromittierungspfade beziehungsweise Zero-Days aufspüren und ausnutzen.

Ohne defensive KI geht es künftig nicht mehr

Angesichts der neuen Bedrohungsdimension gewinnt Künstliche Intelligenz als defensives Instrument zur Erkennung, Analyse und Abwehr von Cyber-Angriffen zunehmend an erfolgskritischer Bedeutung. KI-basierte Technologien haben damit nicht nur das Potenzial, die Erkennungs- und Abwehrmechanismen von Unternehmen generell zu stärken. Perspektivisch erscheinen sie sogar als alternativlos, da sich Unternehmen nur mit ihrer Hilfe auch vor den von ihnen selbst ausgehenden Gefahren schützen können.

Wie ihre offensiven Verwandten zeichnen sich auch die defensiven KI-Methoden durch ihre Fähigkeit aus, Muster und Gesetzmäßigkeiten in großen Datenmengen zu erkennen. Dadurch können diese auch zu Zwecken der Anomalieerkennung eingesetzt werden und selbst jene Bedrohungen registrieren, die für einen Menschen oder ein regelbasiertes Tool allein nur schwer oder gar nicht zu identifizieren sind. So lassen sich etwa E-Mails effektiver auf mögliche Phishing-Versuche untersuchen, indem beispielsweise Inhalts- und Header-Merkmale, die Präsenz von Anhängen oder enthaltene Links mithilfe maschinellen Lernens kontextualisiert betrachtet werden.

Weiterhin können Security-Experten defensive KI-Methoden dazu verwenden, offensiv-intelligenten Angriffsversuchen zu begegnen, die auch in der Lage wären, unbekannte Kompromittierungspfade zu identifizieren. Während solche Angriffe regelbasierten Systemen aufgrund fehlender Signaturen überwiegend verborgen bleiben, lassen sie sich durch Anomalie-Erkennung und Verhaltensanalyse aufdecken. Ebenso spricht nichts dagegen, offensiv KI-gelagerte Methoden für eigene, defensive Zwecke einzusetzen. So kann man Schwachstellen in der eigenen Infrastruktur aufdecken und entsprechende Risiken frühzeitig erkennen und behandeln.

Ohne existierende Signaturen wird auch der Kampf gegen KI-basierte Malware insgesamt herausfordernd, insbesondere, wenn Polymorphie im Spiel ist, und sich der Code stets ändert. Hier hilft maschinelles Lernen ebenfalls, indem es Dateieigenschaften und Verhalten ganzheitlich und kontextualisiert betrachtet.

Integration von defensiver KI

Zur Freude von Sicherheitsanbietern und internen Sicherheitsabteilungen ist maschinelles Lernen eine gut erforschte Disziplin. Verschiedene Hersteller haben sie bereits integriert, beispielsweise in EDR-Lösungen. Dennoch reicht der alleinige Einsatz von KI-basierten Aufklärungsmaßnahmen bei weitem nicht aus, um den Herausforderungen offensiver KI vollständig zu begegnen. Dies liegt zum Teil daran, dass die oben genannten Anomalieerkennungsverfahren dazu neigen, viele falsch-positive Alarme zu erzeugen. Zu beachten ist, dass die Anomalieerkennung nicht das einzige KI-gestützte Verfahren für den defensiven Einsatz ist. Aufgrund ihrer Adaptivität und Flexibilität steht sie jedoch im Fokus.

Grundsätzlich betrachtet müssen die einzelnen Verfahren noch präziser werden, um ausreichend effektiv zu sein. Insofern kann defensive KI nur ein Baustein eines umfassenderen Sicherheitsansatzes sein, der auf einer Vielzahl sich ergänzender Methoden beruht. Wer einen Sicherheitsstandard mit integrierten KI-Methoden aufbauen will, sollte zunächst Transparenz über die eigene Infrastruktur schaffen. Denn in Zeiten stetig wachsender Datenmengen, Systemkomplexität und Plattformvielfalt ist es unerlässlich, alle Assets einer IT-Infrastruktur zu kennen und zu überwachen. Ein bewährter Ansatz hierfür ist die Implementierung eines Security Information and Event Management (SIEM) Systems, in dem alle sicherheitsrelevanten Ereignisse in der IT-Infrastruktur zusammenlaufen. Durch die Konsolidierung von Ereignissen aus verschiedenen Datenquellen generiert das SIEM gleichzeitig eine Datenbasis für defensive KI-Methoden, um Muster und Gesetzmäßigkeiten in der Umgebung zu erkennen und daraus zu lernen.

Schlüsselfaktor Mensch

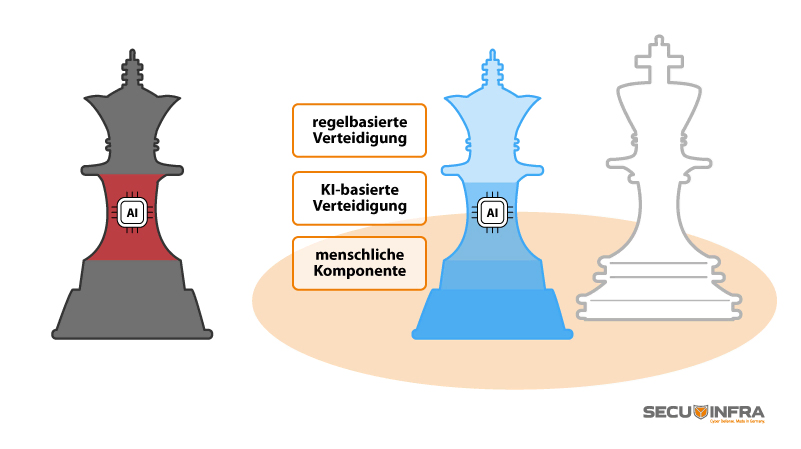

Trotz der nachgewiesenen Wirksamkeit von KI-Methoden ist es erforderlich, diese mit etablierten regel- oder signaturbasierten Erkennungsmechanismen zu kombinieren. So ist sichergestellt, dass bekannte Angriffe anhand von Signaturen und Regeln zuverlässig erkannt werden. Gerade wenn es um die Abwehr bekannter Szenarien geht, sind regelbasierte Systeme dem KI-Ansatz sogar vorzuziehen. In jedem Fall ist aber stets ein gewisses Maß an menschlicher Expertise nötig, um die Ergebnisse von KI-Methoden und regelbasierten Erkennungsverfahren zu bewerten und die feinen Nuancen und Zusammenhänge in auftretenden Alarmsituationen adäquat zu interpretieren. Gleichwohl gewinnt die KI zunehmend an Relevanz und wird zu einem neuen, wichtigen Baustein für Security-Experten. Am Ende sind es jedoch immer die Menschen, die mit durchdachten Konzepten, Prozessen und vor allem ihrer Erfahrung den entscheidenden Faktor bilden.