Solide Daten sind das A und O beim KI-Einsatz. Eine aktuelle Gartner-Analyse enthält eine umfassende Checkliste, um die Eignung von Daten für KI-Projekte zu bewerten. Der Fokus liegt auf der kontinuierlichen Überwachung statt einmaliger Datenvorbereitung.

Die Gartner-Experten Mark Beyer, Ehtisham Zaidi und Roxane Edjlali zeigen in ihrer aktuellen Analyse vom 31. Januar 2025, wie Unternehmen die Eignung ihrer Daten für KI-Anwendungen richtig bewerten können. Die Kernaussage: KI-Entwickler, Data Scientists und Dateningenieure überschätzen häufig mathematische und statistische Funktionen als Ausgleich für Datenprobleme. Dies kann einen selbstverstärkenden Kreislauf des Übervertrauens auslösen, besonders wenn Teams isoliert arbeiten.

Was bedeutet „KI-bereit“ eigentlich?

„KI-taugliche Daten“ ist immer ein relativer Begriff. Daten, die für einen KI-Anwendungsfall bereit sind, können für den nächsten völlig ungeeignet sein. Auch Daten, die zu Monatsbeginn KI-bereit waren, müssen kontinuierlich überwacht werden, um sicherzustellen, dass sie weiterhin repräsentativ und nutzbar bleiben.

Der Bericht identifiziert vier Modi der KI-Datenbereitschaft, die vom Umfang der Metadatennutzung abhängen:

- Konzeptnachweis (POC): Das Risiko wird hauptsächlich durch Fachexperten gesteuert, die lokales Wissen über Datenanforderungen haben

- Multikontext: Die gleichen Daten werden in verschiedenen Szenarien bewertet, mit Expertenhilfe für A/B-Tests

- Operationalisiert: Risikomanagement wird von Teams auf Tools verlagert, mit überlappenden Qualifikations- und Kontext-Metadaten

- Produktion: Automatisierte Prozesse überwachen kontinuierlich Datenänderungen, mit Warnmeldungen bei Abweichungen

Metadaten als Schlüssel zum Erfolg

„Metadaten sind die beste Darstellung der Interaktion von Menschen mit Daten und können genutzt werden, um KI bei der Unterscheidung zwischen angemessenen Datenmanagementpraktiken und Halluzinationen oder Überanpassungsproblemen zu unterstützen.“

Metadaten fallen in zwei entscheidende Kategorien:

- Datenqualifikation:

- Stellt sicher, dass Daten repräsentativ sind

- Bewertet Datenwerte, Häufigkeit, Verteilung, Integrität und Änderungsmuster

- Erfordert zusätzliche Tools und qualifiziertes Personal für effektive Bewertungen

- Nutzungskontext:

- Stammt aus nahezu jedem System, jeder Plattform und jedem Prozess

- Umfasst, wie oft und wann Systeme laufen, wer Prozesse initiiert, welche Daten beteiligt sind

- Beinhaltet Komponenten aus Verarbeitungscode-Argumenten (z.B. „join“, „select“)

Je stärker diese Metadaten überlappen, desto eher können Risiken von Expertenteams auf Systeme übertragen werden, was mehr Automatisierung ermöglicht.

Checkliste für die KI-taugliche Datenaufbereitung

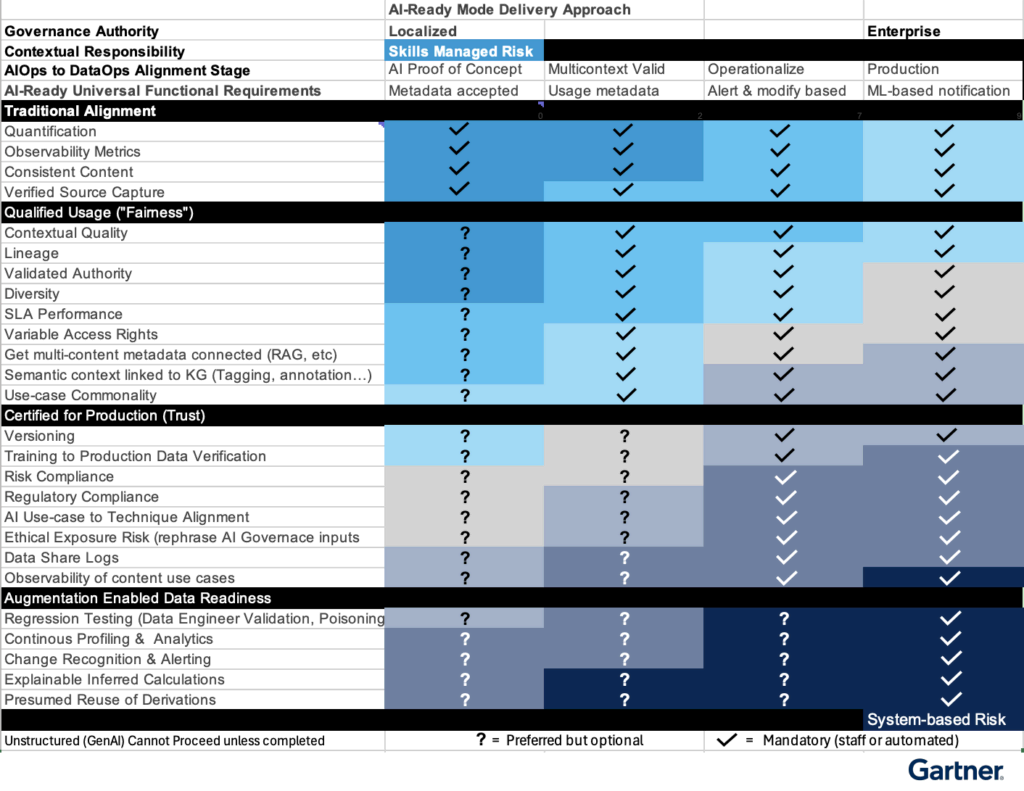

Der Bericht präsentiert eine umfassende Checkliste, die über 30 Tests umfasst, gruppiert in:

- Traditionelle Ausrichtung (Quantifizierung, Beobachtbarkeitsmetriken)

- Qualifizierte Nutzung (Kontextuelle Qualität, Herkunft, Diversität)

- Zertifiziert für Produktion (Versionierung, Schulung, Einhaltung von Vorschriften)

- Augmentierte Datenbereitschaft (Regressionstests, kontinuierliche Profilierung)

Die Checkliste und Prioritätenmatrix lässt sich am besten in folgendem Kontext verstehen:

- Jede Zeile beschreibt eine spezifische Aufgabe oder einen Prozess, der bei der Nutzung eines Datenbestands für einen KI-Anwendungsfall durchgeführt werden sollte.

- Jede Spalte beschreibt einen der vier KI-fähigen Datenmodi.

- Im Allgemeinen birgt der am weitesten links stehende KI-fähige Datenmodus (KI-Konzeptnachweis) das höchste Risiko für die Organisation. Solche Risiken werden daher am besten von erfahrenen, qualifizierten und validierten Teams oder Experten angegangen, die bei der Datenaufbereitung transparent sind.

- Ebenso geht der rechte Modus (Produktion) davon aus, dass die Datenaufbereitung in hohem Maße automatisiert ist. Dabei ist zu berürücksichtigen, dass automatisierte oder erweiterte Datenaufbereitungsschritte sowohl von qualifizierten KI-Experten als auch von Datenverwaltungsexperten validiert werden müssen, die gemeinsam die Effizienz, die Vollständigkeit, die Werkzeuge und die im Betrieb verwendeten Plattformen validieren können.

- Hellblau (oben links in der Grafik) bedeutet, dass das Risiko weitgehend vom KI-Team übernommen wird. Die KI-Entwickler und Data Scientists müssen in jeder der in jeder Zeile angegebenen Datenaufbereitungsaufgaben über hohe Kenntnisse und Fähigkeiten verfügen.

- Grau oder dunkelblau (unten rechts in der Grafik) bedeutet, dass das Risiko weitgehend durch programmatische und sogar automatisierte Bereitstellung der in jeder Zeile angegebenen Datenaufbereitungsfunktion übernommen wird.

- Ein Häkchen bedeutet, dass die Aktivität in der Zeile obligatorisch ist, um die KI-Fähigkeit für Ihre Datenbestände zu erreichen.

- Ein „?“ bedeutet, dass die Zeile optional ist, die KI-Fähigkeit jedoch verbessert wird, wenn diese Funktion einbezogen wird. Die Aufgaben können von automatisierten Prozessen oder qualifiziertem Personal ausgeführt werden, wobei die Automatisierung eine höhere Konsistenz gewährleistet.

Je mehr Zeilen entweder von qualifizierten Mitarbeitern oder automatisierten Systemen ausgefüllt werden, desto geringer ist das Risiko bei der Verwendung der Daten in bestimmten KI-Modellen.

Wichtig ist, dass die Tiefe (die Anzahl der ausgefüllten Zeilen) entscheidend ist – nicht allein die Automatisierung. Das KI-Implementierungsteam oder der Data Scientist verfügt möglicherweise auch über Fähigkeiten zur Automatisierung ihrer Datenvorbereitung in bestimmten Bereichen (sogar innerhalb ihres Modells). Je tiefer Sie durch die Zeilen in der Liste gehen, desto besser – und die Zeile kann automatisiert oder von qualifizierten Fachleuten verifiziert werden. Wenn zu viele Aufgaben/Zeilen unabhängig von der Automatisierung unvollständig bleiben, liegt die Verantwortung für die Bereitschaft weiterhin beim KI- und Data-Science-Team. Wie jedoch zuvor erwähnt, zeigen KI- und Data-Science-Teams ein übermäßiges Vertrauen in ihren Datenmanagementansatz. Das bedeutet, dass sie für die Entscheidungen und Ergebnisse von KI-Modellen verantwortlich sind, einschließlich wenn sie die Daten modifizieren, ersetzen oder anderweitig falsch vorbereiten.

KI-Implementierungsteam

KI-Bereitschaft erfordert KI-bereite Daten. Bestehende Datenmanagementpraktiken liefern im Allgemeinen einen fragmentierten Ansatz, wobei die verschiedenen Datenmanagementaufgaben auf sehr unterschiedlichen Ebenen basierend auf Abteilungen, Anwendungen, Entwicklungsteams und mehr erledigt werden. Organisationen können diesem fragmentierten Ansatz entgegenwirken, indem sie sicherstellen, dass ihr KI-Implementierungsteam das Risiko verwaltet und die Verantwortung für die Datenvorbereitung übernimmt. Alternativ sollten Organisationen ihre Anforderungen klar gegenüber Datenmanagementexperten formulieren, die sowohl die Verantwortung als auch die Befugnis für die Bereitstellung der Daten übernehmen werden.

Wenn Führungskräfte KI-Konzeptnachweise für eine schnelle Einführung verfolgen möchten, dann sollten diese Führungskräfte Mitarbeiter einstellen oder schulen, deren kollektive Expertise sowohl Feature Engineering als auch Data Engineering umfasst.

Wenn die Datenmanagementumgebung als weniger ausgereift gilt als der angestrebte Modus, wird auch eine Finanzierung notwendig sein, um die erforderlichen Teams und Plattformen aufzubauen. Ohne die Finanzierung beider Aspekte bleibt das Risiko der Organisation hoch, da sie von Personalmodellen abhängig ist, die erhebliche Neustarts und negative Auswirkungen durch Personalwechsel erfahren können.

Der kontinuierliche Zyklus der KI-Datenbereitschaft

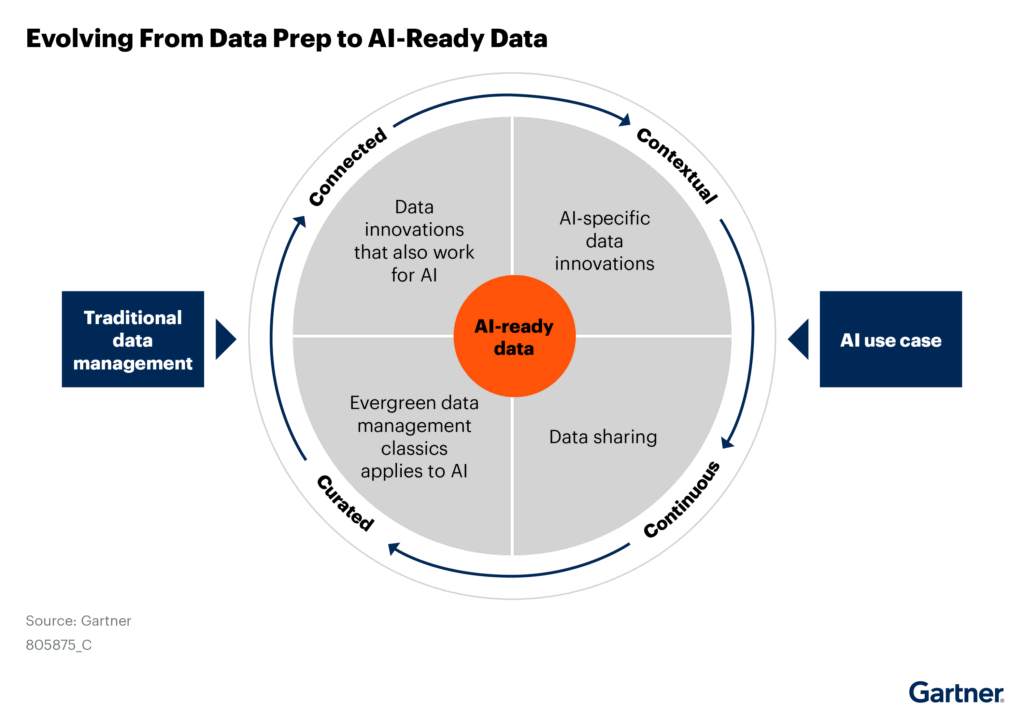

KI-taugliche Daten erfordern einen kontinuierlichen Bewertungszyklus. Traditionelles Datenmanagement bleibt die Grundlage, wird aber durch vier spezifische Dimensionen erweitert:

- Verbunden: Dies bezieht sich auf Datenmanagement-Innovationen, die sowohl für traditionelle Datennutzung als auch für KI funktionieren. Gemeint sind Praktiken und Technologien, die die Verbindung zwischen herkömmlichen Datenquellen und KI-Anwendungen herstellen (z.B. moderne Datenintegrationsmethoden, die für beide Nutzungsarten geeignet sind).

- Kontextuell: Hierbei handelt es sich um speziell für KI entwickelte Dateninnovationen, die den einzigartigen Anforderungen von KI-Systemen entsprechen. Dies beinhaltet Methoden, die KI-spezifische Datenqualität, Metadaten-Tagging und Kontextanreicherung berücksichtigen, die traditionelle Systeme möglicherweise nicht benötigen.

- Kontinuierlich: Dieser Punkt betont die Notwendigkeit des laufenden Datenaustauschs und der Integration. Im Gegensatz zu traditionellen Batch-Prozessen erfordern KI-Systeme oft einen kontinuierlichen Fluss von Daten und Feedback, um relevant zu bleiben und sich an Veränderungen anzupassen.

- Kuratiert: Dies bezieht sich auf bewährte Datenmanagementpraktiken, die auch für KI-Anwendungsfälle gelten. Dazu gehören traditionelle Datenqualitäts-, Governance- und Metadatenmanagement-Methoden, die für KI-Zwecke angepasst wurden.

„KI-bereite Daten sind stets eine relative Referenz. Daten, die für einen KI-Anwendungsfall bereit sind, können für den nächsten völlig unzureichend sein.“

Der wichtige Aspekt ist, dass diese vier Dimensionen nicht in einer linearen Abfolge funktionieren, sondern in einem kontinuierlichen Kreislauf. Das bedeutet:

- KI-Systeme benötigen konstante Bewertung und Anpassung der Daten

- Feedback aus einem Bereich informiert die anderen

- Die Datenbereitschaft ist nie „abgeschlossen“, sondern ein fortlaufender Prozess

- Änderungen in KI-Modellen können neue Datenanforderungen schaffen, die wiederum den Zyklus neu starten

Im Bericht wird betont, dass dieser zyklische Ansatz entscheidend ist, da KI-Daten sich mit der Zeit entwickeln und verändern, was eine kontinuierliche Überprüfung und Anpassung erfordert.Wiederholen

Konkrete Empfehlungen für Daten- und Analyseverantwortliche

- Richten Sie Datenrepräsentativität und Kontext am KI-Nutzungszweck aus:

- Bewerten Sie Variationen im Datenkontext für jeden Anwendungsfall

- Nutzen Sie möglichst viele Metadaten aus bestehenden Systemen

- Verbessern Sie die KI-Datenbereitschaft durch erweiterte Metadatennutzung:

- Nutzen Sie Metadaten aus bestehenden Datenprozessen

- Überwachen Sie kontinuierlich Wertedrift, Umstrukturierung und andere Änderungsmuster

- Überprüfen Sie die KI-Datenbereitschaft mit der Checkliste:

- Identifizieren Sie, ob wesentliche Governance-Prinzipien validiert wurden

- Bewerten Sie den Abhängigkeitsgrad von Experten gegenüber Tools und Systemen

Fazit

Die Bewertung der KI-Datenbereitschaft erfordert ein Umdenken in Bezug auf Datenqualität und -management. Mit zunehmendem Vertrauen in KI-Systeme fordern Risikomanagement und Führungskräfte umfassendere Überprüfungen und Validierungen, da bisherige Qualitäts-, Governance- und Metadatenpraktiken oft nicht ausreichen.

Durch einen strukturierten Ansatz zur Metadatenerfassung und -analyse können Unternehmen Risiken reduzieren und ihre KI-Investitionen absichern – ein Prozess, der niemals als abgeschlossen betrachtet werden sollte.

Alle in der folgenden Tabelle aufgeführten Anforderungen werden letztendlich verpflichtend sein. Die Verantwortung, die Anforderungen weiter zu vertiefen, kann jedoch entweder von einzelnen KI-Teams oder von den unternehmensweiten Datenmanagement-Teams übernommen werden, die Datenplattformen und -tools nutzen. Die Funktionstiefe kann im Laufe der Zeit erhöht werden, sobald die Mindestanforderungen erfüllt sind.

| Datenanforderung | Definition |

|---|---|

| Traditionelle Ausrichtung | „As-is“ Datenqualität, wie vom KI-Team überprüft, das für die Datenvorbereitung verantwortlich ist. |

| Quantifizierung | Das Volumen strukturierter Daten oder unstrukturierter Assets ist bekannt in Bezug auf Datensatz- oder Objektanzahl. |

| Beobachtbarkeitsmetriken | Verteilung von Inhaltswerten, Änderungsmuster, Zugriffsraten, Anzahl und geschäftlicher Fachbereich der Anwendungsfälle sind bekannt. |

| Konsistenter Inhalt | Wenn derselbe Inhalt in verschiedenen Formaten oder Strukturen vorhanden ist, wird er querverwiesen, um festzustellen, ob gleiche oder ähnliche Werte existieren. |

| Verifizierte Quellenerfassung | Quelldaten werden anhand von Qualitätsregeln und -prozessen überprüft, um sicherzustellen, dass sie gemäß ihren lokalen Designregeln von der Quelle erfasst werden. |

| Qualifizierte Nutzung („Fairness“) | Mehrere Anwendungsfälle nutzen die Daten mit ähnlicher Statistik, Kalkulation und Mathematik. Zugriffsrechte für verschiedene Assets sind verstanden. Audit- und Design-Metadaten sind erforderlich. |

| Kontextuelle Qualität | Verschiedene Werte werden verwendet, um dasselbe Konzept darzustellen, aber die Äquivalenz ist verstanden (z.B. „Junge/Mädchen“ vs. „männlich/weiblich“ oder „212F/100C“ oder „Namenszeichenfolge vs. normalisierte Spalten“) |

| Abstammung (Lineage) | Der vollständige Pfad der verwendeten Daten ist von der Quelle bis zum Anwendungsfall verstanden, und Verzweigungen sind ebenfalls verstanden, mit Isolierung in Fällen, in denen Daten lokalisiert sind. |

| Validierte Autorität | Es ist bekannt, dass die Herkunft aus genehmigten Systemen oder Anbietern stammt, und die Abstammung verknüpft die Daten zuverlässig mit diesem Ursprungssystem. |

| Diversität | Diverse Daten mit der gleichen Bedeutung, oder Daten, die Vektoren in Berechnungen erzeugen, um zur gleichen Ausgabe zu gelangen (z.B. PSI berichtet vs. PSI-Berechnungen). |

| SLA-Performance | Lesezeiten, Übertragungsraten und laufende Updates werden verstanden, und Awareness-Tests beim Logging von Daten können berechnete Werte ändern. |

| Variable Zugriffsrechte | Vollständiges Verständnis, wann ein Anwendungsfall die Fähigkeit hat, auf geschützte Daten in derselben Datendomäne zuzugreifen, in der ein nicht autorisiertes System dies nicht kann. |

| Multicontent-Metadaten verbunden (RAG, etc.) | Konsistentes Tagging. Qualitative Analyse (identifizierte Metapher/Allegorie-Konfusion, erstellte Stimmung/POV, Zielgruppe, zusätzliche Zielgruppe, Ton, Emotion, Lesbarkeit). |

| Semantischer Kontext verknüpft mit KG (Tagging, Annotation…) | Separate Bestätigungsbasen von inferentieller Integrität. Signifikanter alternativer Pfad durch Graph. Bestätigung, Verstärkung, Negation, Umleitung. |

| Anwendungs-Kommunalität | Ähnliche Zugriffsrechte, Verwendung von disparaten Daten, ähnliche Berechnungen und Mathematik werden verwendet, um Geschäftsprobleme zu evaluieren, zu berichten und zu analysieren. |

| Zertifiziert für Produktion (Vertrauen) | Aktualisierungsraten/Änderungsraten, Wiederverwendung von Daten in verschiedenen Lösungen, externe Anforderungen für Standards sind verfügbar. Erwartungen an die Mathematik werden in Bezug auf Datenmengen, Qualität und Diversität verstanden und in Mindestschwellenwerte für den Vergleich mit mathematischen Konfidenzrequirements umgewandelt. Data Science und Engineering erforderlich. |

| Versionierung | Datenversionen und kontinuierliche Trendanalysen zur Überwachung der Datenvariation im Zeitverlauf sind gut dokumentiert. |

| Training vs. Produktionsdaten-Verifizierung | Laufende Aufzeichnungen zur Variation von Schutz, Qualität, Integrität oder Nutzung außerhalb genehmigter Anwendungsfälle werden dokumentiert und analysiert. |

| Risiko-Compliance | Datenklassifizierung aller Typen ist bereitgestellt (geheim, privat, wettbewerbsfähig, Haftung, etc.). |

| Regulatorische Compliance | Berichtsminima sind bekannt und unterstützt, und alle Modifikationen, Anreicherungen, Referenzdaten und Berichtskategorien werden dokumentiert. |

| KI-Anwendungsfall zu Technik-Ausrichtung | Die Stabilität des KI-Features oder der Technik ist bekannt, um angemessene, effiziente und häufige Nutzung im Verhältnis zum Analyse-Anwendungsfall und seiner Absicht darzustellen. |

| Ethische Exposition Risiko (Umformulierung von KI-Governance-Inputs) | Externe Unternehmens- und Lokalisierungs-Governance-Anforderungen und Ratenreaktion auf jede Anforderung sind getrennt. Soziale, demografische und regionale Normen für Medien und Typografie sind identifiziert. |

| Daten-Sharing-Logs | Alle Instanzen von beabsichtigter und unbeabsichtigter Datenleckage werden dokumentiert und bei Entdeckung analysiert, und Klassifizierung von Anwendungsfall-Beschränkungen ist erreicht. |

| Beobachtbarkeit von Inhalt-Anwendungsfällen | Cluster von Anwendungsfällen sind nach Quellenautoritätspräferenzen identifiziert. Ähnlicher Inhalt, der verwendet und nicht verwendet wird, wird in verschiedenen Anwendungsfällen querverwiesen, und Degradierungsraten werden verfolgt. |

| Augmentierungs-aktivierte Datenbereitschaft | Für alle KI-Bereitschaftsmodi werden Metadaten gesammelt und für Dateninhalt und Nutzungstrends analysiert. Graphen Muster für „Gesundheit“ von Daten werden identifiziert, wenn bekannt, Dämonen oder Services werden eingesetzt, um die Ausrichtung oder Abweichung von allen oben genannten Anforderungen und diesen Mustern unten zu analysieren. |

| Regressions-Testing (Data Engineer Validation, Poisoning) | Alle Daten-Assets werden kontinuierlicher Analyse unterzogen, um festzustellen, ob Änderungen in aktuellen Datenzuständen, wenn auf frühere Analysen unter Verwendung dieser Assets überlagert, zu unterschiedlichen Ausgaben oder Ergebnissen führen würden. |

| Kontinuierliches Profiling & Analyse | Profiling von Daten-Assets wird kontinuierlich auf Musteränderungen bei Inhalt, Werten, Integritätsproblemen und Querverweisen graph-analysiert. |

| Änderungserkennung & Alarmierung | Häufigkeit von Änderungsraten und Mustern wird verfolgt, wenn Änderungsraten beschleunigen, verlangsamen oder volatile Perioden auftreten. Alerts werden für das Modell durch Posten von Indikator-Indikatoren entwickelt. |

| Erklärbare abgeleitete Berechnungen | Alle KI- und Analysemodelle werden bewertet, um festzustellen, ob ein direkter Pfad durch alle Mathematik und Berechnungen zurückverfolgt werden kann, um die ursprünglichen, integralen Datenwerte zu identifizieren, die der „Samen“-Wert für berechnete Ausgaben von Wert waren. |

| Vermutete Wiederverwendung von Ableitungen | Jeder mathematische oder berechnete Output, der keinen ursprünglichen „Samen“-Wert identifizieren kann, wird an einem Punkt dokumentiert und als Produktion von modellierten/synthetischen Daten identifiziert, um die Identifizierung einer „Überreiche“ von Annahmen zu ermöglichen und als solche in der KI-Ausgabe exponiert. |

(sp/Gartner)