Unternehmen, die ihre KI-Pilotprojekte in den produktiven Betrieb überführen möchten, erleben nicht selten ein böses Erwachen: Die Kosten für das operative KI-System übersteigen die der Testumgebung mitunter stark, wie eine Untersuchung von Gartner offenbart.

Schlecht entwickelte Architekturen mit falschen Werkzeugen, fehlendes operatives Know-how in Verbindung mit unangemessenen Prompt-Engineering-Methoden und unzureichende Governance – eine Überführung von KI-Pilotprojekten in den produktiven Betrieb kommt Unternehmen oft teuer zu stehen. Laut „Gartner AI in the Enterprise Survey“ sind die Kosten aktuell die größten Hürden, wenn es um die KI-Implementierung in Unternehmen geht.

Demnach werden mindestens 50 Prozent aller laufenden KI-Projekte bis 2028 die ursprünglich veranschlagten Investitionen übersteigen. Und: Mehr als die Hälfte der Unternehmen, die eigene Modelle von Grund auf entwickelt haben, werden ihre KI-Bemühungen bis 2028 wegen hoher Kosten, Komplexität und technischer Probleme aufgeben müssen. Die Untersuchung von Gartner zeigt außerdem, dass die Gesamtkosten für die Nutzung des KI-Modells (Modellinferenz) mindestens 70 Prozent der gesamten Lebenszykluskosten des Modells ausmachen werden und damit die Ausbildungskosten deutlich übersteigen. Erschwerend kommt hinzu, dass es IT-Verantwortlichen aufgrund unterschiedlicher Preis- und Bereitstellungsmodelle kaum möglich ist, einen direkten Vergleich über die vielen Angebote anzustellen.

Wahl des richtigen Modells entscheidend

Bei der Auswahl des KI-Modells geht es deshalb oft darum, den richtigen Kompromiss zwischen mehreren Faktoren wie Modellgenauigkeit, Leistung und Kosten zu finden. Besonders die Größe eines KI-Modells (gemessen an der Anzahl seiner Trainingsparameter) hat einen erheblichen Einfluss auf diese Metriken. Denn: Größere KI-Modelle liefern zwar eine höhere Genauigkeit, sind aber oft auch mit höheren Kosten und Verzögerungen bei Modellreaktionen verbunden. Die Auswahl des richtigen Modells sollte deshalb ein multidimensionaler Bewertungsprozess sein, während die Modellgenauigkeit anhand einer breiten Palette von Metriken zur Genauigkeit wie Geläufigkeit, Kohärenz, Relevanz und kontextbezogenes Verständnis validiert werden muss.

Eine Möglichkeit für sicheres Experimentieren mit KI stellt die Schaffung eines KI-Modellgartens mit mehreren Modellen dar, die Nutzern und Entwicklern (als APIs) zur Verfügung stehen. In diesem KI-Modellgarten können verfügbare Modelle als Teil eines Modellkatalogs für die Selbstbedienung dienen, zumal grundlegende Sicherheits- und Datenschutzprinzipien eingehalten werden. Eine gängige Praxis: KI-Modelle von mehr als einem Anbieter zur Verfügung zu stellen und Modelle im Modellkatalog zu mischen. Auf diese Weise sind sowohl große als auch kleine sowie Open-Source- und Closed-Source-KI-Modelle verwendbar.

Vorab- und laufende Kosten evaluieren

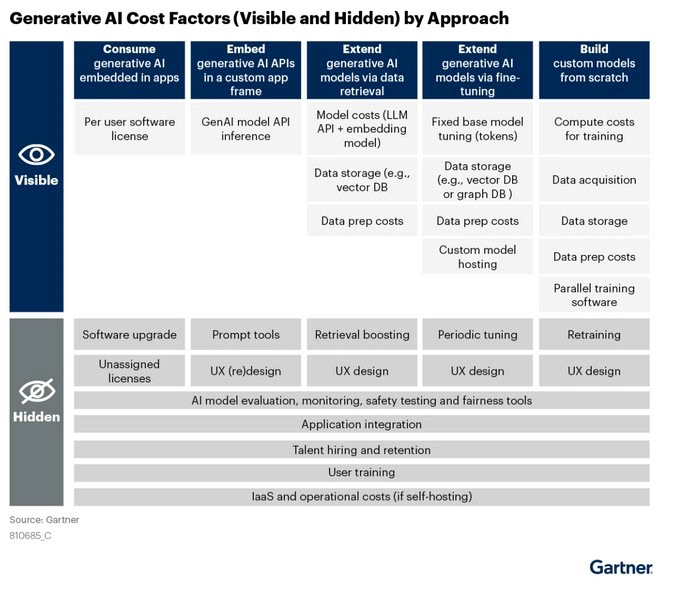

Bei der Erweiterung und Anpassung von KI-Modellen ist es für Unternehmen dennoch unabdingbar, Vorabkosten und laufende Kosten abzuwägen. Vorlaufkosten werden durch die Auswahl verschiedener Ansätze bestimmt, die Modellerweiterungen wie Prompt-Engineering und RAG sowie die Modellanpassung wie inklusive Feinabstimmung und Training umfassen. Die laufenden Kosten lassen sich durch eine sorgfältige Auswahl von Modellen, die ein ausgewogenes Preis-Leistungs-Verhältnis aufweisen, oder durch eine effiziente Feinabstimmung eines Modells auf einem bestimmten Datensatz sowie durch intensives Vortraining reduzieren.

Selbst gehostete Modelle mit erheblichen Fixkosten

Selbst gehostete KI-Modelle eignen sich in der Regel für Unternehmen, die mehr Kontrolle und Datenschutz wünschen. Wichtig dabei: die Liste der Kostentreiber für Self-Hosting-KI ist umfangreich. Denn im Gegensatz zu APIs, PaaS oder IaaS sowie verwalteter Infrastrukturangeboten drohen beim Self-Hosting oft erhebliche Fixkosten, weil eine bedarfsgerechte Skalierbarkeit und Flexibilität nicht oder nur kaum gegeben sind. Die am meisten unterschätzten Aspekte des Selbst-Hostings sind Fähigkeiten und Talente, die für den Eigenbetrieb erforderlich sind, um KI-Anwendungen in großem Umfang zu betreiben. Das liegt vor allem daran, dass KI-Engineering-Tools und das für die Entwicklung und den Betrieb von KI-Systemen erforderliche tiefgreifende Systemwissen häufig noch nicht vorhanden sind.

Prompt-Design und Caching bestimmen Erfolg

Aber auch das Prompt-Design spielt eine wesentliche Rolle für den Erfolg des KI-Übergangs in den produktiven Betrieb. Beim Prompt-Design geht es darum, Prompts – also Eingaben – zu erstellen, die effektiv die gewünschten Antworten von KI-Modellen hervorrufen. Die Erstellung gut strukturierter Prompts ist also entscheidend, um präzise, erstklassige Ergebnisse zu garantieren. Sie haben damit einen erheblichen Einfluss auf die Genauigkeit und Relevanz von Modellantworten, die Anpassungsfähigkeit von Modellen an bestimmte Aufgaben und vor allem auf die Kosten der Modellinferenz. Gut formulierte Prompts benötigen erfordern weniger Tokens, gewährleisten, dass Modellantworten prägnant, relevant und genau sind, und bilden im Allgemeinen eine kostengünstige Methode zur Steuerung von KI-Modellen. Zu den Voraussetzungen für ein effektives Prompt-Design gehören die Bereitstellung eines klaren Kontexts während der Eingabe, eine angemessene Abfolge von Prompt-Anweisungen, die explizite Angabe, was nicht ausgegeben werden soll und die Wiederholung von Prompts. Hier haben sich Prompt-Design-Tools bewährt. Sie zielen auf Anwendungsfälle in Unternehmen ab, bei denen es darum geht, das Prompt-Design zu automatisieren, die Prompts für die Wiederverwendung zu versionieren und komplexe Eingaben aus einfachen natürlichsprachlichen Abfragen zu erstellen.

Einen entscheidenden Beitrag leistet indes auch das Caching von Aufforderungen in Verbindung mit zugehörigen Antworten in einer Datenbank zur späteren Verwendung. Durch das Zwischenspeichern von Antworten auf zuvor gestellte Fragen können Anwendungen, die auf KI-Modellen basieren, schnellere und kosteneffizientere Antworten liefern. So entfällt die Notwendigkeit, Modell-API-Anfragen stets wiederholen zu müssen. Dieser Mechanismus des Zwischenspeicherns funktioniert sowohl bei exakten Übereinstimmungen wie der doppelten Verwendung derselben Frage als auch bei ähnlichen Übereinstimmungen, etwa, wenn zwei Fragen die gleiche Bedeutung haben. Ein Beispiel: „Wer war der erste Mensch auf dem Mond?“ und „Sagen Sie mir, wer zum ersten Mal einen Fuß auf den Mond gesetzt hat“ sind zwar nicht identische Aufforderungen, würden aber identische Antworten liefern und somit einen API-Aufruf einsparen. Für LLM-Zwischenspeicherungen stehen mittlerweile mehrere Tools zur Verfügung. Dazu gehören GPTCache, LangChain (u. a. mit einer Caching-Funktion), Cloudflare AI Gateway und Composable Prompts.

Viele Tools für das Modell Routing erhältlich

Schließlich hat sich das Modell-Routing zu einer brauchbaren Methode entwickelt, um optimale LLM dynamisch auszuwählen. Das Prinzip: Ein Router-Modell wie das von Martian sagt die Genauigkeit verschiedener LLMs für eine bestimmte Eingabeaufforderung vorher und wägt diese Genauigkeit gegen die Kosten der Schlussfolgerung und andere Anforderungen wie Latenz ab. Klar ist: KI steckt noch in den Kinderschuhen, weshalb die Kosten für eine Implementierung im Produktivbetrieb kaum valide berechnet werden können. Sind aber die wichtigsten Voraussetzungen erfüllt, lässt sich die Preisspanne bereits heute relativ gut eingrenzen.