Für das Training von KI-Anwendungen sind neue Datenarchitekturen notwendig.

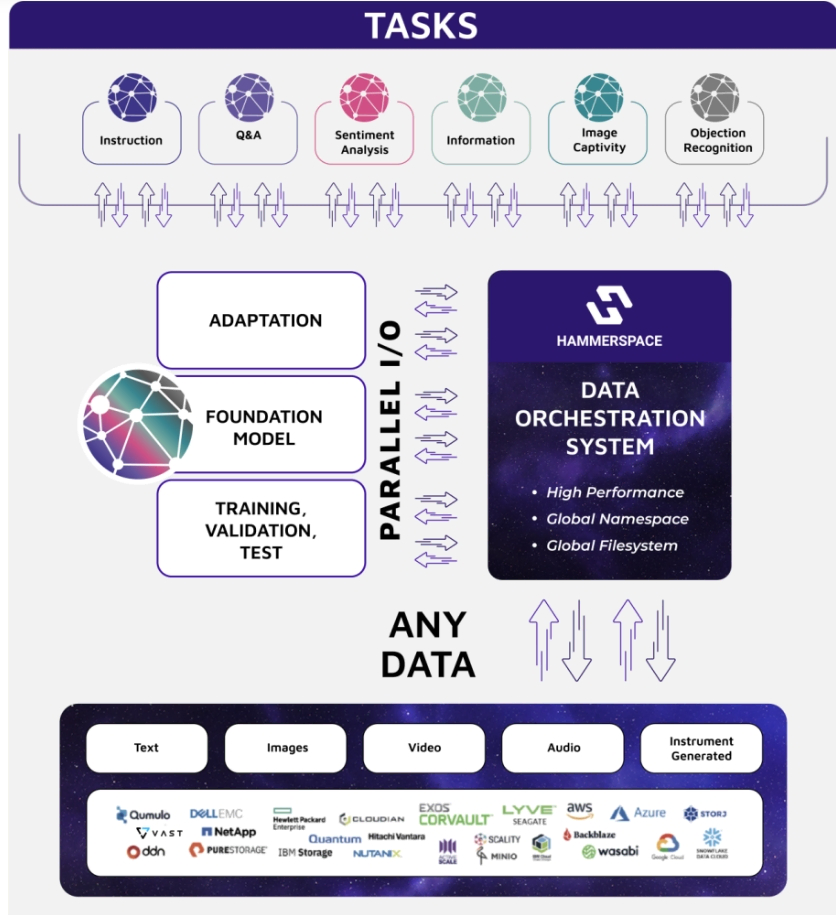

Hammerspace Inc. ist ein Unternehmen, das sich genau auf diese Art der Entwicklung von Datenarchitekturen spezialisiert hat, die für das Training von großen Sprachmodellen (Large Language Models, LLMs) in hyperskalen Umgebungen verwendet werden. Ein Bestandteil ist dabei ein System zur Datenorchestrierung, das das Innovationspotenzial unstrukturierter Daten freisetzt. Es bietet seinen Anwendern mit ihren Daten und Anwendungen die Möglichkeit ihre Lösungen auf den verschiedensten Cloud-Diensten wie AWS, Google Cloud, Microsoft Azure und Seagate Lyve Cloud zu nutzen.

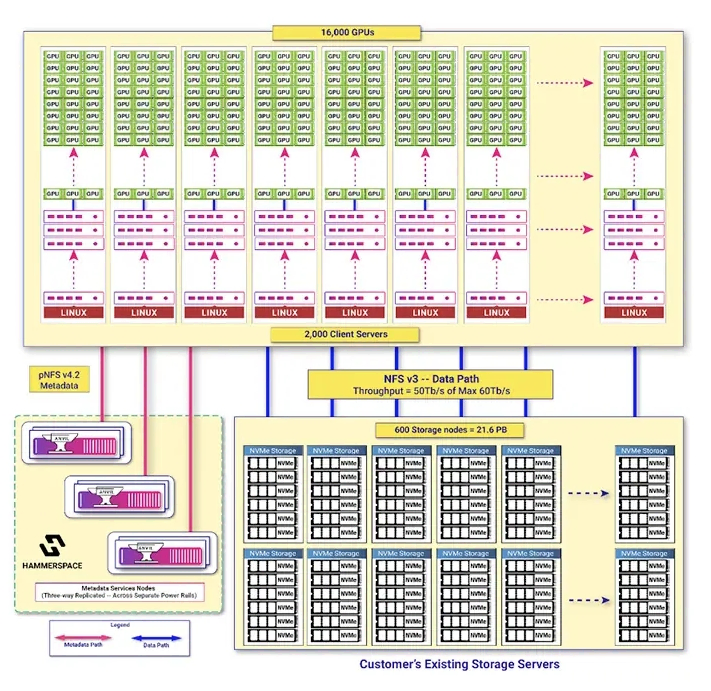

Die Architektur ermöglicht es so KI-Entwicklern, eine einheitliche Datenarchitektur zu entwerfen, die die Leistung eines parallelen Dateisystems auf Supercomputer-Niveau bietet, zugleich aber auch einen einfachen Anwendungs- und Forschungszugang über das Standard-Network File System (NFS) ermöglicht.

Ein wichtiger Aspekt bei der Entwicklung von LLMs ist die Fähigkeit, auf eine große Anzahl von GPUs zu skalieren und Zugang zu lokalen und verteilten Datensilos zu haben. Die Hammerspace-Architektur vereint den gesamten Datenpipeline-Prozess in einem einzigen, parallelen globalen Dateisystem, das bestehende Infrastruktur und Daten mit neuen Datensätzen und Ressourcen integriert. Dies ist besonders kritisch für LLMs, die oft Hunderte von Milliarden von Parametern, Zehntausende von GPUs und Hunderte von Petabyte verschiedener Arten unstrukturierter Daten benötigen.

Der Aufbau

Die Hammerspace-Architektur bietet eine fehlertolerante Konstruktion und ermöglicht es, dass LLM-Umgebungen auch bei Systemausfällen auf Höchstleistung operieren können. Die Software entkoppelt die Dateisystemebene von der Speicherebene, was eine unabhängige Skalierung von I/O und IOPS auf Datenebene ermöglicht. Außerdem unterstützt Hammerspace eine Software-Defined-Datenplattform, die mit jedem standardbasierten Hardwarekomponenten kompatibel ist, was Organisationen ermöglicht, von kosteneffektiver Infrastruktur im großen Maßstab zu profitieren.

Darüber hinaus minimiert Hammerspace den Bedarf, Dateien in ein neues, konsolidiertes Repository zu kopieren und zu verschieben, was die Effizienz steigert und das Risiko von Fehlern und Ungenauigkeiten in LLMs verringert. Daten werden auf Anwendungsebene über eine standardmäßige NFS-Dateischnittstelle zugegriffen, was direkten Zugang zu Dateien im Standardformat ermöglicht, für das Anwendungen typischerweise konzipiert sind.

Referenzarchitektur

Die Referenzarchitektur integriert verschiedene technologische Komponenten und Methoden, um effiziente, skalierbare und robuste Lösungen für das Training von LLMs zu ermöglichen.

Zu den Schlüsselaspekten gehören:

- Hochleistungs-Parallel-Dateisystem: Dies ermöglicht den simultanen Zugriff auf Daten von zahlreichen Prozessen oder Knoten, was für das Training von KI unerlässlich ist. Es verbessert die Effizienz und reduziert Engpässe im Workflow.

- Standardbasierte Softwareansätze: Die Nutzung von Standards wie NFS4.2 im Linux-Betriebssystem ermöglicht einen direkten und hochleistungsfähigen Zugang zu Daten über die Hammerspace-Software.

- Einsatz auf Standard-Hardware: Hammerspace bietet eine softwaredefinierte Datenplattform, die mit jeder standardbasierten Hardware kompatibel ist, was eine kosteneffektive Skalierung ermöglicht.

- Vereinfachung von Datenpipelines: Durch die Schaffung einer einheitlichen globalen Datenumgebung ermöglicht Hammerspace die gleichzeitige und kontinuierliche Ausführung aller Phasen des LLM-Trainings und der Inferenz.

- Hochgeschwindigkeits-Datenpfad: Reduziert Netzwerkübertragungen und Datenbewegungen, um eine nahezu 100-prozentige Auslastung der verfügbaren Infrastruktur zu gewährleisten.

- Fehlertolerantes Design: Ermöglicht es, dass LLM-Umgebungen auch bei Systemausfällen mit Höchstleistung betrieben werden können.

- Zielbasierte Datenplatzierung: Die Entkopplung von Dateisystem und Speicherschicht ermöglicht eine unabhängige Skalierung und automatische Datenplatzierung basierend auf vorgegebenen Zielen.

Fazit

Diese Ankündigung von Hammerspace ist das Ergebnis mehrjähriger Entwicklung und eines Reifeprozesses. Es zeigt die Rolle des Unternehmens als wichtigen Akteur im Bereich der Dateidatenzugriffsmethoden, die eine Vielzahl von Mechanismen anbieten. Hammerspace bietet GDE, pNFS, einen proprietären Parallelmodus mit RozoFS und kürzlich S3-to-Tape an. Ohne auf die Vergangenheit von Primary Data und Tonian Systems und deren Verbindung zu Hammerspace einzugehen, bedeutet dies, dass das Unternehmen heute eine der flexibelsten Möglichkeiten auf dem Markt bietet, um auf Dateidaten mit de-facto oder Industriestandards zuzugreifen.

Dies ist ein gutes Beispiel für das vor über zehn Jahren definierte U3 – Universal, Unified und Ubiquitous – Storage-Modell. Es bestätigt auch die Fähigkeiten von pNFS, die von Speicheranbietern schlecht beworben werden, und bietet für einige von ihnen einige Iterationen von Scale-out-NAS und für andere einige Implementierungen von parallelen Dateisystemen oder basierend auf Lustre.