Durch die Kombination neuronaler Netze und verteilter Softwarearchitekturen entsteht die nächste Generation ECM-/EIM-Software (Enterprise Content Management, Enterprise Information Management) und hebt die Latte für smarte Lösungen auf ein neues Niveau.

Eine Menge Informationen schlummern in den Datenbeständen deutscher Unternehmen. Vor allem Archivsysteme, die seit vielen Jahren von unterschiedlichen Anwendungen bedient werden, enthalten Daten, deren Informationsgehalt nicht ansatzweise nutzenbringend eingesetzt wird. Das liegt in erster Linie daran, dass klassische Archiv- oder auch ECM-Systeme Dokumentinformationen nur auf Kopfebene erfassen. Detaillierte Inhalte sind im Normalfall nicht abrufbar oder nur durch ungenaue, teure und aufwendige Prozeduren wie beispielsweise einer Volltextindizierung zu finden. Ganz zu schweigen von einer strukturierten Aufbereitung dieser Informationen zur weiterführenden Verarbeitung. Eine technische Lösung das künftig zu ändern, liefert das IT-Unternehmen Deepshore aus Hamburg.

Software wandelt Daten um

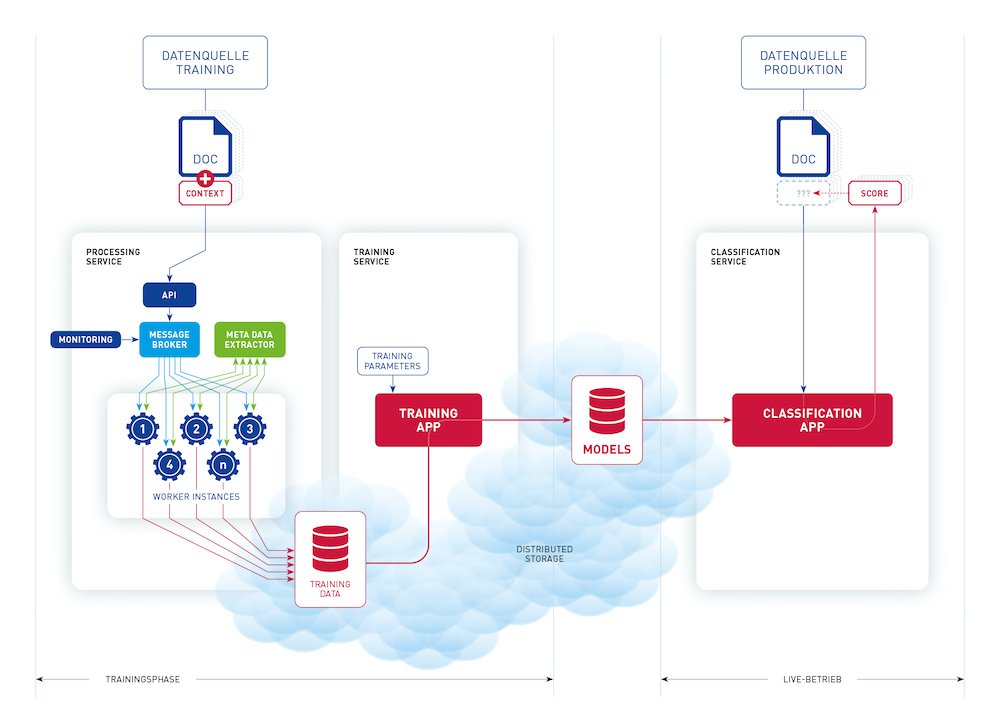

Die Hamburger Software-Ingenieure haben auf Basis von Open-Source-Projekten und Google-Technologien eine Software entwickelt, die in der Lage ist, auch unstrukturierte Bildformate wie beispielsweise TIFF oder BMP zunächst in les- und analysierbare Daten umzuwandeln und damit Inhalte zu erkennen. Diese Informationen können dann mittels eines neuronalen Netzes automatisch analysiert und klassifiziert werden. Je nach Anforderung ist es möglich, auf diese Weise gewonnene Erkenntnisse auch so zu speichern, dass nicht auf die gewohnte Compliance-Fähigkeit klassischer ECM-Systeme verzichtet werden muss. Diesen Teil der Lösung ergänzt Deepshore mit seinem verteilten Cloud-Archiv auf Basis von Blockchaintechnologie. Deepshore arbeitet als Innovation Hub des ECM-Spezialisten nextevolution – ebenfalls aus Hamburg – und hat das verteilte Cloud-Archiv 2019 im Rahmen einer Forschungskooperation mit dem Handelskonzern METRO entwickelt.

Infrastrukturelle Flexibilität

Einer der großen Vorteile gegenüber herkömmlichen technischen Ansätzen in diesem Bereich ist die infrastrukturelle Flexibilität der Lösung. Durch die eingesetzte Containertechnologie kann Software vollständig als Service in einer Cloud, im eigenen Rechenzentrum oder auch hybrid als Mischung aus beidem, betrieben werden. Aufwendige Installationen werden dadurch überflüssig, und bei richtiger Konfiguration kann mit steigender Last der Ausbau eines Systems nahezu vollautomatisch skaliert werden.

Nach der Entwicklung kann das neuronale Netz nun mit Echtdaten trainiert werden. Deepshore verspricht sich durch das neue System im trainierten Zustand wesentlich bessere Erkennungsraten im Vergleich zu bisherigen Lösungen – wie etwa einer klassischen OCR (Optical Character Recognition – automatisierte Texterkennung in Bildern) in Kombination mit vordefinierten Suchmustern auf Basis von Regular Expressions. Darüber hinaus werden in Zukunft die gesamten Betriebskosten der Dokumentenerkennung und Klassifizierung signifikant geringer sein.

Bild: Prinzip Neuronale Netze (Quelle Andreas Otto, sense:ability Berlin)

Trainingslager für künstliche Intelligenz

So avanciert zum Beispiel eine lästige Datenmigration zum Trainingslager für künstliche Intelligenz. Durch die technische Ausprägung als Service kann das „Training“ dabei fast vollständig entkoppelt von einer Migrationsinfrastruktur laufen. Elegant ist dieser Ansatz vor allem deshalb, weil das System mit jedem Trainingseinsatz das Prinzip besser „versteht“, dazulernt und sich mit diesen Trainingsergebnissen weiter optimieren lässt. Wenn das System zum Beispiel mit den anonymisierten Daten verschiedener Unternehmen einer Branche „gefüttert“ wird, entsteht eine Branchenoptimierung, die allen Anwenderunternehmen nützt. In der Frühphase des Trainings ist es wichtig, das Netz korrekt zu initialisieren. Das Konzept kann dabei mit dem Training einer Sportmannschaft verglichen werden. Auch hier ist ein Trainer gefragt, der mit der Grundaufstellung und dem Herstellen körperlicher Fitness die Basis für taktische Feinheiten und den weiteren Erfolg legt.

Das Einsatzgebiet dieser neuronalen Services ist nicht auf einzelne Branchen beschränkt. So kann quasi jeder Datenbestand oder jedes Archivsystem dazu genutzt werden, entsprechende Informationen zu extrahieren und gewinnbringend einzusetzen.

Als Experte für die Verarbeitung von Compliance-Daten und als Thinktank des IBM Partners nextevolution hat Deepshore die eigene Lösung bereits heute vollständig in die neue IBM Automation Platform for Digital Business integriert. Damit können IBM-Kunden beispielsweise den IBM Business Automation Content Analyzer verbinden, um weiteren Mehrwert aus vorhandenen Datenströmen nutzbar zu machen.

www.deepshore.de