Was kann ich mit dem jeweiligen Service verdienen und was kostet mich seine Bereitstellung? Diese Frage stellen sich Dienstanbieter immer wieder. IT-Services haben in der Vergangenheit zugenommen. Aber: ist das noch der richtige Weg?

Was kann ich mit dem jeweiligen Service verdienen und was kostet mich seine Bereitstellung? Diese Frage stellen sich Dienstanbieter immer wieder. IT-Services haben in der Vergangenheit zugenommen. Aber: ist das noch der richtige Weg?

Ausgehend von bestimmten Anforderungen wurden Lösungsarchitekturen entwickelt, implementiert und dann einem Betrieb übergeben. Monitoring und Service Management kamen dabei in der Regel erst im Nachhinein hinzu. Auch bei agilen und Cloud-basierten Services werden Dienste bereitgestellt und – wenn überhaupt – meist erst im Nachgang überwacht.

On-Premise Services als klassischer Ansatz

Was sind IT-Services? Die Antwort auf diese Frage fällt je nach Branche unterschiedlich aus. In einem Telekommunikationsunternehmen sind IT-Services in der Regel sogenannte Tripple oder auch Quad Plays: (Festnetz-)Telefonie, Internet, TV und dazu Wireless im Sinne von Mobilfunk. Fallende Margen durch zunehmende Konkurrenz wurden kompensiert durch ″Value Added Services“, also Angebote, die zusätzliches Geld einbringen sollen. Banken und Versicherungen stellen Kundenportale mit ihrem Leistungsspektrum zur Verfügung. Bahnunternehmen haben Automaten zum Verkauf von Fahrkarten. Gemeinsam ist allen Services, dass sie auf vielen IT-Komponenten basieren, die nur zusammen bestehende Erwartungen − meist im Hinblick auf das Antwortzeitverhalten und den Inhalt − erfüllen.

Wie sehen nun Service Management und der Betrieb einer komplexen Infrastruktur aus? Die Österreichischen Bundesbahnen (ÖBB) bieten etwa derzeit rund 700 interne und externe Services an. Die IT-Infrastruktur erstreckt sich als Beispiel über 4300 physische Server und 2500 Datenbanken. Das IT-Management besteht hier aus verschiedenen Disziplinen, die sich am ITIL Framework orientieren. Der kritische Erfolgsfaktor für das Service Management der ÖBB liegt darin, einzelne Management-Komponenten miteinander in Bezug zu setzen.

Ein Discovery Tool erforscht regelmäßig das Netz der ÖBB und berichtet die identifizierten Komponenten in eine zentrale configuration management database (CMDB). Bei diesem Schritt werden Zusammenhänge wie Server Cluster erkannt und in die CMDB mit eingebracht, wobei nicht zu viele und nicht zu wenige Details einzelner CIs in die CMDB vermittelt werden sollten. Das Monitoring wird auf Komponenten mit Einfluss auf das Service Management beschränkt und die sich daraus ergebenden Statusinformationen an das Event Management übergeben. Hier berechnet ein Impact Manager, welchen Einfluss eine Statusänderung auf die überwachten Services hat. Das Ganze fließt dann in ein übergeordnetes Service-orientiertes Dashboard, woarauf Servicemanager, Administratoren und der Betrieb Zugriff haben.

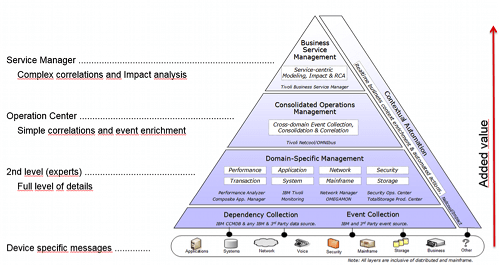

Durch solche hochintegrierte Management-Lösungen lassen sich Einsparungen im Betrieb erzielen. Das Reporting dokumentiert dabei die Einhaltung der SLAs. Hier ist die Interaktion zwischen Systemen und Prozessen der Schlüssel zum Erfolg. Ein Beispiel: ein Discovery-Prozess kann nur einen bestimmten Prozentsatz an IT-Infrastruktur erkennen. Dieser Teilprozess ermöglicht, dass die Servicemodelle weitgehend aktuell sind. Die Relation von CI zur Servicekomponente kann so größtenteils automatisiert werden. Weitere Verbindungen zum Service müssen letztendlich oft von Hand nachgezogen werden. Die Erfahrung aus vielen IT Service Management-Projekten zeigt, dass selbst wenn diese Erkenntnis vorliegt, die Relationen auch nur dann gezogen werden, wenn jeder Service im Dashboard sichtbar ist. Konsolidierte Informationen und die Integration verschiedener Quellen in wenigen Dashboards ermöglichten im Falle der ÖBB einen ROI von 30 Tagen. Die nachfolgende Bild 1 verdeutlicht diese Wertschöpfungskette.

Bild 1: Wertschöpfungskette im IT-Service Management.

Einsparung durch Virtualisierung

Der Ansatz „Dedicated Server“ führt zu einer geringen Auslastung der Systeme. Sun Microsystems führte 2005 mit dem Betriebssystem Solaris 10 ein Konzept der sogenannten Zonen ein, wobei es sich um eine erste Virtualisierung handelt. Solaris Zonen können auch als erste Container Services angesehen werden so wie sie heute weiterentwickelt zum Beispiel von Docker und anderen Anbietern auf dem Markt sind.

Das Konzept, Server durch die gemeinsame Nutzung virtueller Komponenten besser auszulasten, breitete sich durch die erheblichen Einsparungen aus. In einem Artikel von Heise online berichtet VM Ware von einer Befragung von 1800 Kunden, derzufolge durch den Einsatz von VM Ware beim Energiebedarf und der Anschaffung neuer Hardware durchschnittlich 30 Prozent Einsparung erzielt wurden. Dabei wurde die erzeugte Abwärme in vielen Rechenzentren mehr und mehr zu einem Hauptproblem.

Hybride Services als Weg zum schnellen Erfolg

Der Grad der Virtualisierung schreitet mit Cloud-basierten Diensten weiter voran: Infrastructure as a Service (IaaS), Plattform as a Service (PaaS) und Software as a Service (SaaS) sind nur einige der xaaS-Dienste in der Cloud. Wer lediglich sein Rechenzentrum auflösen möchte, aber alles so beibehalten möchte wie gehabt, nutzt die Bare Metall-Angebote beispielsweise von IBM. Ein nächster Schritt kann dann der Umstieg auf virtuelle Server darstellen. Dort lassen sich die IT-Strukturen mit wenigen Anpassungen weiter betreiben. Beschaffung, Aufbau, Wartung und Upgrade der Hardware fallen weg. Die Verfügbarkeit wird je nach Vertrag durch den Anbieter gewährleistet. Ein eigenes Monitoring durch den Kunden ist möglich, indem etwa eigene Agenten auf den Servern mitinstalliert werden. Gegenüber einem physischen Server ist hier der Vorteil, dass die Leistungsfähigkeit nachträglich leicht gesteigert werden kann, indem RAM, Disc oder CPU Cores hinzugefügt werden.

PaaS-Dienste bieten Service-Komponenten wie Datenbanken, Web- oder Applicationserver fertig an. Für den Dienstnehmer ist die unterliegende Hardware nicht mehr greifbar. So kann zum Beispiel kein Monitoring-Agent mehr dazu installiert werden. Trotzdem ist man auch hier dem Anbieter nicht ausgeliefert, denn je nach Anbieter und Vertrag sind Detailinformationen wie Logfiles verfügbar. Dazu kann von außen die Dienstqualität überwacht werden, indem der jeweilige Service etwa mit synthetischen Transaktionen gemessen wird. Als Vorteil dieses Services können dynamische Lastanforderungen automatisiert abgefedert werden, indem die Systemressourcen zeitnah angepasst werden. Darüber hinaus braucht der Dienstnehmer den jeweiligen Dienst weder zu installieren, noch zu warten.

Bereitstellung

Die Anwendung SaaS wird über APIs oder ein Webinterface zur Verfügung gestellt. Ein Benutzer kann mit den Werkzeugen von Cloud-Anbietern seine Anwendungen selbst maßschneidern. Ähnlich wie in einem PaaS-Angebot kann auch hier die Dienstgüte etwa mit synthetischen Transaktionen gemessen werden. Dabei ist die unterliegende Hardware vollkommen abstrahiert und auch Teilservices wie Datenbanken, sofern sie nicht selbst erstellt wurden, sind nach außen nicht sichtbar. Ein Management von Teilservices, sogenannte Microservices, ist aber möglich, wenn während des Designs entsprechende Unterstützung − wie APIs − eingebaut wird.

Durch Cloud-basierte Dienste lassen sich enorme Einsparungen erzielen. Dies ist insbesondere für kleinere und mittlere Unternehmen interessant, weil sie ihre IT-Infrastruktur nicht mehr selbst halten und betreiben müssen. Zusätzlich lohnt es sich schon beim Design der Anwendungen ein Monitoring mit vorzusehen und so eine Überwachung und den Betrieb zu vereinfachen oder gar erst zu ermöglichen. Hybride Modelle − also lokale und Cloud-basierte Dienste im Mischbetrieb − vereinfachen oder ermöglichen den Übergang von der klassischen on-premise IT zur Cloud-basierten IT.

Fred Klein ist Client Technical Professional, Executive IT-Specialist, IBM Hybrid Cloud