Seit der Entdeckung von LLMJacking durch das Sysdig Threat Research Team (TRT) im Mai 2024 hat sich dieser Bedrohungsvektor rasant weiterentwickelt. So wie sich große Sprachmodelle (LLMs) ständig verbessern und neue Anwendungen finden, passen sich auch Cyberkriminelle an und nutzen neue Wege, um sich unbefugt Zugang zu diesen leistungsstarken Systemen zu verschaffen.

Besonders auffällig ist die schnelle Expansion auf neue LLMs wie DeepSeek.

Bereits im September 2024 berichtete Sysdig TRT über die wachsende Popularität dieser Angriffe. Der Trend hat sich verstärkt: „Wir waren nicht überrascht, dass DeepSeek innerhalb weniger Tage nach seiner Medienpräsenz ins Visier genommen wurde.“ Auch große Unternehmen wie Microsoft sind betroffen – eine Klage gegen Cyberkriminelle, die gestohlene Anmeldedaten missbrauchten, hat für Aufsehen gesorgt. Die Beklagten sollen DALL-E genutzt haben, um anstößige Inhalte zu generieren.

Warum LLMJackers lieber klauen als zahlen

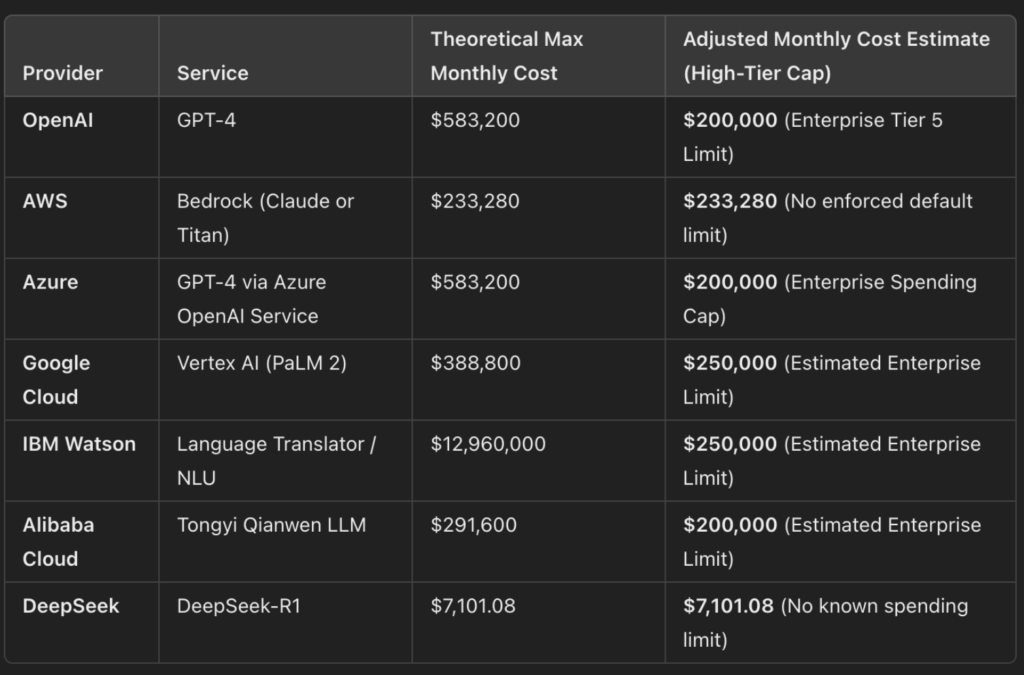

Der Betrieb von LLMs kann immense Kosten verursachen – oft mehrere hunderttausend Dollar pro Monat. Sysdig TRT entdeckte über ein Dutzend Proxyserver, die gestohlene Anmeldedaten für verschiedene Dienste wie OpenAI, AWS und Azure nutzten. Die Täter setzen auf ein einfaches Prinzip: Warum bezahlen, wenn man auch stehlen kann?

Ein Beispiel für diese schnellen Übernahmen zeigt sich bei DeepSeek: Am 26. Dezember 2024 wurde das Modell DeepSeek-V3 veröffentlicht, und nur wenige Tage später war es bereits in einer ORP (oai-reverse-proxy)-Instanz auf HuggingFace integriert. Noch schneller ging es mit DeepSeek-R1: Nur einen Tag nach Veröffentlichung war das Modell bereits über einen kompromittierten Proxy nutzbar.

Neue Methoden und organisierte Communities

LLMJacking ist längst kein isoliertes Phänomen mehr. Online-Communities haben sich gebildet, in denen Tools und Techniken zum Missbrauch von LLMs geteilt werden. Besonders aktiv sind Plattformen wie 4chan und Discord. Zugangsdaten werden über Plattformen wie Rentry.co gehandelt, die sich durch ihre Anonymität und einfache Bearbeitungsmöglichkeiten als idealer Treffpunkt für Kriminelle erweisen.

Bei Untersuchungen von Cloud-Honeypots entdeckte Sysdig TRT mehrere TryCloudflare-Domains, die in Kombination mit ORPs verwendet wurden, um den Zugriff auf LLMs zu automatisieren. Der Modus Operandi: Anmeldeinformationen stehlen, testen und über Proxies weiterverkaufen.

Die Tricks der Angreifer: Automatisierung und Anonymität

Die Angreifer setzen auf hochentwickelte Skripte zur Verifizierung gestohlener Zugangsdaten. Besonders anfällig sind Systeme mit Schwachstellen in Frameworks wie Laravel, über die Anmeldeinformationen extrahiert werden. Diese Skripte haben einige gemeinsame Eigenschaften:

- Gleichzeitigkeit: Um eine große Menge an gestohlenen Schlüsseln effizient zu testen.

- Automatisierung: Minimaler Aufwand, maximaler Profit.

Öffentliche Software-Repositories sind eine weitere ergiebige Quelle für Zugangsdaten. Häufig werden versehentlich API-Schlüssel in Code-Repositories wie GitHub veröffentlicht, was Cyberkriminelle ausnutzen.

Wie man sich gegen LLMJacking schützt

LLMJacking basiert meist auf gestohlenen Anmeldedaten oder Zugangsschlüsseln. MITRE hat diesen Angriffsvektor inzwischen in sein Attack Framework aufgenommen, um die Bedrohung sichtbar zu machen. Unternehmen und Entwickler sollten folgende Schutzmaßnahmen ergreifen:

- Zugangsschlüssel sichern: API-Schlüssel niemals fest im Code hinterlegen. Stattdessen Umgebungsvariablen oder Secret-Management-Tools wie AWS Secrets Manager oder HashiCorp Vault nutzen.

- Temporäre Anmeldedaten verwenden: Lösungen wie AWS STS AssumeRole oder Azure Managed Identities einsetzen.

- Schlüssel regelmäßig rotieren: Automatisierte Prozesse zur Schlüsselrotation implementieren.

- Exponierte Anmeldedaten überwachen: Tools wie GitHub Secret Scanning oder TruffleHog nutzen.

- Ungewöhnliche Aktivitäten erkennen: Verdächtiges Verhalten in Cloud- und KI-Diensten durch Monitoring-Tools wie Sysdig Secure aufspüren.

Fazit: LLMjacking wird bleiben

Die steigende Nachfrage nach KI-Modellen hat einen Schwarzmarkt für den Zugang zu LLMs entstehen lassen. Kriminelle Netzwerke entwickeln immer neue Methoden, um gestohlene Anmeldedaten zu monetarisieren und LLMs für illegale Zwecke zu nutzen. Während sich Cyberkriminelle anpassen, müssen Unternehmen und Nutzer ihre Sicherheitsstrategien kontinuierlich verbessern, um dieser Bedrohung einen Schritt voraus zu sein. Die Frage ist nicht, ob LLMJacking weitergehen wird – sondern, wie wir uns dagegen wappnen.

(vp/Sysdig)