Mit generativer KI zu arbeiten, ist für viele heute schon Alltag. Doch GenAI macht Fehler und tischt uns Falschinformationen auf. Um dem vorzubeugen, braucht die KI ein Korrektiv. Knowledge Graphen liefern den nötigen Kontext, um KI-Halluzinationen zu reduzieren.

Erfundene Finanzzahlen, falsche Angaben über physikalische Gesetze, fiktive Gerichtsentscheidungen: Wer kennt keine Beispiele für die Halluzinationen von generativen KI wie ChatGPT und Google Bard? Diese Fehlleistungen sind zuweilen lustig. Aber sie können Unternehmen und der Gesellschaft enorm schaden.

Um dem vorzubeugen, reicht es nicht, die Nutzer für das Problem zu sensibilisieren und ihnen Faktenchecks ans Herz zu legen. Das lindert nur die Symptome, ohne die Ursache zu beheben. Es ist zwingend nötig, die Systeme selbst zu verbessern. Das bedeutet: Wir müssen Large Language Models (LLMs) so trainieren, dass sie Kontext verstehen. Mithilfe von Graphtechnologie ist das machbar.

Wie KI-Halluzinationen entstehen

LLMs verlassen sich auf Wahrscheinlichkeiten. Wenn sie auf eine Anforderung (Prompt) reagieren, errechnen sie, welche Wörter statistisch gesehen am wahrscheinlichsten als Antwort passen. Wie sie das jedoch berechnen, ist von außen nicht nachvollziehbar.

Zahlreiche Beispiele zeigen: Die KI entscheidet sich immer wieder falsch. Sie behauptet unwahre Tatsachen, denkt sich Fakten aus und gibt Vorurteile weiter, die in ihren Trainingsdaten enthalten sind. Dieses Verhalten nennt man „Halluzination“. Es wirkt zuweilen, als ob die KI sich nicht die Blöße geben wollte, etwas nicht zu „wissen“.

Halluzinationen treten auf, wenn der KI der Kontext fehlt. Wenn sie nicht weiß, dass sie Informationen aus bestimmten Quellen heranziehen muss, um eine fundierte Antwort geben zu können. Dann bleibt ihr nur, sich an ihre strikten, statistischen Regeln zu halten – oder zu halluzinieren.

Knowledge Graphen liefern Kontext

In der Praxis bedeutet das zum Beispiel: Das intelligente System eines autonom fahrenden Autos muss wissen, dass Regen nicht gleich Regen ist. Es muss erkennen, ob nur ein paar Tropfen vom Himmel fallen, ob sich Hagel in den Regen mischen wird oder ob Sturmböen Regengüsse über die Straße peitschen. Hierfür braucht die KI eine Vielzahl an peripheren und miteinander verknüpften Informationen: den Kontext. Eine Möglichkeit, wie GenAI den Kontext einbeziehen kann, ist einen Knowledge Graphen zu verwenden.

Ein Graphmodell besteht aus einzelnen Datenpunkten (Knoten) mit verschieden Eigenschaften sowie aus Beziehungen (Kanten). Um sich das vorzustellen, wird häufig das Beispiel eines U-Bahn-Fahrplans herangezogen: Die Haltestationen sind die Knoten, die Schienen zwischen ihnen sind die Kanten. Ein Algorithmus läuft die Kanten und Knoten ab und kann daraus unter anderem die kürzeste Route zwischen zwei Haltestationen errechnen. Ein Knowledge Graph zeigt, was die Datenpunkte miteinander verbindet.

Graphtechnologie wird heute quer durch alle Branchen eingesetzt. Mithilfe von kontextreichen Knowledge Graphen von Neo4j macht zum Beispiel die NASA ihren Ingenieuren den Wissensstand aus über 50 Jahren Raumfahrtforschung in ihrer Lessons-Learned-Datenbank zugänglich. Ein anderes Beispiel: Knowledge Graphen, die mit externen Datenquellen verbunden sind, unterstützen Unternehmen dabei, ihre Lieferketten zu überwachen oder Compliance-Risiken zu analysieren.

Knowledge Graphen organisieren Daten aus verschiedenen Quellen und stellen alle Einheiten, Eigenschaften und Datenbeziehungen bereit, die bei einer Abfrage relevant sind. Im Fall des autonomen Fahrens heißt das: Der Knowledge Graph erfasst meteorologische Daten, das Datum, den Ort sowie Informationen über die Fahrbahnbeschaffenheit und die Verkehrslage und verbindet diese.

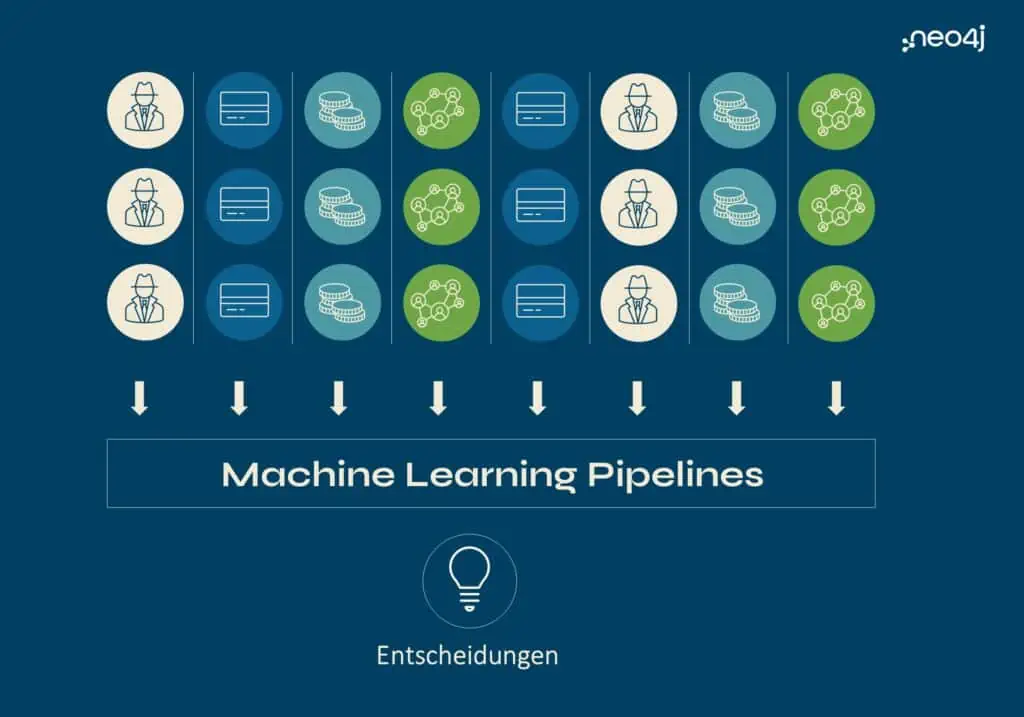

Bild 1 zeigt, wie Machine Learning Pipelines ohne Graph „gefüttert“ werden – mit Daten ohne Beziehungen und ohne Kontext. (Bildquelle neo4j)

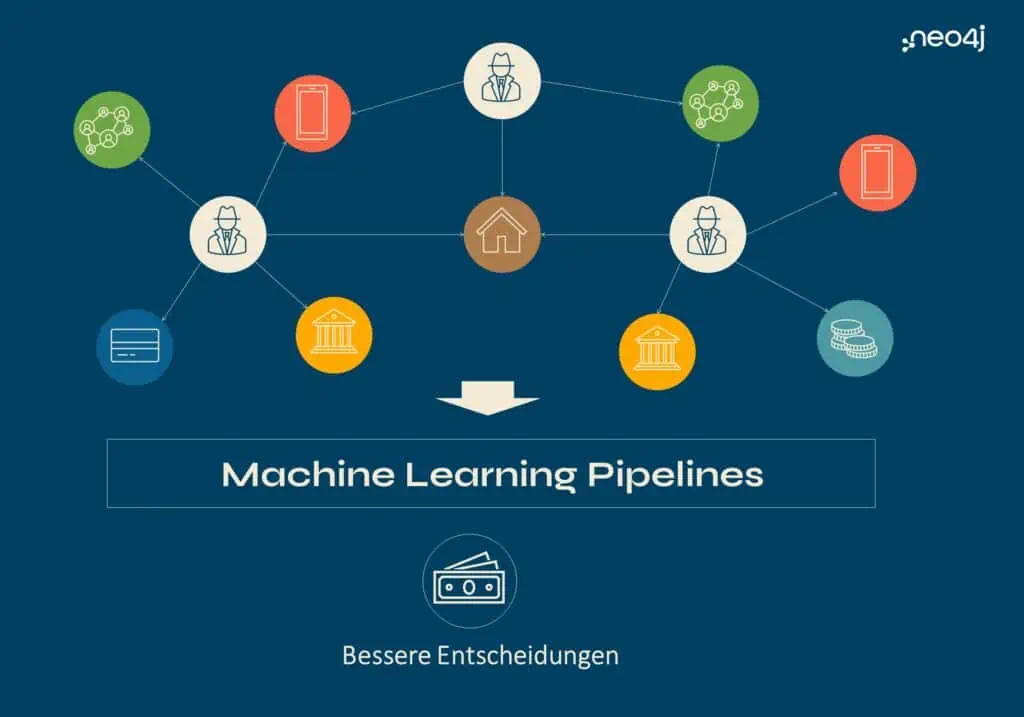

Bild 2: Mit einem Knowledge Graphen geht auch das Wissen um Beziehungen und Kontext in die Machine Learning Pipeline ein. Das führt zu besseren Entscheidungen. (Bildquelle neo4j)

Mit „goldenen Beziehungen“ Fehler finden

Je mehr Daten in einem Knowledge Graph miteinander verbunden sind, auf desto mehr Kontext kann eine KI zurückgreifen – und desto mehr sinnvolle Verknüpfungen kann sie selbstständig herstellen. Um das System zusätzlich zu unterstützen, können bei der Entwicklung „goldene Beziehungen“ (analog zu „golden records“) festgelegt werden. Diese dienen dem System als Maßstab, sodass der Knowledge Graph darauf basierend die Fehler des LLM ausbessern kann. Die Korrekturen können daraufhin für das verfeinerte Training genutzt werden.

Die goldenen Beziehungen helfen zudem, die Antworten und Vorhersagen von KI-Systemen nachzuvollziehen. Denn dank der Knoten und Kanten lassen sich Informationen bis zu ihrer Quelle zurückverfolgen. Anwender können sehen, welche Algorithmen welche Daten zur Beantwortung eines Prompts herangezogen haben. Das schafft Transparenz und Vertrauen.

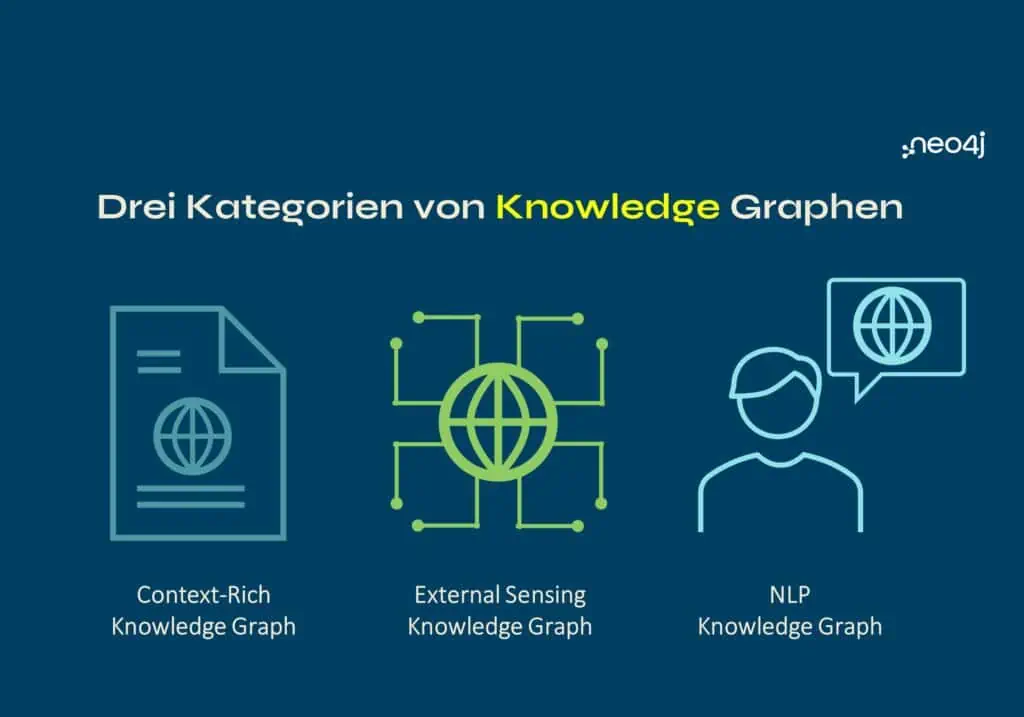

Bild 3: Die drei Kategorien von Knowledge Graphen, die Kontext für KI liefern können. (Bildquelle neo4j)

Sprachgewandte Knowledge Graphen

Natural Language Processing (NLP) Knowledge Graphen können die Komplexität und Nuancen unserer Sprache innerhalb eines Datenmodells abbilden – und zwar so, dass das KI-System sie abfragen kann. Das funktioniert, indem der NLP-Graph eine Ontologie aufbaut.

Diese Ontologie kann zum Beispiel unternehmensspezifische Fachbegriffe, Produktnamen, Branchenkürzel und Sachnummern erfassen. Auch gängige Rechtschreibfehler oder Missverständnisse lassen sich hinterlegen. Durch die Verknüpfung all dieser Informationen kann die KI den Kontext zu unternehmensspezifischen Themen verstehen und fundiertere Antworten liefern.

In der Praxis lässt sich das unter anderem für die Wartung und Instandhaltung von Fahrzeugen nutzen, wie das Beispiel von Caterpillar zeigt. Reparieren Mitarbeitende eine Caterpillar-Maschine, dokumentieren sie die Beanstandungen, die Fehleranalyse und die Lösung in einem Serviceheft. Mithilfe eines graphbasierten NLP-Tools können sie relevante Informationen aus mehr als 27 Millionen Dokumenten abfragen. Dadurch werden verborgene Zusammenhänge und Tendenzen sichtbar und das System kann passende Maßnahmen empfehlen.

Einem Sprachmodell Grenzen setzen

Ein Beispiel für den Einsatz von Graphtechnologie im Bereich generativer KI stammt aus Singapur: Ein dort ansässiges Öl- und Gasunternehmen testete ein LLM für unternehmensweite Suchen. Die ersten Ergebnisse der KI waren nicht besonders hilfreich. Denn sie verstand nicht, was die Mitarbeitenden suchten – ihr fehlte der Kontext. Mithilfe eines Knowledge Graphen wurden die Antworten schließlich genauer.

In einem anderen Fall haben Medizin-Forschende mit einem Knowledge Graphen ein FAIR-Datenframework aufgebaut. Über den Graphen kann das Team die Informationen bis zu den Quelldaten zurückführen und so die Forschung nachvollziehbar erklären.

Unternehmen, Institutionen und Behörden können mithilfe der Graphtechnologie ihren Sprachmodellen Grenzen setzen und sie so verlässlicher und transparenter machen. Dafür sammeln sie eine riesige Menge an relevanten Textdaten, aus denen anschließend ein Knowledge Graph erstellt wird. Dieser liefert der generativen KI dann den nötigen Kontext.

Ethische Bedenken ausräumen

Unser Leben wird immer mehr von KI-generierten Inhalten geprägt. Doch solange diese Fehler enthalten und reproduzieren, können Unternehmen die Möglichkeiten generativer KI nicht ausschöpfen. Dafür müssen wir KI-Halluzinationen weitgehend verhindern – und das bedeutet, die nächste Generation von GenAI mit hochwertigen, strukturierten Geschäftsdaten zu trainieren.

Graphtechnologie ist eine Möglichkeit dazu. Sie macht LLMs weniger voreingenommen und genauer. Sie zwingt sie, den Kontext miteinzubeziehen, und so die richtigen Antworten zu liefern. Dank der kuratierten Daten im Knowledge Graphen verringert sich das Risiko von Fehlern und fiktiven Informationen deutlich.

Zudem könnte die Verknüpfung von Sprachmodellen und Knowledge Graphen dabei helfen, ethische Bedenken hinsichtlich generativer KI auszuräumen. So könnten Regulierungsbehörden vorschreiben, dass rechtliche und moralische Vorgaben bei der Entwicklung als golden records festgelegt werden müssen – ohne dabei die Innovationsfähigkeit einzuschränken.

Warum halluziniert eine KI?

Eine Künstliche Intelligenz auf der Basis eines Large Language Models (LLMs) verlässt sich auf Wahrscheinlichkeiten. Wenn sie auf eine Anforderung (Prompt) reagiert, errechnet sie, welche Wörter statistisch gesehen am wahrscheinlichsten als Antwort passen. Wie sie das jedoch berechnen, ist von außen nicht nachvollziehbar.

Zahlreiche Beispiele zeigen: Die KI entscheidet sich immer wieder falsch. Sie behauptet unwahre Tatsachen, denkt sich Fakten aus und gibt Vorurteile weiter, die in ihren Trainingsdaten enthalten sind. Dieses Verhalten nennt man „Halluzination“. Es wirkt zuweilen, als ob die KI sich nicht die Blöße geben wollte, etwas nicht zu „wissen“. Derartige Halluzinationen treten auf, wenn der KI der Kontext fehlt. Wenn sie nicht weiß, dass sie Informationen aus bestimmten Quellen heranziehen muss, um eine fundierte Antwort geben zu können. Dann bleibt ihr nur, sich an ihre strikten, statistischen Regeln zu halten – oder zu halluzinieren.

Wie verhindert man KI-Halluzinationen?

Eine generative KI kann nur dann richtige Aussagen treffen, wenn sie eine Vielzahl an Informationen richtig miteinander verknüpft. Sie muss sie in den richtigen Kontext setzen. Eine Möglichkeit, wie GenAI den Kontext einbeziehen kann, ist einen Knowledge Graphen zu verwenden.

Ein Graphmodell besteht aus einzelnen Datenpunkten (Knoten) mit verschieden Eigenschaften sowie aus Beziehungen (Kanten). Um sich das vorzustellen, wird häufig das Beispiel eines U-Bahn-Fahrplans herangezogen: Die Haltestationen sind die Knoten, die Schienen zwischen ihnen sind die Kanten. Ein Algorithmus läuft die Kanten und Knoten ab und kann daraus unter anderem die kürzeste Route zwischen zwei Haltestationen errechnen. Ein Knowledge Graph zeigt, was die Datenpunkte miteinander verbindet.

Graphtechnologie wird heute quer durch alle Branchen eingesetzt. Mithilfe von kontextreichen Knowledge Graphen von Neo4j macht zum Beispiel die NASA ihren Ingenieuren den Wissensstand aus über 50 Jahren Raumfahrtforschung in ihrer Lessons-Learned-Datenbank zugänglich. Ein anderes Beispiel: Knowledge Graphen, die mit externen Datenquellen verbunden sind, unterstützen Unternehmen dabei, ihre Lieferketten zu überwachen oder Compliance-Risiken zu analysieren.

Knowledge Graphen organisieren Daten aus verschiedenen Quellen und stellen alle Einheiten, Eigenschaften und Datenbeziehungen bereit, die bei einer Abfrage relevant sind. Im Fall des autonomen Fahrens heißt das: Der Knowledge Graph erfasst meteorologische Daten, das Datum, den Ort sowie Informationen über die Fahrbahnbeschaffenheit und die Verkehrslage und verbindet diese.