Die Bezeichnungen »Sekundärspeicher/Secondary-Storage«, »Sekundärdaten« und »unstrukturierte Daten« haben fast etwas von einer Beleidigung. Die so bezeichneten Daten scheinen unwichtig, unordentlich und ihnen haftet etwas Störendes an. Aber der Umgang mit ihnen entscheiden darüber, ob Firmen in vollem Umfang von ihren Daten profitieren und was sie das kostet.

Diese Annahme war damals schon falsch. Die Bedeutung der unstrukturierten Daten außerhalb der Datenbanken der großen Software-Suiten hat seitdem aber noch stark zugenommen: Durch Richtlinien zu Aufbewahrung und Archivierung sowie den betriebswirtschaftlichen Wunsch und die technischen Möglichkeiten, einmal – woher auch immer – gesammelte Daten später auszuwerten, um daraus Erkenntnisse zu gewinnen mit denen sich geschäftliche Entscheidungen fällen und begründen lassen.

Immer mehr Sekundärdaten in Unternehmen

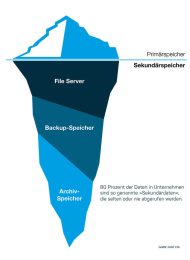

Das Hauptproblem ist, dass die ungeliebten und verachteten Sekundärdaten wesentlich mehr Speicherplatz beanspruchen als die sorgsam gepflegten und gehegten Primärdaten. Ein weiteres Problem ist, dass der Wert der Sekundärdaten oft lange unklar bleibt. Einige von ihnen gewinnen erst nach einem längeren Zeitraum an Wert. Sie ganz zur Seite zu legen ist aber nicht möglich. Schließlich sollen sie für Analytics-Tools, Machine-Learning und vor allem Anwendungen im Bereich Künstliche Intelligenz (KI) verfügbar sein.

Gleichzeitig nimmt die insgesamt zu speichernde Datenmenge weiterhin rasch zu, nicht zuletzt durch neue KI-Applikationen. Bereits 2019 erreicht die globale Datenmenge mit 43 ZByte, dass von IDC für 2020 prognostizierte Niveau. IDC geht von einer jährlichen Zunahme der weltweiten Datenmenge von über einem Viertel aus, so dass die globale Datenmenge 2024 bei über 143 ZByte liegen dürfte.

Treibende Kräfte des Datenwachstums sind IoT und IIoT, Social Media, E-Commerce, Entertainment sowie Machine Learning und Künstliche Intelligenz. Vieles davon wird zunehmend in der Cloud verarbeitet. Aber IDC-Analyst Marco Becker ist sich auch sicher: »Auf lange Sicht wird On-Premises nicht verschwinden«. Der Sicherheitsaspekt sei nur ein Grund dafür – auch wenn es diesbezüglich bei den Cloud-Angeboten schon viele Verbesserungen gegeben habe.

Treibende Kräfte des Datenwachstums sind IoT und IIoT, Social Media, E-Commerce, Entertainment sowie Machine Learning und Künstliche Intelligenz. Vieles davon wird zunehmend in der Cloud verarbeitet. Aber IDC-Analyst Becker ist sich auch sicher: »Auf lange Sicht wird On-Premises nicht verschwinden«. Der Sicherheitsaspekt sei nur ein Grund dafür – auch wenn es diesbezüglich bei den Cloud-Angeboten schon viele Verbesserungen gegeben habe.

Flash kommt – die Festplatte bleibt

Der Anteil von Flash-Speicher hat sich einer anderen IDC-Prognose zufolge von 12 Prozent 2019 auf 24 Prozent im Jahr 2024 verdoppelt. Die Festplatte bleibt – auch preislich – zur Speicherung großer Datenmengen in Unternehmen damit auch in den nächsten Jahren wichtig. Flash-Speicher setzt sich da durch, wo es um Geschwindigkeit und hohe Zugriffszahlen geht. Und nicht zuletzt hält Becker auch Bandspeicher zur Archivierung auch mittelfristig noch für relevant. Der bekannte Mix bleibt also, die Gewichtung verschiebt sich nur. Denn wegen der enormen Menge an Daten müssen die Kosten bei der Datenspeicherung so gering wie möglich gehalten werden. Das sehen auch die großen Anbieter so.

Insgesamt zeigt sich, dass Software in Rechenzentren inzwischen ziemlich gut darin ist, »Hot Data« und »Cold Data« – also regelmäßig und selten oder gar nicht mehr genutzte Daten – zu identifizieren und auf die jeweils geeignete Plattform zu migrieren. Dafür empfehlen unabhängige Experten weiterhin unterschiedliche Speichermedien. Ansonsten büße man entweder Performance ein oder bezahle zu viel.

Viele Daten werden daher auch weiterhin auf kostengünstigen Festplatten landen. Die bleiben auch deshalb noch eine Weile konkurrenzfähig, weil Fortschritte in der HDD-Entwicklung, etwa die Helium-Füllung der Laufwerke und neue Speicherverfahren wie Heat-assisted Magnetic Recording und Microwave-assisted Recording, die Festplattenkapazität weiter erhöhen. Zudem kommen Festplatten im Verbund inzwischen auch auf hohe IOPS-Werte. Es muss also nicht alles, was im Zugriff sein muss, zwangsläufig auch auf Flash-Storage gespeichert sein.

Datenmanagement statt Speichermanagement

Angesichts der wachsenden Bedeutung der Daten für das Tagesgeschäft und der größer werdenden Datenmengen wird die Antwort auf die Frage immer wichtiger, wie sich diese Daten verwalten und speichern lassen. Die Kosten für sekundäre Speicherhardware sind in den vergangenen Jahren stetig gesunken. Diese Entwicklung wird sich voraussichtlich auch in absehbarer Zeit fortsetzen.

Die Kosten für Software zur Datenverwaltung, die benötigt wird, um Daten von der primären, schnellen und ständig zugriffsbereiten Speicherebene in einen kostengünstigeren Speicher zu verschieben, sind dagegen gestiegen.

»Es ist nicht ungewöhnlich, dass Datenverwaltungssoftware pro Kapazität mehr kostet als das Speichermedium, sodass aktuelle Lösungen die Kosten eher multiplizieren, als sie zu senken«, erklärt Betsy Doughty, Vizepräsidentin bei Spectra Logic. Sie geht daher davon aus, dass sich 2021 Unternehmen intensiver mit Storage Lifecycle Management und aktiven Archivierungslösungen beschäftigen, die die Storage-Gesamtkosten senken und dennoch für die erforderliche Verfügbarkeit der Daten sorgen.

Laut Doughty müssen Unternehmen heute ihre Speicherinfrastruktur nicht mehr vollständig neugestalten, um eine Software-Lösung für das Storage-Lifecycle-Management zu implementieren. Und die Managerin geht davon aus, dass die Rolle der Hybrid-Cloud zunimmt, da Unternehmen angesichts der andauernden Pandemie weiterhin und stärker auf Remote-Arbeit setzen und dabei Cloud-Dienste in Anspruch nehmen.

Daten aus der Cloud nicht vergessen

Die Bedeutung der Datensicherung bei der Nutzung von Cloud-Diensten kann jedoch nicht oft genug betont werden. Denn Firmen wie Google, Microsoft oder auch Salesforce überlassen die komplett oder weitgehend der Verantwortung der Anwenderunternehmen. Insbesondere für Microsoft 365 gibt es hier schon eine ganze Reihe von direkt darauf zugeschnittenen Angeboten, etwa von Acronis, Altaro, Arcserve, Barracuda und SEP.

Da eine Vielzahl von Punktlösungen für Unternehmen nicht sinnvoll und nur schwer beherrschbar ist, erweitern diese und andere Hersteller ihre Angebote zudem kontinuierlich, um eine möglichst breite Palette der gängigen Cloud-Dienste abzudecken. Aber bei der Dynamik des Marktes und der Vielzahl der Möglichkeiten wird es immer wieder für das Unternehmen wichtige Dienste geben, die sie nicht erfassen.

Automatisierte Datenverwaltung als Ziel

Um die Datenschätze zu heben, ist es aber unerlässlich, die Inhalte zu kennen. Dabei helfen Metadaten – oder noch besser durch Klassifizierungs-Tools wie Titus angereicherte Metadaten. Als einen Vorteil der Datenverwaltung über Metadaten nennen Experten zum Beispiel die Möglichkeit, Datensätze schon bei der Speicherung mit einem Verfallsdatum zu versehen und so Datenschutzbestimmungen einhalten zu können. Auch der Speicherort sollte sich regelbasiert steuern lassen.

Außerdem sind eine Vielzahl weiterer, regelabhängiger Datenfelder vorstellbar. Die Idee dahinter ist, dass nach einer gewissen Zeit, wenn das Regelwerk rund läuft, sich die Daten automatisiert verwalten. Der Betrieb ist sowohl On-Premises oder in der Cloud möglich. Einstieg ist üblicherweise die Klärung der Frage, welche Daten überhaupt regelmäßig genutzt werden und welche überhaupt nicht mehr angefasst werden. Das alles lohnt sich natürlich bei großen Datenmengen eher.

Das größte Problem heute: Firmen verwalten meist den Speicherplatz, aber nicht die Daten . Im Zuge der Administration werden alle Daten auf einem Datenträger gleichwertig behandelt. Sortierung finde meist nur durch unterschiedlich zugewiesene Laufwerke statt. Dadurch liegen dann zum Beispiel alle Daten einer Abteilung auf einem Laufwerk – von Verträgen bis zu den Fotos der zwanzig letzten Weihnachtsfeiern.

Object-Storage und Sekundärdaten

»File- und Block-Storage-Varianten haben den Nachteil, dass sie zum einen recht statisch, zum anderen recht statisch und ortsbezogen sind«, fasst Betke zusammen. Das heißt, die Anwender oder das System müssen wissen, unter welchem Pfad oder in welchem Block die Daten liegen. »Das verbessert sich bei Objekt-Storage: Er ist nicht hierarchisch und nicht ortsgebunden. Das erlaubt die Nutzung sehr verteilter Storage-Infrastruktur – und genau da geht der Trend hin.«

Ein Nachteil ist, das Object-Storage hohe Anforderungen an die Leistung stellt. Gerade für unstrukturierte Daten bietet sich Object-Storage aber an, weil die immer wieder sehr punktuell nach bestimmten Daten durchsucht werden sollen, um Erkenntnisse zu gewinnen.

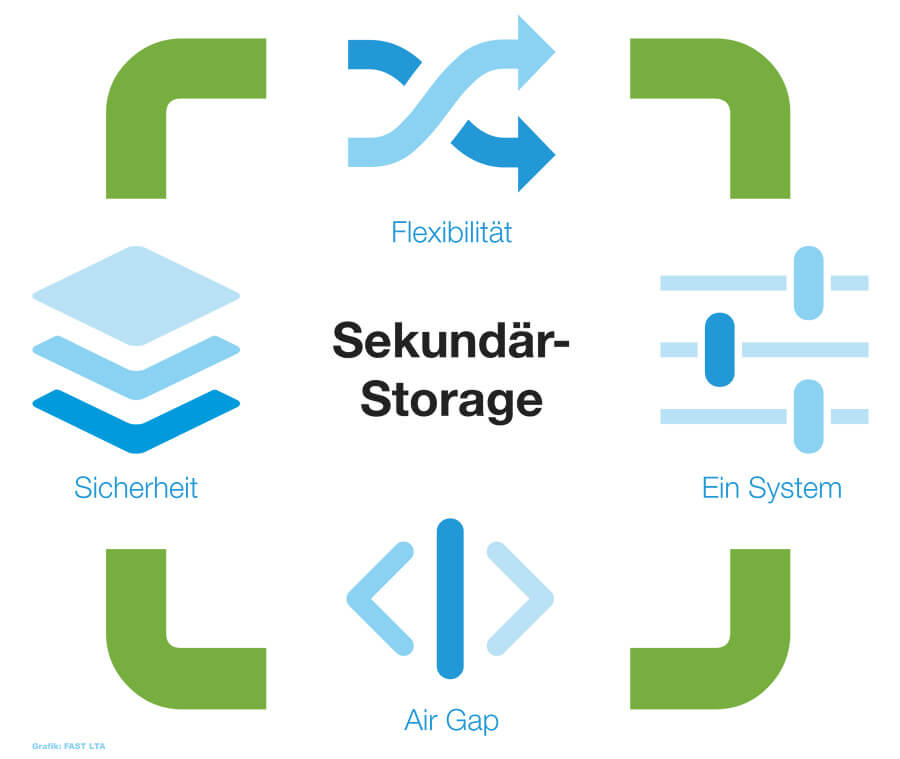

Sicherheitskonzepte für Sekundärdaten

Ein anderes Argument für Tape sind gesetzliche oder versicherungsrechtliche Auflagen, die häufig eine sehr langfristige Aufbewahrung von Daten notwendig machen. Nicht zuletzt spielt Tape laut Gerecke bei KI-Projekten eine wichtige Rolle. Das mag überraschen. Aber erstens sind hier immer große Datenmengen involviert. Zweitens muss auch, wenn ein neuronales Netz für Deep- und Machine-Learning-Projekte trainiert ist, die Rückverfolgbarkeit der verwendeten Daten langfristig sichergestellt werden. Schließlich könnte der Algorithmus Fehler enthalten, die erst sehr viel später bemerkt werden.

Weiterführende Links: