Vast Data stellt einen neuen Datenmanagement-Ansatz vor. Ziel ist es, auch bei sehr großen Datensätzen den Überblick zu behalten. Die zugrundeliegende DASE-Architektur soll auf mehrere EByte und für Milliarden von Dateien und Objekten skalieren. Vast Catalog dient als zusätzliche, fest ins System integrierte Ebene zur Metadatenverwaltung.

Manchmal ist der Weg zum Erfolg, alles genau anders zu machen als bisher. Das fällt denjenigen, die gerade erst anfangen, natürlich leichter als denjenigen, die »es schon immer so gemacht« haben. Das gilt auch in der eigentlich sehr innovationsfreudigen IT und da in der oft durch frühere Entscheidungen im künftigen Handlungsspielrum besonders stark festgelegten Storage-Branche. Gerade Neuankömmlinge, die es komplett anders machen, werden daher oft kritisch beäugt. Umso erstaunlicher sind der Aufstieg des Schlagwortes Disaggregation seit dem Jahr 2020 und das damit verbundenen Interesses für den Anbieter VAST Data, der sich mit seiner Architekturplattform für »Disaggregated Shared Everything« (DASE) genau darauf stützt.

Vereinfacht gesagt ist Disaggregation der nächste logische Schritt nach der Entwicklung von Hyperkonvergenz – die sich ja inzwischen fest etabliert hat. Wie so oft im Storage-Umfeld wird die Innovation vor allem als probates Mittel für große Konzerne angepriesen – weil die in der Regel auch sehr große Datenmengen und zudem das erforderliche Budget haben. Die beschäftigen sich auch durchaus damit.

Shared-Everything & Shared-Nothing Architekturen

Eine schöne, knappe Abwägung der Vor- und Nachteile hat zum Beispiel Niu Zhaojie, Senior Software Engineer bei Bytedance, der Firma hinter TikTok, verfasst. Die Firma muss man nicht mögen – kann aber trotzdem anerkennen, dass sie hervorragend mit großen Datenmengen umzugehen weiß. Als Vorteile nennt Zhaojie vor allem Elastizität, Skalierbarkeit und einfacheres Management. Nachteil sie die höhere Latenz beim Remote-Zugriff.

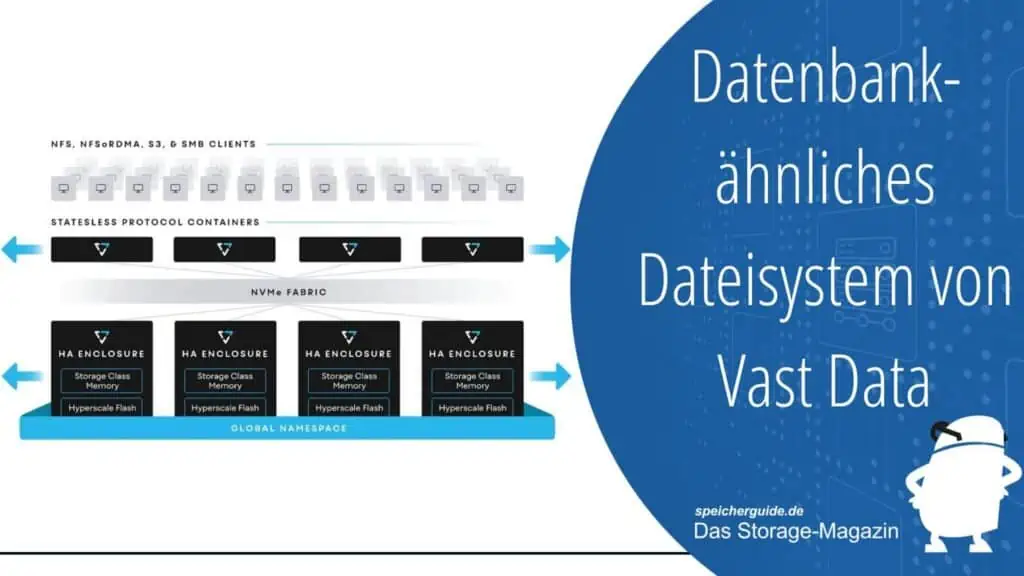

Die DASE-Architektur (Disaggregated Shared Everything) entkoppelt die Speicher- von den Compute-Ressourcen, um Flexibilität und Skalierbarkeit zu bieten. Der Speicher wird separat bereitgestellt und kann von mehreren Servern gemeinsam genutzt werden. Jeder Server kann auf den gemeinsamen Speicher zugreifen und jeder Server kann auch auf die Rechen-Ressourcen anderer Server zugreifen, um seine Arbeit zu beschleunigen.

Was Vast Data anders machen will

Bei seiner DASE-Architektur für Scale-out-Speichersysteme will Vast Data mit QLC-Flash-Laufwerken, zustandslosen, containerisierten Speicherdiensten und deren Verbindung über NVMe-over-Fabric die Vorteile bei niedriger Latenz erreichen. Es greift dazu bei der Hardware auf verfügbare Technologien zurück. Die »Magie« entsteht durch die Software: Algorithmen sollen zusätzlich Speichereffizienz, Belastbarkeit und Skalierbarkeit verbessern.

Glaubt man den Zahlen, funktioniert das ganz gut: Vast Data ist eines der am schnellsten wachsenden Storage-Unternehmen. Gartner ist in Bezug auf das Unternehmen aber noch zurückhaltend und stuft Vast Data in seinem »Magic Quadrant 2022 für Distributed File Systems« zusammen mit Huawei, Hitachi Vantara und Cloudian als »Challenger« ein. Als »Leader« sehen die Analysten Dell, IBM, Pure Storage, Qumulo und Scality.

Vast Data selbst sieht sich natürlich besser positioniert. Gerade gegenüber Mitbewerbern wie Dell, Pure Storage und NetApp habe man mehrere Vorteile: So setze man etwa nicht ausschließlich auf Flash-basierende Speicher, sondern kombiniere NAND-Flash und QLC-Flash-Speicher. Da QLC-Flash zwar langsamer als NAND-Flash ist, jedoch eine höhere Kapazität bietet, erreiche man ein besseres Preis-Leistungs-Verhältnis.

Darauf zahle auch die als »Universal Storage« bezeichnete, eigenentwickelte Datenkompression ein, die eine besonders hohe Speicherkapazität ermögliche. Ein automatisches Tiering-System verschiebt Daten dynamisch, um eine optimale Leistung und Kapazität zu erzielen. Das Latenzproblem soll die »LightSpeed« genannte Netzwerkarchitektur beheben, die auf RDMA (Remote Direct Memory Access) setzt, um den Datentransfer zwischen Compute- und Speichermodulen zu beschleunigen. Auf dieser Grundlage verfolgt der Anbieter eine aggressive Preisstrategie, die von einer großzügigen Garantie und einem Preismodell unterstützt wird, bei dem nur die tatsächlichen genutzte Speicherkapazität abgerechnet wird.

Wie Vast Catalog das Angebot verbessern soll

Vor diesem Hintergrund ist die aktuelle Ankündigung der Software-Komponente VAST Catalog zu sehen. Sie erweitert die DASE-Architektur durch eine Metadaten-Verwaltungsebene. Benutzer können damit ihre Dateien und Datenobjekte unabhängig von der zugrunde liegenden Speicherinfrastruktur (vorausgesetzt sie ist von Vast Data) in einem globalen Namespace organisieren und verwalten.

»Durch die Bereitstellung einer globalen Metadatenverwaltungsebene ermöglicht Vast Catalog eine nahtlose Skalierung und eine effiziente Verwaltung von Daten auf der Vast-Data-Speicherarchitektur«, teilt das Unternehmen mit. »Benutzer können ihre Daten einfach organisieren und verwalten, indem sie Metadatenattributen wie Benutzername, Projektnamen oder Datum hinzufügen.«

Vast Catalog biete zudem auch Funktionen wie die Suche, Filterung und Sortierung von Daten, um Benutzern schnellen und einfachen Datenzugriff zu ermöglichen. Dazu werden standardmäßige Dateiprotokolle wie NFS, SMB und S3 unterstützt, »um eine nahtlose Integration mit bestehenden Anwendungen und Workflows zu gewährleisten.« Ein Kapazitäts-Reporting ist ebenfalls möglich.

Für Vast Catalog hat der Hersteller eine eigene Datenbank entwickelt. Sie setzt auf der Vast-Plattform auf und kann nach einem Upgrade auf die neueste Vast-Software-Version (4.6) genutzt werden. Vast erstellt auch Snapshots des Katalogs selbst. Die Ansprache des Vast Catalog ist über eine Web-Oberfläche, CLI sowie gängige Open-Source-Query-Engines möglich. Zu Beginn gehören dazu ApacheSpark und Trino.

Anwendungsfälle für Vast Catalog

Die Technologie ermögliche es Benutzern und Anwendungen letztlich, das Dateisystem wie eine Datenbank zu behandeln. KI- und ML-Anwendungen der nächsten Generation könnten das Dateisystem als selbstreferenziellen Feature-Store nutzen. Vast Catalog sei zudem die Grundlage für eine semantische Schicht, die auf Dateien und Objekten aufbaut, und mache separate Systeme zur Datensuche und zum Datenzugriff überflüssig.

Als mögliche Anwendungsfälle nennt Vast Data etwa das Training von KI- und ML-Modellen. Hier könnten bei der Verarbeitung und Analyse der Daten generierte Merkmale und Attribute zu jedem Datenelement direkt gespeichert werden. Objekt- und Dateisystem-Metadaten lassen sich direkt nutzen, um Merkmale und Attribute mittels S3-Tags und S3-Objekt-Metadaten in den Objektspeicher einzubetten.

Eine weiteres Szenario sei die Konsolidierung großer Mengen (einige PByte) geschäftskritischer unstrukturierter Daten. Die Zusammenführung bietet erhebliche Effizienzvorteile, sowohl in Bezug auf die Kosten als auch auf die Reduzierung des Anwendungs- und Verwaltungsaufwands, erschwere aber die Suche erheblich. Spezielle Produkt Dritter oder Open-Source-Anwendungen benötigten zum Indizieren viel Zeit. Dadurch seien der Katalog und der aktuelle Zustand des Dateisystems nicht immer synchron. Zudem kann der Scan das Dateisystem belasten, was wiederum die Performance von Produktionsanwendungen beeinträchtigt. Und schließlich müssten diese zusätzlichen Produkte auch gewartet werden. Auch dieser Aufwand falle weg.

Weiterführende Links: