Datenverluste entstehen unvorbereitet und verursachen großen Schaden. Deshalb ist eine leistungsfähige Backup-Infrastruktur unverzichtbar, um sensible Daten zu schützen und die Daten-Hoheit und -Kontrolle zu behalten. Doch mit der Datenmenge steigt auch die Komplexität. Positiv: Nie hatten IT-Manager so viele unterschiedliche Technologien und Ansätze zu Auswahl für ihre Datensicherungsstrategie.

Eine aktuelle Studie, der Veeam Data Protection Trends Report 2022, bringt einige interessante Befunde zum Stand der Datensicherung in Deutschland: 82 Prozent der IT-Entscheidungsträger sind der Auffassung, dass es in ihrem Unternehmen eine Daten-»Verfügbarkeitslücke« nach einem Ausfall geben werde. 81 Prozent empfinden eine »Datensicherungslücke« zwischen der Häufigkeit der Datensicherung und dem akzeptablen Datenverlust. 5,6 Prozent der Befragten äußern deshalb, die Ausgaben für die Datensicherung 2022 zu erhöhen. Über 70 Prozent waren bereits von Ransomware-Angriffe betroffen.

Bedrohung Ransomware – aber nicht nur

Zu den Herausforderungen gehören nicht nur Bedrohungen wie Ransomware, der zunehmende Einsatz der Cloud (bei bereits 51 Prozent der Befragten) und die Orchestrierung der Datensicherung bereiten Probleme. 20 Prozent der Unternehmen erachten eine Verbesserung der Recovery-Point-Objectives (RPOs) sowie niedrigere Recovery-Time-Objectives (RTOs) für notwendig. Ebenso viele erwägen eine Änderung ihrer Backup-Strategie, um Kosten zu senken.

Jedoch, Cyberattacken bleiben (leider) nicht die einzige Bedrohung für einen Datenverlust. Hardware-Fehler, falsche Scripts und Bedienfehler, die kein neues Phänomen sind, bleiben aber eine Gefahr. Der Wert der Daten wächst. Um so höher das Schutzbedürfnis.

3-2-1-Regel reicht nicht mehr aus

Ein schwieriger Spagat, denn Ransomware-Angriffe können ein Unternehmen teuer zu stehen kommen. Nicht nur Lösegeldforderungen fallen an, sondern auch Folgekosten durch Attacken, die Systeme über Wochen und Monate außer Kraft setzen. Effektive Strategien müssen her.

Im Gespräch mit speicherguide.de erklärt Dennis Rotsch, Presales Consultant bei Arcserve: »Backup ist die letzte Verteidigungslinie gegen Ransomware. Die Frage ist dabei nicht ob, sondern wann man angegriffen wird«. Für ihn und sein Unternehmen führt der Weg über eine multi-modale Strategie aus Sicherungs- und Security-Technik, Prozessen und Vorkehrungen für eine orchestrierte Wiederherstellung. Dazu gehören Recovery-Tests, Best-Practices ebenso wie Mitarbeiter-Schulungen.

3-2-1-1 ist die neue Strategie der Stunde. Drei Kopien an zwei Orten, mit einem ausgelagerten Medium und einer unveränderlichen Daten-Kopie. Arcserve arbeitet hierfür mit dem Security-Anbieter Sophos zusammen, um seine Appliance- und Software-Lösungen zu ergänzen. Die Lösungen umfassen Disk und Tape, ebenso wie die Cloud über UDP Cloud Hybrid.

Software-defined Datensicherung und Warnung vor Paranoia

Sogar 3-2-1-1-0 propagiert der DataCore. Die Null muss stehen, meint damit Alexander Best, Regional Technologist beim Software-defined-Storage-Spezialisten. Diese Null steht für den Ausschluß von Fehlern beim Backup, unbefugten Datenzugriff verbunden mit kontinuierlicher Prüfung der Wiederherstellung. Laut seiner Angaben kostet ein Datenverlust durch Ransonware-Attacken deutsche Unternehmen im Schnitt 2,41 Millionen Euro.

Realisiert wird dies bei Datacore mit einer On-Premises-Kopie, zusammen mit Air-Gap durch Offline-Kopien, die auch über Object -Lock und Immutability realisiert werden kann. Datacore realisiert dies über seine scale-out Object-Storage-Software Swarm als Alternative oder Ergänzung zu Cloud und Tape. Der Fokus liegt hier auf der Hochverfügbarkeit der Datensicherung und der Unabhängigkeit von Hardware.

»Objektspeicher ist ein ideales Backup-Ziel und erlaubt gleichzeitig PBytes an Daten kostengünstig zu schützen«, sagt Best. »Zu Bedenken auf Management-Ebene ist aber auch, wie weit die Paranoia geht oder gehen sollte. Sicherung ja, aber ich darf mich nicht selbst vom Zugriff auf meine Daten abschneiden«

Ein weiterer Schwerpunkt liegt bei diesem Einsatzszenario auf der Integration der Datenhaltung in die Primärspeicher-Architektur auf Basis austauschbarer Standard-Hardware, wie es der Software-defined-Ansatz mitbringt.

Klassifizierung und unstrukturierten Daten

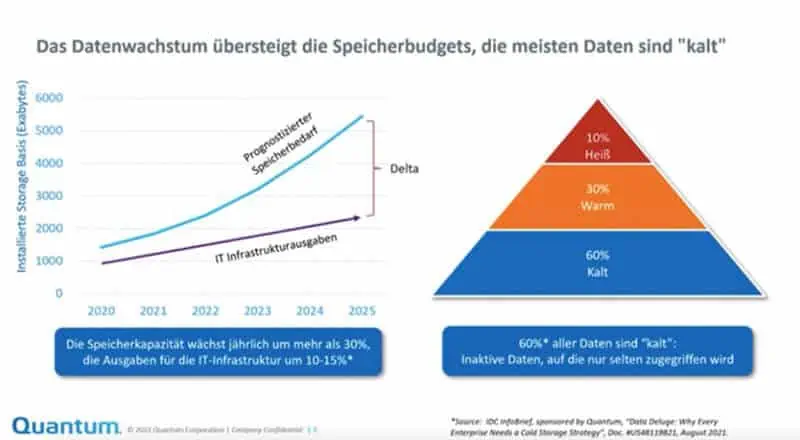

Cyber-Attacken sind ein Problem, aber ebenso die wachsenden Mengen von unstrukturierten Daten, die möglichst (kosten-)effektiv zu sichern sind. Genau dieses Problem geht Quantum mit seiner ActiveScale Object-Softwarean. »Die meisten Daten sind kalt«, weiß Ines Wolf, Manager Presales CEbeiQuantum. »Allerdings geht es bei Objektspeicher eher um Datenredundanz als um Hardware-Redundanz. In Kombination ist Objektspeicher zusammen mit Magnetband eine Lösung zwischen Objekt- und Langzeit-Speicherung.«

Unternehmen sollten ihre Daten klar klassifizieren. »Selten angefasste unstrukturierte Daten können eventuell aus dem herkömmlichen Backup-Prozess herausgenommen werden«, ergänzt Ines Wolf, »um die Sicherung strukturierter Daten zu entlasten.«

Sie empfiehlt die Kombination von Disk-basiertem S3-Objektspeicher mit Tape. Die Lösung ermöglicht die reversible Auslagerung über ein Tiering auf Tape, mit entsprechenden Kostenvorteilen für Byte-intensive Daten, auf die ohne größte RPO-Ziele zugegriffen werden kann. Die Lösung ermöglich auch Geo-Redundanz zwischen zwei oder drei Sicherungszielen, um die Sicherheit und Wiederherstellungs-Optionen zu optimieren.

Zusätzliche Sicherheit lässt sich durch ein sogenanntes 2D-Erasure-Coding erzielen. Dabei werden Objekte nicht nur horizontal über mehrere Tapes wiederherstellbar. »Das 2D-Earsure-Coding erfolgt zusätzlich innerhalb eines Bandlaufwerks und erlaubt ein Recovery von einem Medium«, erklärt Quantum Managerin Wolf.

Warum ist Backup so kompliziert?

Die Komplexität des Backup steigt, meint Hannes Heckel, Director Marketing bei Fast LTA: »Weil Ransomware kostet. Aber auch, weil die Komplexität mit den Datenmengen steigt. Wachstum und neue Technologien bedeuten neue Gefährdungen, auch wegen Hardware-Ausfällen menschlichen Bedienfehlern, falscher Konfiguration oder nicht ausreichend skalierender Systeme.« Dafür bietet sein Unternehmen modulare Silent Brick-Lösungen.

Auch Backups müssten geschützt werden. Heckel postuliert einen Paradigmenwechsel. Ein einfaches Backup-to-Disk-to-Tape funkioniere nicht mehr. Ziel sei die Wiederherstellung des laufenden Betriebs sowie der Optimierung von RPO und RTO. Deshalb appelliert er für den Einsatz von Flash-Speicher zusammen mit Disk für die Datensicherung.

»7-Tage-Backup funktioniert in dem herkömmlichen Sinn nicht mehr«, sagt Heckel. »Air-Gap ist heute auch über schnellere Medien realisierbar, und benötigt nicht unbedingt Tape«. Genauso sei es beim Einsatz des Software-basierten Objektspeichers etwa mit Object-Lock. Dieser bringt das Backup zusammen mit der Archivierung. Diese verlangt aber nicht nur Sicherung über Unbeschreibbarkeit, sondern eben auch eine beabsichtigte Löschung.

Tape, Disk, Flash – Block, File, Object

Wir vernehmen unterschiedliche technische Ansätze, auch bezüglich der Medien. Unisono herrscht die Meinung, dass Backup-Ansätze sowohl übergreifend sein sollen, aber auch die Komplexität reduziert werden soll. Angesichts der unterschiedlichen Unternehmensanforderungen, Branchen oder gesetzlichen Vorschriften ebenso wie bestehende Verträge und Verpflichten eine Quadratur des Kreises für die meisten Unternehmen.

Während des Digitalevents von it-daily.net und speicherguide.de gaben sechs Prozent der Besucher an, sehr unzufrieden mit ihrem Backup zu sein. 39 Prozent sehen Verbesserungspotenzial, 33 Prozent denken über eine Optimierung nach. Rund acht von zehn bereitet das Thema gewisse Schmerzen. Handlung erscheint notwendig.

Kalt heisst nicht unwichtig

Ignorieren lässt sich das Thema also nicht, auch darin sind sich die Experten einig. »Je früher Backups geschützt werden, desto weniger Aufwand, desto schneller die Wiederherstellung«, fasst Fast-LTA-Manager Heckel zusammen. Wir hören von den Experten, dass viele Wege in das Rom der Data-Protection führen kann. Cloud-only scheint nicht dazu zu gehören.

Zurück zur Studie: In Deutschland akzeptieren 59 Prozent bei Daten von hoher Priorität einen Ausfall von maximal einer Stunde. Für kältere Daten liegt der Wert bei 47 Prozent als nicht wesentlich niedriger. Im Umkehrschluss bedeutet das, kalte Daten werden in ihrer Wichtigkeit nicht unterschätzt.

Weiterführende Links