Dass die Datenpflege im Businessalltag allerdings oft zu kurz kommt, ist kein Geheimnis. Im vergangenen Jahr gaben bei einer IHK-Umfrage 41 Prozent der Unternehmen an, dass ihre tägliche Arbeit unter mangelnder Datenqualität leidet.

Wie weitreichend die Folgen einer mangelhaften Datenhygiene sind, bestätigen die Ergebnisse der Studie von Natuvion und NTT Data Business Solutions.

Schwerpunkt der Untersuchung war die digitale Transformation großer Systeme und die damit verbundenen Herausforderungen, Chancen und Mehrwerte. Ein wichtiger Aspekt der Befragung war die Bereitschaft zu Housekeeping-Projekten, also die gezielte Datenpflege vor oder während einer Transformation. Um es gleich vorwegzunehmen: Die Komplexität einer digitalen Transformation macht die Mobilisierung vieler Ressourcen und Kompetenzen sowie die Durchführung teils unangenehmer Aufgaben erforderlich. Die Qualität der zu migrierenden Daten ist dabei ein elementarer Schlüsselfaktor.

Von der Tabularasa-Fraktion bis zum Daten-Messi

Dem Housekeeping wird laut Studienergebnissen nicht die Aufmerksamkeit geschenkt, die es gebraucht hätte. Zwar nannten die Unternehmen auf die Frage nach den Erfolgsfaktoren der Transformation die „Prüfung der Datenqualität“ und die „Bestandserfassung“. Doch diese Antworten kommen einem Lippenbekenntnis gleich. Warum? Weil 35 Prozent der deutschen Unternehmen angaben, während des Transformationsprozesses von der schlechten Qualität ihrer Daten überrascht worden zu sein.

Fakt ist, dass der Löwenanteil der Systeme, die im Rahmen einer digitalen Transformation durch moderne Cloudlösungen ersetzt werden, aus internationaler Sicht zwischen 6 und 10 Jahren alt sind. In der DACH-Region sind zwar 16 Prozent der Systeme nicht älter als 5 Jahre, jedoch 26 Prozent der abgelösten IT-Systeme älter als 10 Jahre. Damit ist klar, dass die ERPSysteme in DACH meist älter sind als in den anderen Regionen, bevor sie aktualisiert werden.

Das alles hat Einfluss auf die Datenqualität, denn deren Relevanz für die Zukunftsfähigkeit eines Unternehmens hat sich erst in den letzten Jahren als kritisch entpuppt. Deshalb sind weder Transformationsprojekte, bei denen Daten rigide gelöscht werden noch solche bei denen auch noch die ältesten Daten mitumgezogen werden, erfolgreich.

Das Zauberwort: „Selective Data Transition“

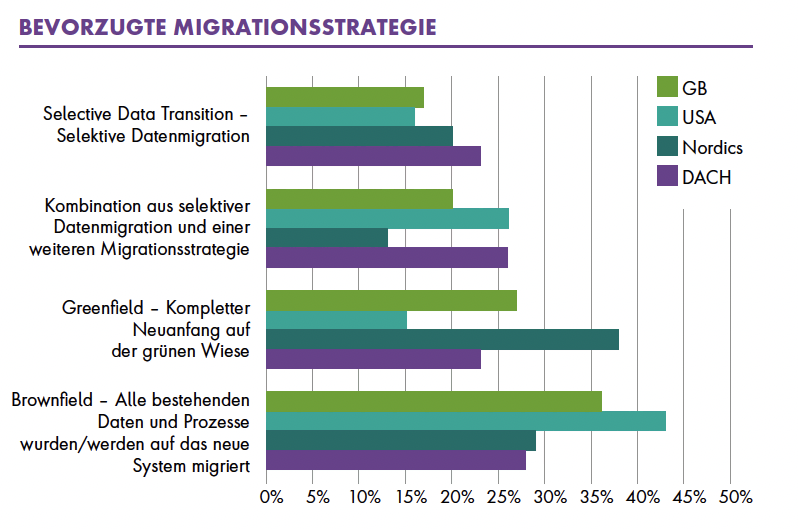

Umso wichtiger ist es, vor der Migration ein solides Housekeeping durchzuführen. Es sollte hinterfragt werden, welche Daten archiviert, umgezogen oder gelöscht werden können. Dabei gilt die Devise, nur das Nötigste zu migrieren. Das hat in der Regel zur Folge, dass Unternehmen weder auf der grünen Wiese einen kompletten Neuanfang starten (Greenfield) noch alle bestehenden Daten und Prozesse einfach auf das neue System migrieren.

Am zielführendsten ist deswegen meist der Selective-Data-Transition-Ansatz (SDT). Und es gibt noch mehr, was für diesen Approach spricht: das kleine Umstellungsfenster (Near Zero Downtime). In der Studie gaben 57 Prozent der deutschen Unternehmen an, für eine Datenmigration nur wenige Stunden zu haben – 74 Prozent haben maximal einen Tag. Für diese Organisationen ist SDT der interessanteste Transformationsweg.

Denn die selektive Datenmigration ist der einzige Weg, das Umstellungsfenster und damit die „Downtime“ so klein wie möglich zu halten, weil diese Methode den Parallelbetrieb der alten und neuen Systeme mit nahezu allen Daten ermöglicht. Zum Umstellungszeitpunkt wird nur das Delta der veränderten Daten übertragen und das alte System deaktiviert. Das verringert die Downtime drastisch!

Für welche Vorgehensweise auch immer sich ein Unternehmen entscheidet – wenn es vorher nicht seine Daten ausmistet und für die Zukunft eine konsequente Datenpflege etabliert, wird die nächste Herausforderung nicht lange auf sich warten lassen.