IT-Systeme müssen immer und überall verfügbar sein. Dies erfordert aber auch, dass Backups jederzeit für eine mögliche Wiederherstellung bereit sein müssen. Eine kontinuierliche Datensicherung macht dies möglich und löst periodische Backups ab.

Längere Ausfälle von IT-Systemen sind heute nicht mehr akzeptabel. Trotzdem gibt es tatsächlich so gut wie keine Organisation, deren Systeme nicht schon einmal geplant oder ungeplant über längere Zeit ausgefallen sind. Gemäß Schätzungen von IDC, erleidet ein durchschnittliches Unternehmen (über alle Branchen und Unternehmensgrößen hinweg) rund 29,3 Stunden an ungeplanten Ausfallzeiten pro Jahr. Etwa durch Hardwarefehler, menschliches Versagen oder Ransomware-Attacken. Dazu kommen noch geplante Auszeiten für Wartung, Upgrades oder Migrationen. Sind Systeme aufgrund ungeplanter Probleme nicht verfügbar, ist dies nicht nur nervenaufreibend diese wieder lauffähig zu bekommen, sondern verursacht auch einen immensen finanziellen Schaden.

Risikofaktor #1 für lange Ausfallzeiten: Veraltete Backup-Strategien (aka Snapshots)

Da sich nicht alle Ausfälle vermeiden lassen, geht es im Kern darum, die Auswirkung dieser so gering wie möglich zu halten. Um dies zu erreichen, investieren Unternehmen in eine widerstandsfähigere IT und nutzen in der Praxis meist eine Kombination verschiedener Ansätze und Lösungen. Hochverfügbarkeitslösungen bieten beispielsweise rudimentären Schutz für Hardwarefehler. Der größte Risikofaktor für längere Ausfallzeiten sind jedoch Backups. Denn wenn Daten von Backups wiederhergestellt werden müssen, kann der Prozess mitunter Tage oder sogar Wochen andauern. Der Grund dafür: Eine aus Snapshots basierte Backup-Technologie.

Verfügbarkeit von Anwendungen und Daten koppeln

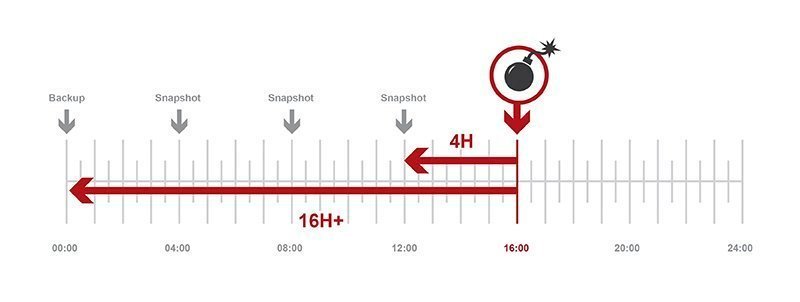

Betrachtet man die Sachlage technologisch nüchtern, so wird schnell klar, dass die Verfügbarkeit von Anwendungen und Daten nicht voneinander zu trennen ist. Während Anwendungen relativ schnell einen Neustart erlauben, dauert es mitunter erheblich länger, ein Backup der dazugehörigen Daten zurückzuspielen. Ransomware ist ein gutes Beispiel für mögliche Probleme bei einer schnellen Wiederherstellung mit der veralteten Snapshots-Technologie: Sobald ein Unternehmen Opfer eines Angriffs wird, sind die Daten verschlüsselt, und wenn das letzte Backup von letzter Nacht, letzter Woche oder sogar vom letzten Monat stammt, resultiert dies schnell in einem massiven Zeit- und damit Kostenaufwand in der Wiederstellung – von dem Schaden durch den mindestens mehrstündigen Datenverlust mal ganz zu schweigen.

Das Problem: Der periodische Backup-Ansatz

Das größte Problem Verfügbarkeit zu garantieren, liegt also im traditionellen Backup-Ansatz, der seit Jahrzehnten größtenteils unverändert ist und auf periodischen Snapshots aufbaut. Will man unterbrechungsfreien Service bieten, inklusive für die durch Backup abgesicherten Daten, so benötigt man logischerweise einen kontinuierlichen Prozess, anstatt der periodischen Vorgehensweise. Die kontinuierliche Datensicherung speichert jede Änderung und Aktualisierung in Echtzeit. Nur so ist der Datenbestand nach der Sicherung auch in Echtzeit verfügbar und bietet eine höhere Verfügbarkeit von Anwendungen bei weniger Datenverlust. Diese Technologie für Datensicherung in Echtzeit, wird meist als Continuous Data Protection (CDP) bezeichnet.

Bild: Periodische Backups mit Snapshots benötigen eine lange Zeit für die Wiederherstellung. Darüber hinaus kann die Technologie zu mehrstündigem Datenverlust führen.