Die Flut an strukturierten und unstrukturierten Daten nimmt immer weiter zu, und so die Notwendigkeit bei fast gleichbleibenden Budgets immer mehr Speicher bereit zu stellen. Vor allem unstrukturierte Daten wachsen überproportional und wecken Begehrlichkeiten: primär nach günstigem Speicher, am besten in rauen Mengen.

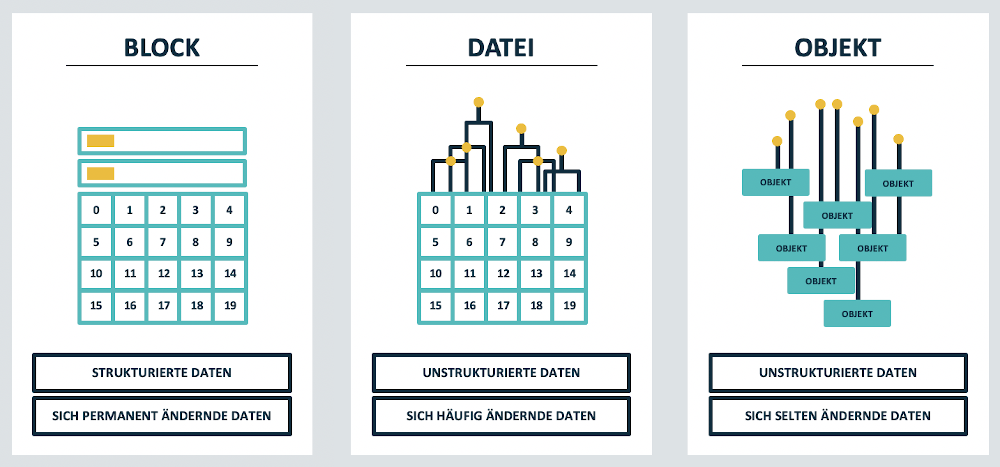

So hat sich Objektspeicher schnell neben Block- und File-basiertem Storage etabliert. Doch nicht jede Speicherform eignet sich für jede Anforderung und isolierte Lösungen enden schnell in Sackgassen.

Um Daten adäquat zu speichern, stehen für alle drei Ansätze HDD und SSD in unterschiedlichsten Ausprägungen zur Verfügung. Unabhängig davon, ob sie lokal, verteilt oder in der Cloud genutzt werden, haben Block-, Datei- und Objektspeicher Vor- und Nachteile. Wo also liegen die Unterschiede?

Blockspeicher: Suche nach Verfügbarkeit und Performance

Blockspeicher kann als Basiselement aller drei Speicherformen gesehen werden. In Reinform wird er primär für strukturierte Daten verwendet, da für sie der Fokus auf vielen kleinen Datenänderungen mit höchstmöglicher Performance bei niedriger Latenz und permanenter Verfügbarkeit liegt. Auf Blockspeicher greift man im Regelfall über SAS, SATA, FC, iSCSI oder NVMe zu.

Typische Anwendungsgebiete liegen bei sich permanent ändernden Daten und Anwendungen mit zufälligen Lese-Schreib-Vorgängen, also etwa Datenbanken oder geschäftskritischen Applikationen wie ERP-Systeme. Typische Installationsgrößen liegen heute zwischen 10 und 200 Terabyte. Ausnahmen, vor allem nach oben, bestätigen die Regel.

File-basierter Speicher: Verwaltbarkeit im Fokus

Beim Dateispeicher dagegen liegt der Schwerpunk auf Kollaboration, für den geteilten Zugriff auf häufig von Nutzern veränderte Daten. Der Zugriff erfolgt üblicherweise mittels eines hierarchischen Dateisystems über NFS- und SMB-Protokolle, wie sie von Network Attached Storage (NAS) lokal oder auch in der Cloud genutzt werden. Der Schwerpunkt liegt hier auf der einfacheren Verwaltbarkeit der Daten in Dateiform, neben Performance und Verfügbarkeit. Erreicht wird das über die Dateisysteme, mit denen der nicht direkt ansprechbare darunterliegende Blockspeicher verwaltet wird. Installationen reichen typischerweise von etwa 20 Terabyte bis in den unteren Petabyte-Bereich. Auch hier gibt es regelmäßig Ausnahmen in beide Richtungen.

Objektspeicher: Für verteilten Zugriff

Etwas anders verhält es sich bei großen, unstrukturierten Datenmengen wie etwa Streaming-Videodaten, Bilddatenbanken und Datensätzen für die Analyse für Maschinenlernen (ML) und künstliche Intelligenz (KI). Bei Objektspeichern erfolgt der Datenzugriff ohne Dateisystem direkt auf einzelne Dateien mittels S3- oder http-Protokollen.

Objektspeicher kümmert sich um die Bereitstellung und Archivierung von Daten, die sich selten oder nicht ändern und ermöglicht deren verteilte Nutzung. Bei der Veränderung von Inhalten, sollten es auch nur ein Byte sein, wird in der Regel das bestehende Objekt komplett ersetzt. Das wirkt sich nicht gerade positiv auf die relative Schreibperformance aus, ermöglicht aber das einfache Verwalten und auch Bereitstellen großer Datenmengen für eine verteilte Nutzung.

Installationen finden sich in Bereichen ab 100 Tera- bis zu hunderten Petabyte. Aus Kostensicht ist Objektspeicher die preisgünstigste (Preis pro TB) der drei Speicherformen. Zudem lässt er sich relativ einfach als aktives Archiv an Dateispeicher anschließen.

Die üblichen Formen Daten zu speichern. Bild: DataCore Software

On-premises, Cloud oder die Qual der Wahl?

Nun bietet der Markt diverse Lösungen, um unterschiedliche Anforderungen abzubilden. Nicht zuletzt muss der Speicher in Bezug auf Verfügbarkeit, Performance und Kapazität skaliert werden können, und zwar zu akzeptablen Kosten. Anhänger der Cloud loben die gute Skalierbarkeit, und die derzeit beliebte Umschichtung von Investitions- auf Betriebskosten. Offen bleiben jedoch die dauerhaften Kosten sowie die Umsetzbarkeit sehr individueller Datensicherheits- und Compliance-Anforderungen.

Klassische Alternativen sind dedizierte (On-premises-) Speichersysteme, die häufig als „Enterprise Speichersysteme“ vermarktet werden. Sie bieten lokale Datensicherheit und -hoheit. Bei der Implementierung muss aber ein erheblicher Aufwand betrieben werden, etwa bei der Datenmigration zwischen verschiedenen Herstellern. Sie resultieren schnell in Silo- Architekturen mit diversen Plattformabhängigkeiten und einer Nutzungsdauer mit drei bis fünf Jahren. Und dann?

Alternative SDS

Als Alternative zu den erwähnten Ansätzen bieten sich Software-Defined Storage (SDS)-Lösungen. Die entscheidende Frage: Wieviel muss man denn von welchem Speicher wo genau haben? Mit den passenden Software-Defined Storage-Lösungen können Unternehmen ihre Ressourcen frei wählen, auch vorhandene Ressourcen nutzen und dies jederzeit ändern. Egal ob Block-, File- oder Objektspeicher – lokal, verteilt oder in der Cloud, kann die Zuordnung der Daten zur Speicherphysik individuell an die jeweiligen geschäftlichen Anforderungen angepasst werden. Einen entsprechenden Ansatz verfolgt DataCore mit SDS-Plattformen für jede der drei Speicherdisziplinen. Das sind SANsymphony für Blockspeicher, vFilO für Dateispeicher und neuerdings Swarm für Objektspeicheranforderungen. Die drei Spezialisten gewährleisten bereits heute für jede Anforderung die optimale Lösung.

Swarm: Mehr als „Nur“ Objektspeicher

DataCore Swarm ist eine On-Premises- Objektspeicherlösung, die die Verwaltung, die Speicherung und den Schutz der Daten vereinfacht und dabei S3-/ http-Zugriff für jede Anwendung, jedes Gerät und jeden Endnutzer bietet. Swarm verwandelt Datenarchive in eine flexible, sofort abrufbare Content-Bibliothek, die dezentrale Arbeitsabläufe, bedarfsabhängigen Zugriff und massive Skalierbarkeit ermöglicht. Zudem kann Swarm direkt mittels NFS und SMB als aktives Archiv genutzt werden. Dies wird durch SwarmFS (NFS) und DataCore FileFly (SMB) erreicht.

Einige Eigenschaften von DataCore Swarm:

- Einfaches Management, automatisierte Aufgaben

- Ein Admin kann in Teilzeit mehr als 50 PB und tausende Mandanten verwalten

- 90 Sekunden um zusätzliche Kapazität oder Performance hinzuzufügen

- Kein darunterliegendes Betriebssystem oder Datenbank zu verwalten

- 95 Prozent der Speicherkapazität ist ausschließlich für Daten

- Die Hardware (CPU, RAM, HDD, SSD…) kann beliebig gemischt werden

- Erasure Coding und Replikas auf derselben HW – patentierte Technologie

- Self-Service für Endbenutzer über das Inhaltsportal

- Speichern, suchen und teilen von Dateien mit jedem Gerät

- Teilbereiche von Dateien (Video Clipping) direkt aus Swarm herauslesen

- Metadaten hinzufügen, bearbeiten, indizieren und zur Suche verwenden

Neues Objekt der Begierde

Swarm eignet sich für diverse Einsatzgebiete wie Medien und Unterhaltung, High-Performance Computing, Archive im Gesundheitswesen, öffentliche Einrichtungen, sekundäre Speicherplattform in Unternehmen, Hybrid Cloud und so weiter. Die SDS-Plattform beseitigt Komplexitäten und vereinfacht das Infrastruktur- und Mandantenmanagement mit Object-Storage, dem neuen Objekt der Begierde am Speicherhimmel.