Vor einem Jahr wurde der Server Leistungs Wert (SLW) als einfache Metrik für Zwecke des IT-Finanzmanagement vorgeschlagen. Seither hat sich einiges ergeben, worüber zu berichten ist. Seit wir Marktpreise und Aspekte des IT-Finanzmanagement unter Mitwirkung von Unternehmen, Behörden und Institutionen analysieren – das sind gut 20 Jahre – verändert sich die technische Seite der IT fortlaufend und massiv.

Die betriebswirtschaftliche Seite dagegen – stark vereinfacht – bleibt sich treu: was kostet das:

-

Rechnen,

-

Speichern,

-

Transportieren und

-

Darstellen

von Informationen und wie bekommt man diese Kosten vom Benutzer wieder herein? Doch während man fürs Speichern, Transportieren und Darstellen relativ einfach Metriken findet, sieht es fürs Computing kom-plexer aus.

Die Server sind in den Markt des Groß-Computing gewachsen. Vielfach lösen sie Mainframes ab oder ergänzen sie. Neue Rechenkapazitäten werden fast nur noch durch Server-Rechenzentren aufgebaut. Auch in der Cloud oder bei Großdienstleistern übernehmen Server das Computing. Doch wachsen auch die Mainframes weiter an Zahl und Computing Power. Niemand weiß genau, ob die weltweite Computing Power überwiegend durch Server oder durch Großrechner geleistet wird. Hinzu kommt, dass auch der einzig verbliebene Mainframe Hersteller (IBM) seine Mainframes manchmal als Server bezeichnet. Die darin arbeitenden Prozessoren ähneln prinzipiell eher den Server-CPUs als typischen Mainframe CECs (central electronic complex).

-

Ist Computing Power von Servern das Gleiche wie die von Mainframes ?

-

Wenn nicht, wo liegen denn die Unterschiede ?

-

Wie werden Rechenkapazitäten durch die IT-Verantwortlichen beschafft

-

Kauft man Rechner, Server wie Mainframes, nach Leistung?

-

Oder eher nach Features oder Marketing-Angaben ?

-

Sind Leistungs-Angaben kaufentscheidend? oder doch wenigstens mit im Spiel ?

-

Handelt es sich dabei um einen objektiven Leistungs-Maßstab?

-

Oder eher um eine Marketing-Bewertung, die jeder Anbieter nach seiner eigenen Skala macht ?

-

Wie vergleicht man dann die Angebote verschiedener Anbieter?

Und in Richtung der Kunden stellen sich folgende Fragen:

-

Wie verrechnen IT-Leiter oder CIOs ihre Computing-Leistung an die Kunden weiter?

-

Wenn dies nach Leistung geschieht, wie wird die Leistung oder Kapazität gemessen?

-

Ist es gleichgültig, ob man dem Kunden einen leistungsstärkeren oder –schwächeren Server bietet?

-

Kann man überhaupt unterscheiden, ob ein Server mehr oder weniger Computing Power hat?

-

Woran kann man das sehen?

-

Sind es die Gigahertz oder die Anzahl Prozessoren, Kerne, n-way oder Threads ?

-

Oder sind dafür die bekannten Benchmark-Suiten SpecInt, MIPS, TPC oder SAPs besser geeignet

-

Wozu gibt es dann noch über 30 weitere ähnliche Benchmarks (rperf, OLTP, MSU usw.) ?

-

Wie vergleicht man dann den Server von XX mit dem Mainframe vom einzigen Hersteller?

-

Müsste nicht der Maßstab für die Computing Power für alle der gleiche sein – wie das Urmeter?

Solche und weitere Fragen haben uns veranlasst, diesen Ansatz vorzustellen. Mit der Ende 2010 angestellten Analyse haben wir das verifiziert. Danken möchte ich allen Teilnehmern, die ihre Server-Daten zur Verfügung stellten und mit Interesse und Fragen, sowie Hinweisen zur Methodik diese Analyse begleiten.

Ziel und Vorgehensweise

Für manche Server gibt es einen Benchmark-Wert. Zum Beispiel hat der Fujitsu Primequest 580 mit 32 Itanium2 Prozessoren und 2.048 GB RAM einen TPC-Wert von 2.382.032.

Die Mehrzahl der Server hat aber gar keinen solchen Benchmark. Zum Beispiel können der

• HP 9000 Enterprise N-Klasse N400 mit 8 PA 8500 Prozessoren

oder der

• HP ProLiant 460c G1 mit dem XEON Quadcore E5355 und 8 GB RAM

keinen Benchmark vorweisen. Zurzeit werden dennoch die „unvermessenen“ Server mindestens ebenso zahlreich im Markt verkauft und eingesetzt, wie die gebenchmarkten Modelle.

Baut man im Unternehmen eine interne Leistungsverrechnung für die Leistungen der IT auf, so gerät man unweigerlich in den Zwang, auch für diese Rechner eine Leistungseinheit zu ermitteln. Das gleiche Problem taucht auf, wenn man im Sourcing Prozess vor der Auswahl verschiedener Angebote steht. Es gibt dann zwei Optionen:

• die Systemprogrammierer entwickeln aus den eigenen Anwendungen des Unternehmens eine Reihe von Programmen, die man zum Test auf jedem neu zu beschaffenden Rechner laufen lässt und die Ergebnisse misst. Das ist sehr aufwendig.

oder

• man versucht die Leistung aus bekannten Daten zu errechnen. Wir haben diesen Weg versucht.

Es stellte sich dabei heraus, dass die Anzahl Rechenkerne, deren Frequenz und der eingebaute Arbeitsspeicher (RAM) hinreichende Aussagen über die Computing Power erlauben, um vor groben Missgriffen geschützt zu sein.

Man braucht nicht mehr die Lieferanten um Angaben zu bitten, die diese selten verfügbar haben und noch seltener herausgeben.

Auch braucht man nicht mehr in einer Rechnerfamilie eines Herstellers zu bleiben, nur weil man keine vergleichbaren Angaben in den anderen Angeboten findet.

Ergebnisse

Nach einigen Versuchen wurde als Server-Leistungswert folgende einfache Formel definiert:

Anzahl Cores mal Frequenz in Megahertz plus RAM in Megabyte

oder:

Cores * Mhz + RAM (MB)

Die benötigten Angaben liegen uns derzeit für fast 2.000 Servertypen vor. Alle anderen Benchmark-Werte existieren höchstens für einige Hundert Servertypen, zum Beispiel die SAPs für rund 700 Typen.

Rund 4.000 Typen sind ganz ohne Leistungswerte im Markt. Da das Vermessen eines Servertyps bei SPEC oder TPC um die 100.000 USD kosten soll, sparen die Hersteller Mühe und Kosten, um solche unabhängigen Tests durchzuführen.

Wir haben dann analysiert ob die sich ergebenden SLW mit den traditionellen Benchmark-Werten kor-relieren. Im Aufsatz „Endlich ein Urmeter fürs Computing!“ wurden die Ergebnisse in der Zeitschrift IT-Management Januar/Februar 2010 vorgestellt, ebenso in Vorträgen bei der Gesellschaft für Informatik(GI) und beim Verband deutscher Wirtschafts-Ingenieure (VWI). Inzwischen trafen weitere Bestätigungen ein. Dennoch sollte man den Titel lieber mit einem Fragezeichen verstehen, denn durch neue Rechner-Architekturen (z.B. Power 7) ist eine durchgängige Brauchbarkeit dieser einfachen Formel für alle Zeiten nicht sicher vorherzusagen.

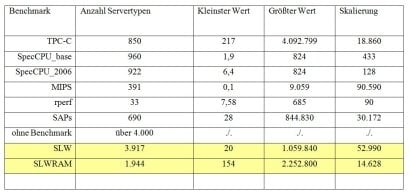

Die Tabelle zeigt hierzu einige Details. In unserer Datenbank, die derzeit Daten von rund 7.500 Server-Modellen aller Hersteller umfasst, befinden sich für die wichtigsten Benchmarks folgende Angaben:

Man sieht, dass der SLW viel breitere Anwendung findet als alle anderen Benchmarks. Selbst unter Einbezug des RAM ist die Skalierung fast so feinkörnig wie die von TPC-C. Zwar ist es denkbar, dass man durch mathematische Variationen der Formel eine noch bessere Korrelation mit den traditionellen Benchmark-Werten erreichen könnte.

Allerdings ist eine perfekte Übereinstimmung des einfachen SLW mit den hochkomplexen Benchmark-Tests für Zwecke des IT-Finanzmanagement meist gar nicht zielführend. Hier genügt es vielmehr, eine annähernd aussagefähige Bewertung von Rechnern vorzunehmen. Diese kann mit einer Ungenauigkeit von 10 bis 20 Prozent gute Dienste tun, weil sie den Vorteil hat, alle im Rechenzentrum vorhandenen Rechner ein-zuschließen.

Jeder IT-Verantwortliche kann mit wenig Aufwand aus seiner RZ-Statistik oder den Lieferpapieren die nötigen Angaben:

-

Anzahl Prozessoren bzw. Kerne

-

Mhz

-

RAM

für jeden einzelnen Rechner feststellen und daraus den SLW errechnen.

Folgende Beispiele zeigen diese Berechnung und möglichen Nutzen aus der Bewertung.

Rechenzentrums-Vergleich nach Gesamtkosten für das Computing

Die Beispiele zeigen einen Vergleich der Computing-Power einiger Rechenzentren mit Outsource oder Cloud-Angeboten. HP-US, Amazon EC2, Microsoft Azure sind hier nur stellvertretend herangezogen, weil sie für IT-Infrastruktur die klarsten Preis-Listen anbieten.

Zum Beispiel bekommt man bei Amazon für 0,085 USD oder rund 7 Euro-Cent eine Standard-Instanz mit einer EC2-Unit (bei Linux/Unix, 0,12 USD für Windows) für eine Stunde, die ziemlich genau 1.700 SLW-Stunden leistet. Dabei liegt ein virtueller Rechenkern zugrunde. Um die Abweichungen bei Hardware-Wechsel und anderen Einflüssen zu neutralisieren, vermisst Amazon diese Leistung ständig mit mehreren Vergleichswerten und sagt dem Kunden gleiche Leistung für das gleiche Geld zu.

Ausserdem gibt es einen Spotmarkt, wo diese Unit etwa zum halben Preis gehandelt wird, also 3,5 Cent für 1.700 SLW-Stunden oder 2,05 Euro-Cent für 1.000 SLW-Stunden. Nimmt man einen „virtuellen Faktor“ von 5 an, d.h. dass man real nur ein Fünftel der Ressourcen wirklich nutzen kann, so muss man den Preis verfünffachen. Man erhält damit 1.000 SLW-Stunden für rund 10 Euro-Cent.

Alternativ kann man sich eine Instanz für ein Jahr reservieren. Dann kostet die Stunde einschliesslich der anteiligen Grundgebühr etwa 0,05 USD, für Windows 0,07 USD und hat keine virtuellen Mitnutzer der Ressourcen. Veranschlagt man die virtuelle Mitnutzung auch hier mit dem Faktor 5, so bedeutet dies, dass man für 0,01 USD die gleiche Leistung erhält wie bei der Standard Instanz für 0,085 USD. Damit stellt sich der Preis für 1.000 SLW-Stunden auf rund 1,3 Euro-Cent.

Bei Microsoft liegt das Azure-Angebot bei 0,0852 EURO je Stunde für die „kleine Instanz“. Es handelt sich ebenfalls um einen virtuellen Server. Dabei wird dem Kunden jedoch ein Rechnerkern zur alleinigen Nutzung während der gebuchten Zeit reserviert. Die darunter liegende Virtualisierungsschicht ist lt. Microsoft so konfiguriert, dass der Core auch bei Nicht-Auslastung von keinem anderen Kunden genutzt wird. Dem Kunden wird so die gesamte Rechenleistung des gebuchten Cores garantiert. Die Frequenz des Prozessors ist 1,6 GHz.

Der Einfachheit halber nehmen wir an, dass die Leistung etwa ähnlich der von Amazon ist.

Hewlett Packard bietet mit seinen virtuellen Server Basis Performance Units (VIBE) eine virtuelle CPU mit 500 MHz und 1 GB RAM für einen Monatspreis von Euro 11,81. Dort kostet also die Stunde Euro 0,0164 (geteilt durch 720 Stunden) und man erhält dafür 500 SLW-Stunden. 1.000 SLW-Stunden kosten bei HP damit Euro 0,032, allerdings bei einer Bindung von mindestens einem Monat, Bereitstellungszeit von mindestens 5 Tagen und weiteren Einstiegshürden.

FAZIT: für das Computing muss man bei Cloud-Angeboten derzeit zwischen gut einem und knapp zehn Cent rechnen. Für die folgenden Vergleiche rechnen wir mit einem mittleren Vergleichspreis von 5 EuroCent je 1000 SLW-Stunden.

Rechenzentrum I

Das Rechenzentrum eines Dienstleisters hat 220 Server und 2,34 Mio. SLW. Die Jahreskosten betragen etwa Euro 2,0 Mio. Damit kostet ein SLW pro Jahr rund Euro 0,85. Da das Jahr 8.760 Stunden hat, kosten 1.000 SLW-Stunden den 8,76-sten Teil von Euro 0,85. Das sind 0,85/8,76 gleich 0,0975 Euro oder 9,57 Cent für 1.000 SLW-Stunden. Das ist fast das Doppelte des oben dargestellten Vergleichs-Preises aus der Cloud.

Rechenzentrum II

Das RZ eines Handels-Unternehmens betreibt gut 200 Server, die zusammen auf 7,1 Mio. SLW kommen. Das sind rund 62.390.500 mal 1.000 SLW Stunden.

Mit dem Cloud-Vergleichs-Preis würden sich Jahreskosten von 62,39 Mio. mal 0,05 Euro = Euro 3,1 Mio. ergeben. Die tatsächlichen Kosten liegen deutlich darüber.

Rechenzentrum III

Ein drittes RZ wird von einem Dienstleister im Versorgungsbereich betrieben und hat rund 360 Server mit einer Gesamtleistung von 12,6 Mio SLW. Dies ergibt eine Jahres-Gesamtleistung von 110.997.890 mal 1.000 SLW-Stunden.

Mit dem Vergleichs-Preis würden sich Jahreskosten von 110,997 Mio. mal 0,05 Euro = Euro 5,5 Mio. ergeben. Tatsächlich belaufen sich die vergleichbaren Jahreskosten auf nahezu 10 Mio. Euro.

Rechenzentrum IV

In einem weiteren RZ, das von einem TK-Dienstleister betrieben wird, stehen rund 100 Server, die zusammen auf eine SLW Summe von 3.354.700 kommen. Im Jahr können diese insgesamt rund 29.390.000 mal 1.000 SLW-Stunden leisten.

Mit dem Vergleichs-Preis würden sich Jahreskosten von 29,39 Mio. mal 0,05 Euro = etwa Euro 1,5 Mio. ergeben. Auch hier liegen die echten Kosten viel höher.

Schlussfolgerungen

Computing-Gesamtkosten

Zunächst sieht es so aus, dass die Cloud-Angebote meist um den Faktor zwei günstiger sind, als eigenbetriebene Rechenzentren.

Doch gibt es noch gewisse Einschränkungen in der Aussage. Einmal beziehen sich Cloud-Preise sehr eng auf das reine Computing als Preisbasis. Zwar sind Nebenleistungen, wie RAM, DAS-Speicher je nach Definition noch mit enthalten, aber für Storage, Input/Output hat man oft zusätzliche Beträge zu entrichten. Bei den oben genannten Eigen-Rechenzentren sind diese Kosten ebenfalls herausgehalten, aber ob das immer sauber und scharf genug gelingt ist offen. Zu viele Unzulänglichkeiten herrschen in den IT- Kostenrechnungen.

Ausserdem hat man beim eigenen RZ naturgemäß andere Nebenleistungen, Mitwirkungs- und sogar Einwirkungsmöglichkeiten. Ob dies ein Vor- oder Nachteil ist, lassen wir hier dahingestellt. Jedenfalls wirken sich diese in höheren Kosten aus, weil sie fast immer in personellen Ressourcen ausmünden. Diese wären ganz sauber herauszurechnen, um auf das reine Computing zu kommen, wie man es aus der Cloud bezieht.

Keinesfalls können diese Unschärfen aber einen doppelt so hohen Preis rechtfertigen und das gilt vor allem, je grösser das Computing –Volumen ist.

Man wird also nach anderen Vorteilen suchen müssen, wenn man das eigenbetriebene Rechenzentrum gegenüber einem Cloud-Angebot auf Dauer rechtfertigen will. Die reine Computing Power ist jedenfalls dort preiswerter zu haben.

Es ist zwar weltfremd, die Workload eines dedizierten Rechenzentrums einfach in ein Cloud-Angebot von Amazon, Microsoft oder einem beliebigen anderen Anbieter auszulagern. Die Vergleichs-Daten legen jedoch nahe, dass der SLW bei aller Ungenauigkeit doch erheblich zur strategischen Beurteilung im Rahmen des IT-Finanzmanagement beitragen kann.

Rechenzentrums-Abrechnung

Ein anderer Nutzen für den SLW ergibt sich, wenn man die Computing Leistung einer Server-Farm oder eines Rechenzentrum auf die Nutzer weiterverrechnen will. Üblicherweise sind die installierten Server zu unterschiedlichen Zeitpunkten gekauft worden und haben sehr unterschiedliche Leistungs-Kapaziäten. Nicht selten kommt es vor, dass der stärkste Server 30 mal mehr leistet als der schwächste Server im gleichen RZ.

Im Rahmen der Virtualisierung kann man häufig nicht mehr genau festhalten, wo eine bestimmte Workload gerade läuft. Wenn die Anwendung gerade wenig genutzt wird, verschiebt der Balancer sie möglicherweise kurzfristig auf eine schwächere Hardware, um die stärkeren Server für high-priority Lasten freizubekommen.

Will man dem Kunden wenigstens in etwa „gleiche Leistung für das gleiche Geld“ bieten, kann man mit Hilfe des SLW sinnvolle Zuordnungen für alle Server und die abgenommenen Leistungs-Stunden festlegen, so dass der Kunde dann auch weniger bezahlen muss, wenn seine Workload auf einer schwächeren Hardware betrieben wird. Sie läuft dort zwar länger, weil der Rechner langsamer ist. Daher wird man die SLW je nach der genutzten Plattform noch mit einem Geschwindigkeitsfaktor qualifizieren, der längere Laufzeiten verbilligt, selbst wenn die gleiche Menge SLW-Stunden verbraucht wurde.

Mit einem solchen Preis pro 1.000 SLW-Stunden werden die Kunden gerechter behandelt, als wenn sie einfach nach Server-Stunden, CPU-Stunden oder ähnlichem bezahlen müssten, wo gar kein Unterschied nach Kapazität und Schnelligkeit gemacht wird.

Ergebnisse

Es soll nicht der Eindruck erweckt werden, dass bereits eine Art „Urmeter“ für das Computing erfunden wurde. Dafür sind noch zu wenige konkrete Daten bekannt, vor allem was die Ausstattung der Rechner und die Jahres-Gesamtkosten angeht.

Die bisher von den Rechenzentren erhalten Daten zeigen, dass der Server Leistungswert ein taugliches Instrument zur schnellen Beurteilung von Fragen des IT-Finanzmanagement ist.

Damit sind die bekannten Benchmark –Verfahren und –Werte nicht generell überflüssig. Vor allem wenn es um technische Fragen, um die Machbarkeit bestimmter Anforderungen und die Abarbeitung vorhandener legacy Workloads geht, kann man auf genaue technische Daten und Messungen nicht verzichten.

Beim Finanzmanagement geht es aber regelmäßig um andere Anforderungen. Es kommt auf die einfache und schnelle Einschätzung und den wertmässigen Vergleich an.

Da belastbare Leistungswerte weder von Herstellern, Anbietern noch von Dritten zuverlässig, flächendeckend und kostengünstig erhältlich sind, kann der SLW gute Dienste tun. Überall, wo es keinen Benchmark –Wert gibt, ist er ohnehin das Mittel der Wahl. Jede andere Hilfslösung bietet noch weniger, ein Urteil über preiswerten Einkauf und leistungsgerechte Verrechnung an die Kunden zu bilden.

Grundsätzliches zu Leistungswerten und Metriken fürs Computing

Bis etwa Mitte der 1990-er Jahre wurde die Leistung von Rechnern in MIPS gemessen. Durch die Ver-lagerung auf Server fiel diese Metrik weitestgehend fort. An die Stelle traten teilweise die Benchmarks von TPC und SPEC sowie SAP und eine Vielzahl weiterer, unbedeutender Benchmarks. IBM vermisst seine eigene Serverwelt mit dem hauseigenen rperf-Verfahren.

In der Praxis wird derzeit noch weitestgehend auf derartige Leistungsmessung verzichtet, weil sie zu kompliziert oder gar nicht erhältlich ist.

Mit dem Server Leistungswert SLW wird vorgeschlagen, eine einfache Methode bei der Anschaffung und Weiterverrechnung von Computing anzuwenden, die insbesondere beim zu erwartenden Cloud-Markt eine verlässliche und transparente Basis darstellt

Um die Werte weiter zu erhärten, sind alle Leser freundlich eingeladen, ihre Serverdaten in aller Kürze über www.jomi1.com, dort Aktuelles / Umfragen / SLW mitzuteilen. Einsender erhalten im Gegenzug jeweils eine aktuelle Auswertung ihres Serverparks.

Jochen K. Michels