Um die Digitalisierung voranzutreiben, müssen große Datenmengen mithilfe von KI verarbeitet werden. Allerdings ist der KI-Einsatz auch mit Risiken verbunden, und zahlreiche Angriffsszenarien sind denkbar.

KI-Systeme sollten deshalb zwei Grundanforderungen erfüllen: die Nutzung zuverlässiger Eingabedaten, Algorithmen und Modelle sowie den hohen Schutz vor Manipulationen.

Systeme, die auf KI und ML (Maschinellem Lernen) basieren, prägen in immer stärkerem Maße die Arbeits- und Lebenswelt. Das Anwendungsspektrum auch in kritischen Bereichen wächst kontinuierlich, von der Automatisierung in Fabriken über das Autonome Fahren bis zur Tumorerkennung in der medizinischen Diagnostik. Je stärker KI und ML zentrale Aufgaben und Funktionen quasi „alleine“ übernehmen, umso wichtiger wird ein verantwortungsvoller Umgang mit den Technologien. KI-Systeme müssen vor allem zuverlässig und sicher sein: mit exakten Vorhersagen und einer systematischen Abwehr von Angriffen und Manipulationen.

Eine Gefahr stellen vor allem KI-Systeme dar, die einen falschen Input während des Lernens oder der Vorhersage erhalten. Dabei sind prinzipiell mehrere Arten von Angriffen zu unterscheiden, die unterschiedliche Lebenszyklusphasen des KI-Systems betreffen.

Risiken der Trainings- und Interferenzphase

KI-Systeme werden während des Anlernens mit umfangreichen Trainingsdaten gefüttert. Wenn die Integrität der Datensätze nur unzureichend verifiziert wird, kann dies die Funktion eines lernenden Systems beeinträchtigen. Das Ergebnis kann eine reduzierte Vorhersagegenauigkeit des Systems sein. Durch Manipulation der Trainingsdaten könnten Fehlentscheidungen des Modells sogar gezielt „vorprogrammiert“ werden.

Doch auch das Ergebnis eines ML-Prozesses kann das Ziel einer Attacke sein. Dabei steht nicht die Manipulation des gelernten Modells, sondern der Output – also das Ergebnis – im Fokus. Es gibt verschiedene denkbare Szenarien. Bei der Umgehung eines Modells etwa ändert ein Angreifer seine Abfragen so lange, bis er ein gewünschtes Ergebnis erhält, zum Beispiel um einen günstigen Versicherungsvertrag zu bekommen. Ebenso kann er eine funktionale Kopie des Modells erstellen, indem er in einem iterativen Vorgehen den Modell-Output auswertet. Durch Analyse der Offline-Kopie des Modells kann er einen Angriff auf das KI-System vorbereiten, beispielsweise wenn er herausfindet, ob ein bestimmter Datensatz für das Training verwendet wurde. Zudem kann er sogar Trainingsdaten rekonstruieren und dadurch personenbezogene Daten gefährden.

KI-Schutzmaßnahmen

Angesichts der potenziellen Angriffsvektoren muss ein KI-Anwender umfassende Abwehrmaßnahmen ergreifen. In erster Linie sind der Datenschutz sowie -sicherheit zu gewährleisten. Dies erfolgt zum einen durch konventionelle Schutzmaßnahmen für Informationssysteme, etwa durch die Zugriffskontrolle sowie Verschlüsselungsverfahren bei der Datenkommunikation. Zum anderen benötigen KI-Systeme spezifische Schutzmaßnahmen für die Risikominimierung, wie etwa die Erweiterung der Trainingsdaten um Adversarial-Datenbeispiele.

Die KI-Schutzmaßnahmen sind Gegenstand aktueller Forschung, für deren Umsetzung entsprechende Standards entwickelt werden müssen. Im Fokus steht derzeit die Verhinderung von Manipulationen, Sicherheitstestverfahren, die Erklärbarkeit und der Datenschutz.

So werden technische Ansätze untersucht, die lernende Systeme gegen manipulierte Eingaben härten. Dies betrifft zum einen die Datenverarbeitung, etwa mit dem Erkennen von Datensätzen, die Anomalien aufweisen und ein ungewöhnliches Verhalten der KI-Systeme hervorrufen. Zum anderen geht es dabei um die KI-basierten Vorhersagen, etwa die Beobachtung der Input-Daten, der Nutzung und des Verhaltens des KI-Systems sowie der Output-Daten, um wiederum Anomalien zu erkennen, die auf Angriffe hinweisen. Weiterhin kann die Verwendung spezieller Modellarchitekturen wie Ensemble-Methoden die Robustheit gegen Angriffe erhöhen. Zudem wird an Techniken geforscht, die Modelle auch im Hinblick auf Sonderfälle untersuchen und damit mögliche Sicherheitsrisiken aufdecken. Ein weiterer wichtiger Aspekt ist die Erklärbarkeit. Das Verständnis der trainierten Modelle und ihrer Vorhersagen erhöht die Vertrauenswürdigkeit und verbessert die forensischen Analysemöglichkeiten sowie die Nachvollziehbarkeit der Vorhersagen. Schließlich arbeiten Entwickler an neuen Methoden, die auf einen Schutz persönlicher Daten abzielen.

Differential Privacy (DP) erlaubt es, aggregierte persönliche Daten auszuwerten und dabei die Privatheit von Individuen zu schützen. Angewandt im Machine-Learning-Prozess kann so die Extraktion sensitiver Informationen aus den Trainingsdaten und dem trainierten Modell verhindert werden.

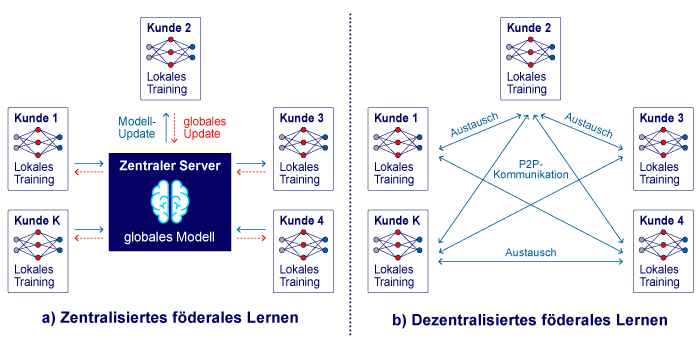

Ein anderes Beispiel findet sich im föderalen Lernen (federated Learning): Dabei werden zunächst lokale KI-Modelle trainiert. Anschließend wird mit den einzelnen Analysemodellen, Lernergebnissen und Parameterdaten ein zentrales KI-Modell konzipiert. Dieser Prozess bietet zwei Vorteile: erstens werden Datenschutzbestimmungen eingehalten, da die Trainingsdaten immer auf der lokalen Maschine verbleiben. Zweitens führt die Verwendung einer größeren Datenmenge zu einer Optimierung der Modellqualität.

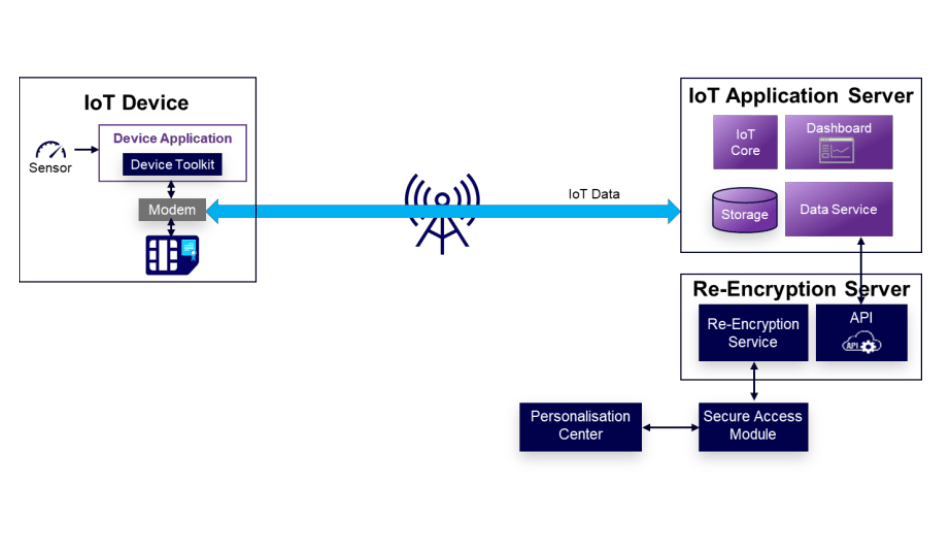

Konventionelle Schutzmaßnahmen anhand einer IoT-Anwendung

Ein IoT-Szenario kann die erforderlichen konventionellen Schutzmaßnahmen beispielhaft beschreiben. Wenn ein IoT-Gerät Daten generiert und in der Cloud das ML-Modell trainiert wird, könnte ein Angreifer die gesendeten Trainingsdaten für einen Angriff auf das Modell manipulieren und damit die Integrität des KI-Systems gefährden. Einen Schutz vor diesen Bedrohungen und eine hohe Cybersicherheit kann ein IoT-Anwender hier erzielen, wenn er dem IoT-Gerät beispielsweise ein sicheres Element in Form einer SIM-Karte hinzufügt. Mit einem enthaltenen Applet erfolgen dann die Authentifizierung und Datentransportabsicherung zur Cloud. Darüber hinaus sollte eine anwendungsspezifische Absicherung der IoT-Daten erfolgen. Damit werden die Informationen sicher zwischen dem IoT-Gerät und der IoT-Anwendung in der Cloud übertragen, unabhängig vom Kommunikationskanal wie Breitband, NB (NarrowBand)-IoT oder Wi-Fi. Die G+D IoT Security Suite bietet dafür eine flexible und modulare Lösung. Auch der Endpunkt zur Verwendung des Modells sollte geschützt sein, sodass nur autorisierte Nutzer Anfragen an das Modell senden können. Dies schützt die Vertraulichkeit des KI-Systems, ansonsten könnte ein Angreifer durch geschickte Anwendung Informationen über das Modell und die verwendeten Trainingsdaten erhalten.

KI ist für den Fortschritt unerlässlich und spielt gerade im Prozess der digitalen Transformation eine wichtige Rolle. Auch im neuen Koalitionsvertrag wird KI als Schlüsseltechnologie der Zukunft bezeichnet. Ein unkritischer und vorbehaltloser KI-Einsatz kann aber nicht das Ziel sein. KI mag zwar für Effizienz, Geschwindigkeit und Genauigkeit stehen, ebenso wichtig sind aber Sicherheit und Transparenz.

| Hinweis: Informationen zu möglichen Schutzmaßnahmen liefert der Report „Securing Machine Learning Algorithms“ der ENISA (European Network and Information Security Agency). |