In allen Branchen legen Unternehmen immer mehr Wert auf die Erfassung von Daten und die Suche nach innovativen Wegen zur Gewinnung verwertbarer Erkenntnisse. Unternehmen sind bereit, viel Zeit und Geld zu investieren, um dies zu erreichen.

Laut IDC erreichte der Markt für Daten- und Analysesoftware und Cloud-Services im Jahr 2021 ein Volumen von 90 Milliarden US-Dollar und wird sich bis 2026 voraussichtlich mehr als verdoppeln, da Unternehmen weiterhin in künstliche Intelligenz und maschinelles Lernen (KI/ML) sowie moderne Dateninitiativen investieren.

Trotz der hohen Investitionen führen Datenprojekte jedoch häufig zu unzureichenden Ergebnissen. Eine kürzlich von McKinsey durchgeführte Umfrage zu fortgeschrittenen großen Analyseprogrammen ergab, dass Unternehmen 80 Prozent ihrer Zeit mit sich wiederholenden Aufgaben wie der Aufbereitung von Daten verbringen, bei denen nur ein begrenzter Mehrwert erzielt wird. Außerdem wurde festgestellt, dass nur 10 Prozent der Unternehmen das Gefühl haben, dieses Problem im Griff zu haben.

Warum also sind die Misserfolgsquoten bei Datenprojekten trotz erhöhter Investitionen und Aufmerksamkeit so hoch?

Viele Variablen können den Projekterfolg beeinflussen. Häufig genannte Faktoren sind die Projektkomplexität und begrenzte Talentpools. Datenwissenschaftler*innen, Cloud-Architekt*innen und Dateningenieur*innen sind weltweit Mangelware. Die Firmen erkennen auch, dass viele ihrer Datenprojekte scheitern, weil sie Schwierigkeiten haben, die Dateninitiativen in großem Umfang in der Produktion umzusetzen.

Dies hat zur Entstehung von DataOps als neuem Rahmenwerk zur Überwindung gemeinsamer Herausforderungen geführt. DataOps ist die Anwendung von agilem Engineering und DevOps-Best-Practices auf den Bereich des Datenmanagements, um Unternehmen dabei zu helfen, neue Erkenntnisse schnell in vollständig operationalisierte Produktionsergebnisse umzuwandeln, die den Geschäftswert von Daten freisetzen. DataOps-Tools und -Methoden können Firmen helfen, ihre Dateninvestitionen optimal zu nutzen. Aber wenn Firmen mit DataOps erfolgreich sein wollen, müssen sie in der Lage sein, die Daten zu operationalisieren.

Herausforderungen bei der Datenorchestrierung

Die meisten Datenpipeline-Workflows sind äußerst komplex und laufen über viele verschiedene Anwendungen, Datenquellen und Infrastrukturtechnologien, die zusammenarbeiten müssen. Obwohl das Ziel darin besteht, diese Prozesse in der Produktion zu automatisieren, ist es in der Realität so, dass ohne eine leistungsstarke Plattform für die Workflow-Orchestrierung die Bereitstellung dieser Projekte im Unternehmensmaßstab teuer sein kann und oft einen erheblichen Zeitaufwand für manuelle Arbeiten erfordert.

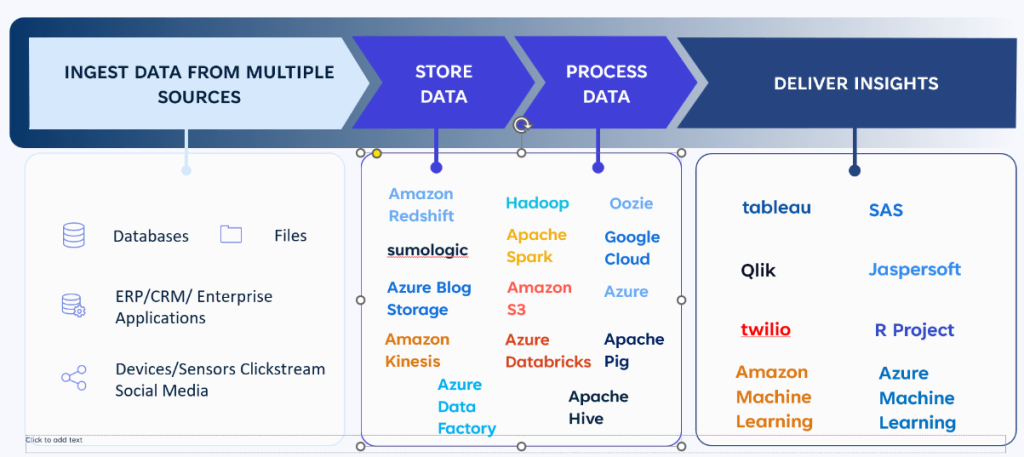

Projekte zur Orchestrierung von Daten-Workflows haben vier Hauptphasen:

- Die Aufnahme umfasst das Sammeln von Daten aus traditionellen Quellen wie ERP- und CRM-Lösungen, Finanzsystemen und vielen anderen Aufzeichnungssystemen sowie Daten aus modernen Quellen wie Geräten, IoT-Sensoren und sozialen Medien.

- Die Speicherung erhöht die Komplexität mit zahlreichen verschiedenen Tools und Technologien, die Teil der Datenpipeline sind. Wo und wie Unternehmen Daten speichern, hängt stark von der Persistenz, dem relativen Wert der Datensätze, der Aktualisierungsrate ihrer Analysemodelle und der Geschwindigkeit ab, mit der sie die Daten zur Verarbeitung weiterleiten können.

- Bei der Verarbeitung stellen sich viele der gleichen Herausforderungen. Wie viel reine Verarbeitung ist erforderlich? Ist sie konstant oder variabel? Ist sie geplant, ereignisgesteuert oder ad hoc? Wie können Firmen die Kosten minimieren? Die Liste lässt sich beliebig fortsetzen.

- Die Bereitstellung von Erkenntnissen erfordert die Übertragung der Datenausgabe an Analysesysteme. Auch diese Ebene ist komplex, wobei eine wachsende Zahl von Tools die letzte Meile in der Datenpipeline darstellt.

Da häufig neue Daten- und Cloud-Technologien eingeführt werden, müssen Unternehmen ihre Technologie-Stacks ständig neu bewerten. Diese sich ständig weiterentwickelnde Innovation erzeugt Druck und Abwanderung, was eine Herausforderung darstellen kann, da Unternehmen neue Technologien problemlos übernehmen und in der Produktion skalieren müssen. Wenn ein neuer Datenanalysedienst nicht im Produktionsmaßstab eingesetzt wird, erhalten Unternehmen letztlich keine verwertbaren Erkenntnisse und erzielen keinen Mehrwert.

BMC-Data workflow project

Produktion in großem Maßstab erreichen

Die erfolgreiche Ausführung geschäftskritischer Workflows im Produktionsmaßstab ist kein Zufall. Die richtige Workflow-Orchestrierungsplattform kann Firmen dabei helfen, ihre Datenpipelines zu optimieren und die erforderlichen Erkenntnisse zu gewinnen.

Hier sind acht Schlüsselfunktionen, auf die Unternehmen bei ihrer Workflow-Orchestrierungsplattform achten sollten:

- Unterstützung heterogener Arbeitsabläufe: Unternehmen verlagern ihre Aktivitäten immer mehr in die Cloud und werden in absehbarer Zukunft Workflows in einer hochkomplexen Mischung aus hybriden Umgebungen einsetzen. Für viele wird dies die Unterstützung von Mainframes und verteilten Systemen im Rechenzentrum und mehreren privaten und/oder öffentlichen Clouds beinhalten. Wenn ihre Orchestrierungsplattform die Vielfalt der Anwendungen und der zugrundeliegenden Infrastruktur nicht bewältigen kann, werden Firmen eine stark fragmentierte Automatisierungsstrategie mit vielen Automatisierungssilos haben, die umständliche benutzerdefinierte Integrationen erfordern, um plattformübergreifende Workflow-Abhängigkeiten zu bewältigen.

- Verwaltung von Service Level Agreements (SLA): Geschäftsabläufe, die von ML-Modellen zur Risikovorhersage bis hin zu Finanzabschlüssen und Zahlungsabwicklungen reichen, haben alle Abschluss-SLAs, die manchmal durch Richtlinien von Aufsichtsbehörden geregelt sind. Die Orchestrierungsplattform muss in der Lage sein, Aufgabenausfälle und Verzögerungen in komplexen Workflows zu verstehen und Firmen darüber zu informieren, und sie muss in der Lage sein, Probleme auf breitere Geschäftsauswirkungen abzubilden.

- Fehlerbehandlung und Benachrichtigung: Im Produktionsbetrieb kommt es selbst bei den besten Arbeitsabläufen zu Fehlern und Verzögerungen. Es ist von entscheidender Bedeutung, dass die richtigen Teams benachrichtigt werden, damit langwierige War-Room-Diskussionen, nur um herauszufinden, wer an einem Problem arbeiten muss, vermieden werden können. Die Orchestrierungsplattform muss automatisch Benachrichtigungen an die richtigen Teams zur richtigen Zeit senden.

- Selbstheilung und Problembehebung: Wenn Teams auf Job-Fehler innerhalb von Geschäftsabläufen reagieren, ergreifen sie Korrekturmaßnahmen, wie z. B. den Neustart eines Jobs, das Löschen einer Datei oder das Leeren eines Cache oder einer temporären Tabelle. Die Orchestrierungsplattform sollte es Automatisierungsingenieur*innen ermöglichen, solche Aktionen so zu konfigurieren, dass sie beim nächsten Auftreten des gleichen Problems automatisch ausgeführt werden.

- Durchgängige Sichtbarkeit: Workflows führen miteinander verknüpfte Geschäftsprozesse über hybride Technologie-Stacks aus. Die Orchestrierungsplattform sollte in der Lage sein, die Abfolge der Workflows klar darzustellen. Dies ist wichtig, um die Beziehungen zwischen Anwendungen und den von ihnen unterstützten Geschäftsprozessen zu verstehen. Dies ist auch für das Änderungsmanagement wichtig. Wenn Änderungen vorgenommen werden, ist es wichtig zu sehen, was vor und nach einem Prozess passiert.

- Self-Service User Experience (UX) für mehrere Personas: Workflow-Orchestrierung ist ein Mannschaftssport mit vielen Beteiligten wie Datenteams, Entwickler*innen, Betreiber*innen, Geschäftsprozessverantwortlichen und anderen. Jedes Team hat unterschiedliche Anwendungsfälle und Präferenzen, wie sie mit den Orchestrierungs-Tools interagieren möchten. Das bedeutet, dass die Orchestrierungsplattform die richtige Benutzeroberfläche (UI) und UX für jedes Team bieten muss, damit sie von der Technologie profitieren können.

- Produktionsstandards: Die Ausführung von Workflows in der Produktion erfordert die Einhaltung von Standards, d. h. die Verwendung korrekter Benennungskonventionen, Fehlerbehandlungsmuster usw. Die Orchestrierungsplattform sollte über einen Mechanismus verfügen, der eine sehr einfache Möglichkeit bietet, solche Standards zu definieren und die Benutzer*innen bei der Erstellung von Workflows zu den entsprechenden Standards zu führen.

- Unterstützung von DevOps-Praktiken: Da Unternehmen DevOps-Praktiken wie kontinuierliche Integration und kontinuierliche Bereitstellung (CI/CD), die Entwicklung und Änderung von Workflows und sogar die Bereitstellung von Infrastrukturen für Workflows einführen, sollte die Orchestrierungsplattform in der Lage sein, sich in moderne Freigabepraktiken einzufügen.

Das bedeutet, dass die Fähigkeit, diese Daten zu speichern, zu verarbeiten und zu operationalisieren, für den Erfolg eines jeden Unternehmens entscheidend sein wird. DataOps-Praktiken in Verbindung mit leistungsstarken Orchestrierungsfunktionen können Unternehmen dabei helfen, Datenpipelines zu orchestrieren, den Datenbereitstellungsprozess zu optimieren und die Geschäftsergebnisse zu verbessern.

Guy Eden, VP Product Management bei BMC Software