Seitdem erstmals Daten gesammelt, gespeichert und verarbeitet wurden, ist die Datenqualität ein ständiges Problem in der Geschäftswelt. Das Thema ist also nicht neu. Neu sind in den letzten Jahren zwei Dinge: Zum einen rücken Daten mit Blick auf die Erfordernisse der digitalen Transformation mehr und mehr ins Zentrum des unternehmerischen Interesses.

Laut dem DataIQ Research Report (zus. mit Experian) gibt ein Drittel (33 Prozent) der Unternehmen an, dass die Datenqualität für den Erfolg ihrer digitalen Transformation von grundlegender Bedeutung ist, 54 Prozent sehen sie als eine der Kernkomponenten an. Zum anderen wächst die zu bewältigende Datenmenge sehr schnell in schwindelerregende Dimensionen. In seiner jüngsten Prognose zur Entwicklung der „Global Datasphere“ geht die International Data Corporation (IDC) davon aus, dass die globale Datenmenge von 33 Zettabytes (ZB) im Jahr 2018 auf 175 ZB bis 2025 anwachsen wird. Ein Anstieg um 430 Prozent in sieben Jahren. Ein ZB entspricht zehn hoch 21 = 1.000.000.000.000.000.000.000 Byte. Eine Zahl, die man sich nicht mehr wirklich vorstellen kann.

Datennutzung unzureichend

Wenn Unternehmen die digitale Transformation nutzen wollen, um Organisation und Prozesse effizienter gestalten und die Kundenerfahrung verbessern zu können, und dafür Daten so wichtig sind, wie gut nutzen Unternehmen dann ihre Daten? Danach gefragt, dies auf einer Skala von eins bis zehn zu bewerten, sagt Ray Wang, Principal Analyst, Gründer und Vorsitzender der im Silicon Valley ansässigen Constellation Research: „Schrecklich. Ich würde sagen, es liegt bei drei: Die meisten Organisationen nutzen die Daten, die sie in ihren Organisationen haben, kaum. Das liegt daran, dass sie alle in verschiedenen Abteilungen gespeichert sind.“ In einem Whitepaper zum Thema „Digital Transformation and the new data quality imperative“ aus dem Jahr 2018 schreibt Hortonworks, ein Anbieter von globalen Datenmanagement-Plattformen, -Diensten und -Lösungen, die Datensilos hätten dramatisch zugenommen, da Unternehmen, die nicht in der Lage sind, Einzelinstanz-Datenlösungen zu implementieren, die globale Anforderungen berücksichtigen, schnell zusätzliche (und oft redundante) Systeme implementieren, um enge regionale Anforderungen zu erfüllen. Zudem hätten solche dezentralisierten Datenverwaltungspraktiken auch zu siloartigen Ansätzen der Datenverwaltung (Data Governance) geführt.

Daten entsprechen grundlegenden Standards nicht

Es ist nicht weiter verwunderlich, wenn es vor diesem Hintergrund um die Datenqualität nicht allzu gut bestellt ist. Während – wie wir oben gesehen haben – 87 Prozent der Unternehmen verstehen, dass Datenqualität eine grundlegende oder bedeutende Komponente für den Erfolg ihrer digitalen Transformation ist, stimmen gleichzeitig 68 Prozent der Aussage sehr zu oder zu, schlechte Datenqualität wirke sich negativ auf die digitale Transformation aus. In einem Beitrag für Harvard Business Review stellen Thomas H. Davenport und Thomas C. Redman im März 2020 fest, es sei bedauerliche Realität, dass in vielen Unternehmen heutzutage die meisten Daten nicht den grundlegenden Standards entsprechen. Die Transformation erfordere eine viel bessere Datenqualität und Analyse. Daten stellten ein interessantes Paradoxon dar: Die meisten Unternehmen wüssten, dass Daten wichtig sind und sie wüssten, dass die Qualität schlecht ist, dennoch verschwendeten sie enorme Ressourcen, indem sie es versäumten, die richtigen Rollen und Verantwortlichkeiten festzulegen.

Datentransformation vor digitaler Transformation

Das Unternehmen Data Ladder aus Conneticut, ein Anbieter von Lösungen für Datenqualität und -bereinigung, hat mit Fortune-500-Kunden zusammengearbeitet, die der digitalen Transformation Priorität eingeräumt haben, nur um herauszufinden, dass ihre Daten dafür noch nicht bereit waren. Die häufigsten Probleme:

- Daten werden in unterschiedlichen Quellen gespeichert (s. oben).

- Ein von Menschen abhängiger und daher besonders fehlerhafter Datenerfassungsprozess.

- Datendubletten, weil die gleichen Verbraucherdaten immer wieder auf verschiedene Arten erfasst und in mehreren Datenquellen gespeichert werden.

- Daten, die keine „Single Source of Truth“ ergeben.

- Daten, die nicht für Business Intelligence aufbereitet, d.h. bereinigt oder optimiert werden.

Um diese Probleme zu lösen, müssen Unternehmen datengesteuert agieren, meint Farah Kim, Produktmarketing-Manager bei Data Ladder. Dazu gehöre das Verständnis, dass die Datentransformation – der Prozess der Umwandlung von Rohdaten in ein brauchbares Format – der digitalen Transformation vorangehe. Die Datentransformation sei das Mittel, um das Ziel der digitalen Transformation zu erreichen. Nach der Erfahrung von Data Ladder konnten Unternehmen, die ihre Daten aktiv transformierten und eine Data Governance einführten, ihren ROI steigern, ihre Betriebsprozesse optimieren, ihre Mitarbeiter wirkungsvoll einsetzen und schließlich in ein digitales Unternehmen übergehen. Das Resümee von Kim: „Um datengesteuert zu sein, benötigen sie Daten, denen sie vertrauen können. Um Daten zu erhalten, denen sie vertrauen können, müssen sie ein Datenqualitäts-Framework implementieren.“

Präventives Datenqualitätsmanagement notwendig

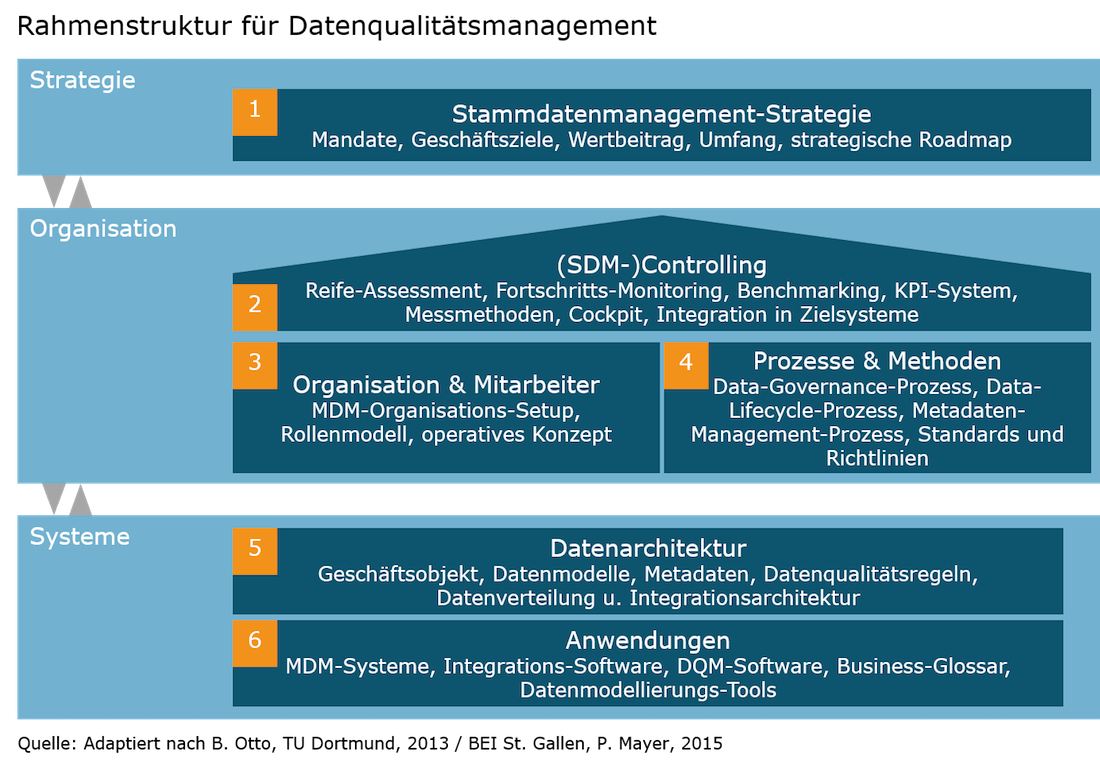

Um ihre Datenqualitätsprobleme zu beheben, müssen Unternehmen also dazu übergehen, Datenqualität aktiv und vorsorgend zu managen. Das Kompetenzzentrum Corporate Data Quality an der Hochschule St. Gallen (CC CDQ) und die EFQM haben dazu ein Rahmenwerk für Corporate Data Quality Management (CDQM) entwickelt. Es beschreibt Aktivitäten, die für ein effektives und effizientes Management unternehmensweiter Daten erforderlich sind. Unternehmen, die ein präventives Datenqualitätsmanagement betreiben wollen, müssen dazu Aufgaben auf drei Gebieten lösen: Strategie, Organisation und Systeme.

Auf strategischem Gebiet muss die Datenqualitätsmanagement-Strategie an der Unternehmensstrategie ausgerichtet werden. Dabei geht es darum, Optionen zum Datenmanagement zu bewerten, um darüber entscheiden zu können, wie Unternehmensdaten gemanagt und genutzt werden sollen. Dazu müssen unter anderem eine Vision, die Ziele und der erwartete Nutzen des Datenmanagement sowie eine strategische Roadmap festgelegt werden.

Die organisatorische Ebene umfasst nach Otto/Oesterle (2016) drei Gestaltungsbereiche: das Führungssystem für Datenqualitätsmanagement (auch: Datenqualitäts-Controlling), die DQM-Organisation sowie Prozesse und Methoden für DQM. Das Datenqualitäts-Controlling plant, implementiert und überwacht/steuert alle Aktivitäten zur Messung, Bewertung, Verbesserung und Sicherung der Datenqualität und der Performance des Datenqualitätsmanagements als organisationale Fähigkeit. Da Stammdatenmanagement ein Querschnittthema ist, müssen die Aufgaben des Datenmanagements über die einzelnen Divisionen, Geschäftsbereiche und Fachabteilung des Unternehmens hinweg koordiniert werden. Dazu werden in der DQM-Organisation Rollen und die dazugehörigen Verantwortlichkeiten definiert. Der Gestaltungsbereich „Prozesse und Methoden“ schließlich bezieht sich auf den Data-Governance-Prozess, den Lebenszyklusprozess für Stammdaten und auf die Standards und Richtlinien, die im Datenqualitätsmanagement einzuhalten sind.

Die Systemebene umfasst die Gestaltungsbereiche Datenarchitektur und Anwendungen. „Die Datenverteilungs- und Datenhaltungsarchitektur beschreibt, welche Daten in welchen Systemen gespeichert werden und zeigt die Datenflüsse zwischen den Systemen“, so Otto/Oesterle. Der Gestaltungsbereich „Anwendungen“ beziehe sich auf die Analyse, den Entwurf, die Implementierung und Verbesserung derjenigen Anwendungssysteme, die zur Unterstützung des Datenquali-tätsmanagements benötigt werden. Dazu zählen auch Stammdatenmanagement-Systeme, die die „eine Wahrheit“ für unterschiedliche Stammdatendomänen über den gesamten Geschäftsprozess hinweg sicherstellen.

Resümee

Unternehmen wollen aus Daten Information und aus Information erfolgskritisches Wissen gewinnen, um Entscheidungen auf Basis valider Fakten treffen zu können, die Aktionen zur Unternehmens- und Prozesssteuerung auslösen. Wer so zum einen Entscheidungen auf Fakten stellen und zum anderen bessere Entscheidungen treffen will, kommt an einem professionellen Datenqualitätsmanagement keinesfalls vorbei. Ansonsten ist mit Blick auf Stammdaten eines gewiss: Das Rückgrat des Unternehmens und der Geschäftsprozesse ist äußerst labil und die nachhaltig wirksame Nutzung des „Investitionsguts Daten“ in Frage gestellt. Das wiederum hieße, sehenden Auges das Risiko einzugehen, im Zuge der digitalen Transformation nicht nur keine besseren Entscheidungen zu treffen, sondern falsche.