Viele Unternehmen haben klare eigene Nachhaltigkeitsziele und unterliegen Anforderungen von Interessengruppen und Gesetzgebern, ihren Energieverbrauch zu senken.

Gleichzeitig steigt heutzutage der Energieverbrauch der IT aufgrund der zunehmenden Rechenleistung für KI und verwandte Anwendungen und wird daher zu einem immer größeren Kostenfaktor. So wird die Informationstechnologie als Faktor beim Energieverbrauch und beim Emissions-Fußabdruck in diesem Jahr in vielen Unternehmen kritisch hinterfragt, wobei die IT-Ausrüstung, wie Server und Kühlsysteme, einen wichtigen Faktor bei der Reduzierung des Energieverbrauchs von Rechenzentren darstellt. Doch wie können Unternehmen ihre Infrastruktur optimieren und die gesellschaftliche Verantwortung für eine nachhaltige Entwicklung übernehmen? IT-Infrastrukturanbieter KAYTUS zeigt, in welchen vier Bereichen Verbesserungen notwendig und sinnvoll sind und worauf dabei besonders geachtet werden sollte.

Positive und negative Faktoren in Europas Umweltbilanz

Die EU hat ihre Treibhausgasemissionen seit 1990 kontinuierlich gesenkt und im Jahr 2022 insgesamt eine Verringerung von -32,5% erreicht. Obwohl die Menge an Kohlenstoff, die in der EU aus der Atmosphäre entnommen wurde, im Vergleich zum Vorjahr gestiegen ist, ist die EU derzeit noch nicht auf dem Weg, ihr Ziel für 2030 zu erreichen, 310 Millionen Tonnen CO2 mehr aus der Atmosphäre zu entnehmen. Die EU-Mitgliedstaaten müssen ihre Bemühungen bei der Umsetzung deutlich verstärken und die Emissionsreduzierung beschleunigen, um das Ziel einer Netto-Treibhausgasreduzierung von -55 % bis 2030 und die Klimaneutralität bis 2050 zu erreichen.

Komplexe KI-Anwendungen erhöhen den Energiebedarf

Mit der Entwicklung von KI-Anwendungen wie generativer KI, maschinellem Lernen (ML), autonomem Fahren und vielen anderen, steigen der Energiebedarf von Servern und die Leistungsdichte von Computerchips und Serverknoten weiter an. Die Energieaufnahme von KI-Chips hat sich von 500 Watt auf 700 Watt erhöht und wird in Zukunft voraussichtlich 1000 Watt übersteigen. Mit der steigenden Energieaufnahme der Prozessoren steigen auch die Anforderungen an die Wärmeableitung des gesamten Geräts weiter an. Behörden der EU und weltweit haben hohe Anforderungen an die Energieeinsparung und Verbrauchreduzierung für umweltfreundlichere Rechenzentren gestellt. Die neueste Energieeffizienzrichtlinie der EU schreibt vor, dass Rechenzentren mit einem IT-Strombedarf über 100 Kilowatt jedes Jahr öffentlich über ihre Energieeffizienz berichten müssen.

Bis 2030 werden Rechenzentren voraussichtlich 3,2 Prozent des gesamten Strombedarfs in der EU ausmachen, was einem Anstieg von 18,5 Prozent im Vergleich zu 2018 entspricht. Um die gesetzten Umweltziele zu erreichen, sollten die Unternehmen also ihre Verantwortung für eine nachhaltige Entwicklung wahrnehmen. Da die Computerauslastung zunimmt, ist die Optimierung der IT-Infrastruktur für sie zu einer wichtigen Maßnahme geworden, um den Energieverbrauch zu senken und sich nachhaltig zu entwickeln.

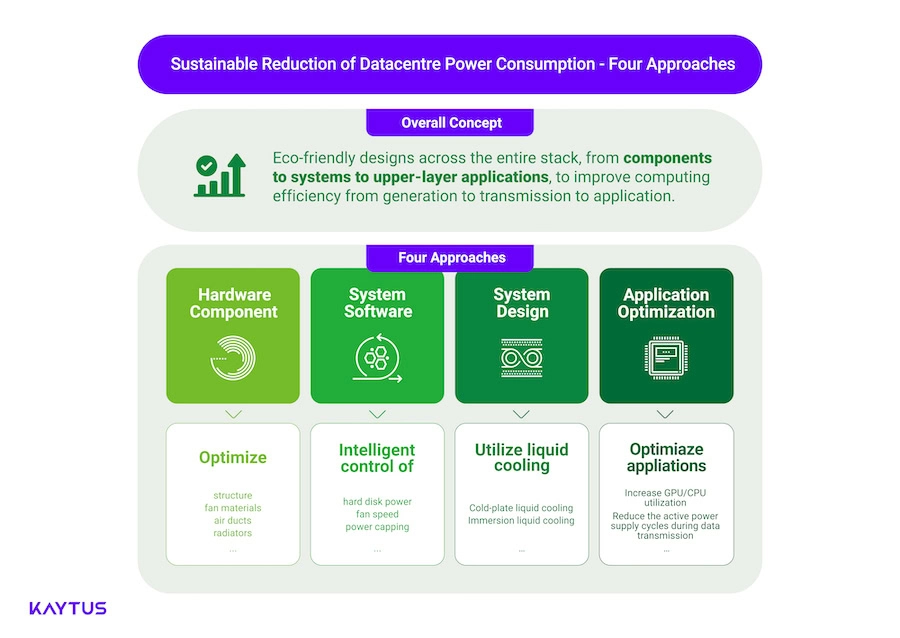

Vier wichtige Ansätze für ein umweltfreundlicheres Rechenzentrum

Doch wie können Unternehmen den Stromverbrauch von Rechenzentren minimieren? Bei der sogenannten “Green Computing”-Optimierung sollten folgende Faktoren im Vordergrund stehen: Hardware-Design, Software-Strategie, Verfeinerungen auf Systemebene sowie Anwendungsoptimierung, die alle auf die Steigerung der Energieeffizienz abzielen. Schauen wir uns die Optimierungsansätze im Detail an.

Ansatzpunkte bei Hardware-Komponenten

Auf der Ebene der Hardware-Komponenten kann die Optimierung des strukturellen Designs von Bauteilen wie Lüftern, Luftkanälen und Radiatoren dazu beitragen, die Effizienz der Wärmeableitung zu verbessern. So können etwa verbesserte Front- und Heckeinlässe und Lüfter für einen um bis zu 15 Prozent erhöhten und gleichmäßigeren Luftstrom sorgen und so die Kühlleistung maximieren. IT-Infrastrukturanbieter verwenden hierbei heute Simulationsexperimente, um zudem Form, Abstand und Anstellwinkel der Lüfterblätter zu verbessern und die Vibration zu verringern. Weiterhin können Motoreffizienz, interne Struktur und Materialien der Lüfter optimiert werden, um das Luftstromvolumen zu maximieren und den Energieverbrauch zu senken.

Luftkanäle mit geringem Strömungswiderstand machen den Luftstrom stabiler und effizienter. Hierbei empfiehlt sich ein horizontales Design und eine wabenförmige Luftöffnung mit Wellenprofil, um interne Turbulenzen effektiv zu unterbrechen, wodurch die Wärmeableitungseffizienz um mehr als 30 Prozent gesteigert werden kann.

Managern von IT- bzw. Rechenzentren wird empfohlen, mehrere unterschiedliche Kühllösungen zu entwickeln, um die Wärmeableitung von Hochleistungsprozessoren zu verbessern. Durch spezielle Kühlkörper und verschiedene Techniken wie Standard-Wärmeableitung, T-förmige Wärmeableitung, Siphon-Wärmeableitung, Kaltplatten (Cold Plate) -Wärmeableitung, usw. kann die Wärmeableitungseffizienz des gesamten Serversystems um mehr als 24 Prozent gesteigert, der Stromverbrauch eines Einzelknotenservers um 10 Prozent gesenkt und dadurch der Kühlbedarf eines 1U-Zwei-Sockel-Servers mit einem einzelnen 350-W-Prozessor abgedeckt werden.

Ansatzpunkte bei Software-Komponenten

Auf der Ebene der Software-Komponenten können Energiesparmaßnahmen wie eine individuelle energie-basierte Steuerung einzelner Festplatten, intelligente Geschwindigkeitsanpassung und Stromverbrauchsbegrenzung implementiert werden, die den Gesamtstromverbrauch des Servers um mehr als 15 Prozent senken können.

IT-Spezialisten können die Leistungssteuerung einzelner Festplatten automatisch an die Wärmeableitungsstrategie anpassen, das Ein- und Ausschalten einzelner Festplatten über CPLD steuern, den Systemdurchsatz auf einige Festplatten beschränken und andere Festplatten in den Ruhezustand versetzen. Damit können etwa 70 Prozent des Stromverbrauchs eingespart werden. Eine Anpassung der Wärmeableitungsstrategie hilft dabei, die Lüftergeschwindigkeit zu reduzieren und den Stromverbrauch der Kühlgeräte des Rechenzentrums zu senken. Im Vergleich zu herkömmlichen Serverstrukturen, kann der Stromverbrauch so pro TB um 315 Prozent gesenkt werden, wodurch 40 Prozent des Rechenzentrumsplatzes eingespart und die Gesamtbetriebskosten um mehr als 30 Prozent reduziert werden.

Eingebaute Sensoren helfen dabei, Temperaturinformationen in Echtzeit an verschiedenen Stellen eines Servers zu erfassen. Basierend auf einer dezentralen intelligenten Steuerungstechnologie und den gesammelten und ausgewerteten Daten wird die Lüftergeschwindigkeit in verschiedenen Luftkanälen angepasst, um eine energiesparende Lüftergeschwindigkeitsregelung und präzise Luftzufuhr zu erreichen.

Weitere Ansatzpunkte für IT-Systeme

Um die Effizienz der Rechenleistungsnutzung zu verbessern, die Leerlaufzeiten der Geräte zu reduzieren und somit einen geringeren Energieverbrauch zu realisieren, passen IT- und Rechenzentrumsexperten ihr gesamtes IT-System an die jeweiligen Gegebenheiten an und setzen auf ein gemischtes Luft-Flüssigkeits- oder auf ein reinrassiges Flüssigkühlungsdesigns zur Wärmeableitung, insbesondere bei Servern mit hoher Dichte, KI-Servern und Rack-Scale-Servern, wodurch der PUE-Wert (Power Usage Effectiveness) auf unter 1,2 reduziert wird.

Besonders effektiv erweist sich hier die sogenannte Kaltplatten-Flüssigkühlung (“Cold Plate Liquid Cooling”), die sich speziell für Komponenten mit hohem Stromverbrauch wie Prozessoren und Speicher eignet, die mehr als 80 Prozent des Stromverbrauchs eines Rechenzentrums ausmachen. Das Flüssigkühlmodul ist zudem idealerweise mit einer Vielzahl gängiger Kühlungsanschlüsse kompatibel, wodurch der Stromverbrauch des gesamten Servers effektiv reduziert und die Bereitstellungskosten gesenkt werden.

So kann eine Kaltplatten-Flüssigkühlung etwa den Kühlbedarf eines 1000W-Chips decken und einen Wärmeaustausch von 100 kW in einem einzigen Serverschrank unterstützen. Ein solcher flüssig gekühlter Serverschrank enthält oft dynamische Überwachungsgeräte, die eine intelligente Kontrolle der IT-Umgebung ermöglichen und eine Technologie zur Erkennung von Flüssigkeitslecks auf Knotenebene verwenden, um Alarme in Echtzeit zu ermöglichen. Ein solches flüssigkeitsgekühltes Rack-System zeichnet sich teilweise durch eine hervorragende Energieeffizienz aus: Es bietet eine höhere Rechnerdichte, eine um 50 Prozent höhere Wärmeableitungseffizienz und einen um 40 Prozent geringeren Stromverbrauch im Vergleich zur herkömmlichen Luftkühlung.

Darüber hinaus unterstützen flüssigkeitsgekühlte Server auch Kühlflüssigkeiten mit hohen Temperaturen, z. B. 45°C (113°F), am Einlass. Die hohe Temperatur der in das System zurückfließenden Flüssigkeit ermöglicht eine bessere Ausnutzung der Free-Cooling-Technologie, wodurch der Energieverbrauch erheblich gesenkt wird. Wenn flüssigkeitsgekühlte Systeme so ausgelegt sind, dass sie auch bei hohen Umgebungstemperaturen wie 45°C (113°F) effizient arbeiten, kann der Energieverbrauch im Rechenzentrumsbetrieb weiter gesenkt werden.

Ansatzpunkte zur Optimierung von Endanwendungen

Schließlich spielt auch der Ressourcenverbrauch der Endanwendungen (“Applikationen”) eine entscheidende Rolle beim Green Computing, und auch hier ist es wichtig, die Rechenlast der Anwendungen zu optimieren.

Hierfür sollten IT-Spezialisten die Arbeitslasten ihrer Server optimieren, um die GPU/CPU-Auslastung zu erhöhen und eine Konsolidierung auf weniger Servern zu ermöglichen. IT-Spezialisten können Strategien für das Pooling von Rechenleistung und die feinkörnige Aufteilung von Rechenressourcen nutzen, um die GPU-Auslastung zu maximieren. Dies kann von mehreren Instanzen auf einer einzigen Steckplatine bis hin zu groß angelegtem parallelen Computing auf mehreren Rechnern und Steckplatinen reichen. Die Auslastung der Cluster-Rechenleistung könnte so auf über 70 % steigen.

Eine weitere Strategie zur Ressourcenschonung ist die asynchrone Abfrage, mit der die aktiven Zyklen batteriebetriebener Geräte bei intermittierenden Datenübertragungen minimiert werden. Dadurch wird die aktive Kommunikationszeit minimiert und der Gesamtstromverbrauch im Vergleich zur kontinuierlichen Abfrage in festen Intervallen gesenkt.

Schlussfolgerung

Auch wenn es zahlreiche Ansatzpunkte für Green Computing gibt, besteht ein besonders wichtiger Aspekt darin, die Rechenzentrumsstruktur kontinuierlich zu verbessern, um die Effizienz der Rechenleistung von der Erzeugung über die Übertragung bis hin zur Anwendung zu erhöhen. Die Hauptanforderung an die Systemhersteller besteht darin, das Design ihrer Systemarchitektur, die Leistungsoptimierung und die Wärmeableitung zu testen und zu verbessern. Einerseits können sie so den Energiebedarf der Rechner und die durch den Stromverbrauch verursachten Emissionen minimieren. Andererseits kann die erzeugte Rechenleistung so weit wie möglich auf der Anwendungsebene eingesetzt werden, um die Verschwendung von Rechenressourcen zu reduzieren. Die Unternehmen können also Kosten senken und ihrer Verantwortung für eine nachhaltige Entwicklung gerecht werden, indem sie bei der Auswahl der IT-Infrastrukturen Prioritäten setzen, die sowohl ihren Anforderungen an die betriebliche Effizienz als auch an die CO2-Emissionsvorschriften entsprechen.